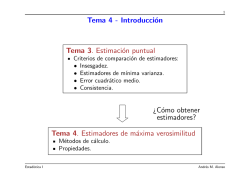

Tema 3 - Introducción Tema 2. Estimación puntual ¿Cómo obtener

1 Tema 3 - Introducci´ on Tema 2. Estimaci´ on puntual Criterios de comparaci´ on de estimadores: • Insesgadez. • Estimadores de m´ınima varianza. • Error cuadr´atico medio. • Consistencia. ¿C´ omo obtener estimadores? Tema 3. Estimadores de m´axima verosimilitud M´etodos de c´alculo. Propiedades. Estad´ıstica I Pedro Galeano 2 Tema 3. Estimadores de m´axima verosimilitud Los contenidos a desarrollar en este tema son los siguientes: Definici´ on y propiedades. T´ecnicas de c´alculo. Propiedades de los estimadores de m´axima verosimilitud en muestras grandes. Lecturas recomendadas: Secci´ on 7.6 del libro de Pe˜ na (2005). Estad´ıstica I Pedro Galeano 3 Ejemplo 1. Supongamos una empresa que desea determinar con que probabilidad el uso de campa˜ nas publicitarias produce aumentos en sus ventas. Para ello, toman una muestra aleatoria simple (m.a.s.) del total de campa˜ nas publicitarias realizadas y comprueban en qu´e ocasiones, estas campa˜ nas produjeron un aumento de sus ventas. Esta situaci´ on corresponde a una variable aleatoria con una distribuci´ on Bernoulli de par´ametro p. Entonces: X= 1 con probabilidad p 0 con probabilidad 1 − p donde X = 1 corresponde a la situaci´ on en que se produjo un aumento en las ventas (´ exito) y X = 0 corresponde a la situaci´ on en la que no se produjo dicho aumento (fracaso). Estad´ıstica I Pedro Galeano 4 Ejemplo 1. La probabilidad de ´exito es p, que es un valor desconocido. El objetivo es, una vez que hemos conocido los datos de una muestra aleatoria simple (m.a.s.), (x1, . . . , xn), estimar el verdadero valor de p mediante los datos. ¿C´ omo podemos hacer esto? Definici´ on 1. Sea (X1, X2, . . . , Xn) una muestra aleatoria simple de una poblaci´ on X con funci´ on de probabilidad Pθ (o con funci´ on de densidad fθ ) donde θ = (θ1, θ2, . . . , θk ) es un vector de par´ametros. La funci´ on de verosimilitud de la muestra (x1, x2, . . . , xn) es: L(x1, x2, . . . , xn; θ ) = Pθ (x1)Pθ (x2) . . . Pθ (xn), L(x1, x2, . . . , xn; θ ) = fθ (x1)fθ (x2) . . . fθ (xn). La funci´ on de verosimilitud L(x1, x2, . . . , xn; θ ) proporciona, para cada valor del vector de par´ametros θ = (θ1, θ2, . . . , θk ), la probabilidad de obtener la muestra (x1, x2, . . . , xn). Estad´ıstica I Pedro Galeano 5 Ejemplo 1. La funci´ on de probabilidad de una distribuci´ on Bernoulli de par´ametro p es: 1−x Pp (x) = px (1 − p) . Por lo tanto, la funci´ on de verosimilitud de una muestra (0, 1, 1, 0, 1) es: 2 L (0, 1, 1, 0, 1; p) = (1 − p) · p · p · (1 − p) · p = p3 (1 − p) que proporciona, para cada valor de p, la probabilidad de obtener la muestra (0, 1, 1, 0, 1). ¿Cual es el valor de p que proporciona la m´ axima probabilidad de obtener la muestra (0, 1, 1, 0, 1)? Estad´ıstica I Pedro Galeano 6 Función de verosimilitud de los datos de una Bernoulli 0.035 0.03 0.025 0.02 0.015 0.01 0.005 0 Estad´ıstica I 0 0.1 0.2 0.3 0.4 0.5 p 0.6 0.7 0.8 0.9 1 Pedro Galeano 7 Definiciones Definici´ on 2. Sea (X1, X2, . . . , Xn) una muestra aleatoria de una poblaci´ on X con funci´ on de verosimilitud L(x1, x2, . . . , xn; θ ) donde θ = (θ1, θ2, . . . , θk ) es un vector de par´ametros. Un estimador, θ = (θ1, θ2, . . . , θk ) es el estimador de m´ axima verosimilitud de θ si L(x1, x2, . . . , xn; θ ) = m´ ax L(x1, x2, . . . , xn; θ ), θ ∈Θ para cada (x1, x2, . . . , xn) ∈ X . Veros´ımil: 1. adj. Que tiene apariencia de verdadero. 2. adj. Cre´ıble por no ofrecer car´acter alguno de falsedad. Real Academia Espa˜ nola c Estad´ıstica I Pedro Galeano 8 Definiciones Por lo general, resulta m´as c´ omodo trabajar con ln fθ en lugar de con fθ , y buscamos el EMV mediante: ln L(x1, x2, . . . , xn; θ ) = m´ ax ln L(x1, x2, . . . , xn; θ ). θ ∈Θ La funci´ on (x1, x2, . . . , xn; θ ) = ln L(x1, x2, . . . , xn; θ ) recibe el nombre de funci´ on soporte. Si la funci´ on de verosimilitud es derivable respecto de θ entonces el sistema de ecuaciones de verosimilitud: ∂ (x1, x2, . . . , xn; θ ) = 0, para j = 1, 2, . . . , k, ∂θj proporcionan los m´aximos relativos de (x1, x2, . . . , xn, θ ). Candidatos a EMV Estad´ıstica I Pedro Galeano 9 Ejemplo 1. La funci´ on soporte de la muestra es: 2 (0, 1, 1, 0, 1; p) = ln p3 (1 − p) = 3 ln p + 2 ln (1 − p) . Entonces, la ecuaci´ on de verosimilitud es: 2 ∂ (0, 1, 1, 0, 1; p) 3 = − = 0, ∂p p 1−p de donde obtenemos el valor: p = 0,6. ¿Es un m´aximo? ∂ 2 (0, 1, 1, 0, 1; p) 3 2 25 50 125 =− 2− =− − =− < 0. 2 ∂ 2p p 3 4 6 (1 − p) |p=bp |p=b p Por lo tanto, como es un m´aximo, p = 0,6 es el estimador m´aximo verosimil. Estad´ıstica I Pedro Galeano 10 Ejemplo 2. Obtenemos el estimador m´aximo verosimil de una muestra (x1, . . . , xn) generada por una distribuci´ on exponencial de par´ametro λ. La funci´ on de densidad de una exponencial de par´ametro λ es: fλ (x) = λ exp (−λx) , λ > 0. La funci´ on de verosimilitud de una muestra (x1, . . . , xn) es entonces: n n λ exp (−λxi) = λn exp −λ L (x1, . . . , xn; λ) = i=1 xi . i=1 La funci´ on soporte es: n (x1, . . . , xn; λ) = n ln λ − λ xi. i=1 Estad´ıstica I Pedro Galeano 11 Derivando respecto a λ e igualando a 0, obtenemos: n ∂ (x1, . . . , xn; λ) n = − xi = 0 ⇐⇒ λ = ∂λ λ i=1 n . n i=1 xi ¿Es un m´aximo? ∂ 2 (x1, . . . , xn; λ) n n =− 2 = − < 0. b b ∂ 2λ λ |λ=λ |λ=λ λ2 Por lo tanto, λ = Estad´ıstica I Pnn i=1 xi es el estimador m´aximo verosimil de λ. Pedro Galeano 12 Propiedades de los EMV Principio de m´ axima verosimilitud: Si θ es el estimador m´aximo veros´ımil de θ , entonces µ = h(θ ) es el E.M.V. de µ = h(θθ ). Consistencia y distribuci´ on asint´ otica: Bajo ciertas condiciones: θ es un estimador consistente de θ . θ es asint´ oticamente normal: √ A n(θ − θ ) ∼ N (0, i(θθ )−1), donde: i(θθ ) = E ∂ ln fθ (X) ∂θθ 2 ∂2 = −E ln fθ (X) . ∂θθ 2 es la informaci´ on de Fisher correspondiente a una observaci´ on. Estad´ıstica I Pedro Galeano 13 Ejemplo 3. En el Ejemplo 2 obtuvimos que el EMV de λ es λ = 1/x. Obtengamos su distribuci´ on asint´ otica. Tenemos que: √ A n(λ − λ) ∼ N (0, i(λ)−1), donde: ∂ ln (λ exp (−λX)) ∂λ i(λ) = E =E Por lo tanto, 1 −X λ √ 2 = E X2 − 2 =E ∂ (ln λ − λX) ∂λ 2 = X 1 2 2 1 1 + 2 = 2 − 2 + 2 = 2. λ λ λ λ λ λ A n(λ − λ) ∼ N (0, λ2), o equivalentemente: √ Estad´ıstica I 2 λ A n( − 1) ∼ N (0, 1). λ Pedro Galeano 14 Propiedades de los EMV Dado que √ A −1 n θ − θ ∼ N 0, i (θθ ) , tenemos que equivalentemente: A −1 θ ∼ N θ , (ni (θθ )) . Insesgadez asint´ otica: E[θ ] → θ . Eficiencia asint´ otica: Var[θ ] → (n i(θθ ))−1. A veces, se escribe I(θθ )−1 = (n i(θθ ))−1. Estad´ıstica I Pedro Galeano 15 Ejemplo 4. Vamos a obtener el EMV de µ para una N µ, σ 2 suponiendo que σ 2 es conocida. La funci´ on de densidad es: 2 1 (x − µ) fµ (x) = √ exp − 2σ 2 2πσ . La funci´ on de verosimilitud de una muestra (x1, . . . , xn) es entonces: n 2 (xi − µ) 1 √ L (x1, . . . , xn; µ) = exp − 2 2σ 2πσ i=1 −n 2 = (2π) Estad´ıstica I σ n 2 −2 1 exp − 2 2σ = n 2 (xi − µ) . i=1 Pedro Galeano 16 La funci´ on soporte es: n n 1 2 (x1, . . . , xn; µ) = − ln 2π − ln σ − 2 2 2 2σ n 2 (xi − µ) . i=1 Derivando respecto a µ e igualando a 0: 1 ∂ (x1, . . . , xn; θ) = 2 ∂µ σ n 1 (xi − µ) = 2 σ i=1 1 ⇐⇒ µ = n n xi − i=1 nµ = 0 ⇐⇒ 2 σ n xi = x. i=1 ¿Es un m´aximo? ∂ 2 (x1, . . . , xn; µ) n = − < 0. 2 2 ∂ µ σ |µ=b µ Estad´ıstica I Pedro Galeano 17 Por lo tanto, µ = x es el EMV de µ. ¿Cual es la distribuci´ on asint´ otica? Tenemos: 1 1 (X − µ)2 fµ (X) = √ exp − 2 σ2 2πσ 1 1 1 2 ln fµ (X) = − ln 2π − ln σ 2 − 2 (X − µ) . 2 2 2σ Obtenemos la derivadas parciales respecto de µ: X −µ ∂ fµ (X) = . 2 ∂µ σ Estad´ıstica I Pedro Galeano 18 Entonces, i (µ) = E X −µ σ2 2 = 1 1 2 E (X − µ) = . 4 2 σ σ Por lo tanto, √ A n (µ − µ) ∼ N 0, σ 2 A ⇐⇒ µ ∼ N σ2 . µ, n Notar que en este caso la distribuci´ on es exacta por el Lema de Fisher. Estad´ıstica I Pedro Galeano 19 Recapitulaci´ on Tema 3. Estimadores de m´axima verosimilitud Definici´ on del estimador MV. T´ecnicas de c´alculo. ¿C´ omo obtener estimadores? Propiedades de los estimadores de MV en muestras grandes. • Insesgadez asint´ otica. • Asint´ oticamente de m´ınima varianza. • Consistentes. • Distribuci´ on asint´ otica normal. ¿Por qu´e elegir un EMV? Estad´ıstica I Pedro Galeano 20 Tema 2. Estimaci´ on puntual Tema 3. Estimadores de m´axima verosimilitud Generalizaci´ on Tema 4. Intervalos de confianza Definici´ on. Intervalos de confianza para medias y varianzas en poblaciones normales. Intervalos de confianza en muestras grandes. Determinaci´ on del tama˜ no muestral. Estad´ıstica I Pedro Galeano

© Copyright 2026