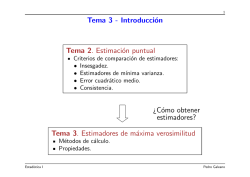

Tema 4 - Introducción Tema 3. Estimación puntual ¿Cómo obtener

1

Tema 4 - Introducci´

on

Tema 3. Estimaci´

on puntual

Criterios de comparaci´

on de estimadores:

• Insesgadez.

• Estimadores de m´ınima varianza.

• Error cuadr´atico medio.

• Consistencia.

¿C´

omo obtener

estimadores?

Tema 4. Estimadores de m´axima verosimilitud

M´etodos de c´alculo.

Propiedades.

Estad´ıstica I

Andr´es M. Alonso

2

Distribuci´

on temporal del temario

Tema 1

Tema 2

Tema 3

Tema 4

Tema 5

Tema 6

Tema 7

1

T

T

T

T

T

T

T

2

T

T

T

T

T

T

T

7

3

T

T

T

T

T

T

T

7

4

P

P

P

P

P

P

P

7

7

T denota una hora

de clase

de 0teor´ıa 7

0

0

5

6

7

8

9

T

T

T

T

T

T

T

T

T

T

T

T

T

T

T

T

T

T

P

P

P

P

P

P

P

P

P

P

P

P

6

0

6

0

6

0

6

6

6

6

P denota una hora de clase pr´actica

Estad´ıstica I

Andr´es M. Alonso

58

19

3

Tema 4. Estimadores de m´axima verosimilitud

Los contenidos a desarrollar en este tema son los siguientes:

Definici´

on y propiedades.

T´ecnicas de c´alculo.

Propiedades de los estimadores de m´axima verosimilitud en muestras

grandes.

Lecturas recomendadas: Secci´

on 7.6 del libro de Pe˜

na (2005).

Estad´ıstica I

Andr´es M. Alonso

4

Ejemplo 1. En una urna hay 4 bolas que pueden ser blancas o negras. La

proporci´

on, θ, de bolas blancas en la urna es desconocida y puede tomar valores

en Θ = {0, 1/4, 1/2, 3/4, 1}. Para obtener m´as informaci´

on extraemos de la

urna 2 bolas con reemplazamiento. Supongamos que la primera bola observada

es blanca (B) y la segunda es negra (N). Si calculamos la probabilidad de

obtener ese resultado para cada valor posible de θ obtenemos:

0

si θ = 0

3/16 si θ = 1/4

1/4 si θ = 1/2

Pr {B, N|θ} =

3/16 si θ = 3/4

0

si θ = 1

¿Qu´e valor de θ te resulta m´as veros´ımil?

Veros´ımil:

1. adj. Que tiene apariencia de verdadero.

2. adj. Cre´ıble por no ofrecer car´acter alguno de falsedad.

Real Academia Espa˜

nola c

Estad´ıstica I

Andr´es M. Alonso

5

Definiciones

Definici´

on 1. Sea (X1, X2, . . . , Xn) una muestra aleatoria de una poblaci´

on

X con funci´

on de probabilidad Pθ (o con funci´

on de densidad fθ ) donde

θ = (θ1, θ2, . . . , θk ) es un vector de par´ametros. La funci´

on de verosimilitud,

L(x1, x2, . . . , xn; θ ), de la muestra (x1, x2, . . . , xn) es la funci´

on de probabilidad

(o de densidad) de (X1, X2, . . . , Xn) evaluada en (x1, x2, . . . , xn).

Definici´

on 2. Sea (X1, X2, . . . , Xn) una muestra aleatoria simple de

una poblaci´

on X con funci´

on de probabilidad Pθ (o con funci´

on de

densidad fθ ) donde θ = (θ1, θ2, . . . , θk ) es un vector de par´ametros.

La funci´

on de verosimilitud de la muestra (x1, x2, . . . , xn) es:

L(x1, x2, . . . , xn; θ ) = Pθ (x1)Pθ (x2) . . . Pθ (xn),

o

Estad´ıstica I

L(x1, x2, . . . , xn; θ ) = fθ (x1)fθ (x2) . . . fθ (xn).

Andr´es M. Alonso

6

Ejemplo 1. Por simplicidad supondremos que θ toma valores en Θ =

{1/4, 1/2, 3/4}. Definimos la variable X que toma valor 1 si sale blanca

y 0 si sale negra.

(a) Escriba la funci´

on de verosimilitud en el caso de que las bolas se obtengan

con reemplazamiento (m.a.s.).

Definici´

on 2.

L(x1, x2; θ) = θx1 (1 − θ)1−x1

θx2 (1 − θ)1−x2 .

(b) Escriba la funci´

on de verosimilitud en el caso de que las bolas se obtengan

Definici´

on 1.

sin reemplazamiento (No es m.a.s.).

L(x1, x2; θ) = θx1 (1 − θ)1−x1

Estad´ıstica I

4θ − x1

3

x2

1−

4θ − x1

3

1−x2

Andr´es M. Alonso

7

Definiciones

Definici´

on 3. Sea (X1, X2, . . . , Xn) una muestra aleatoria de una poblaci´

on

X con funci´

on de verosimilitud L(x1, x2, . . . , xn; θ ) donde θ = (θ1, θ2, . . . , θk )

es un vector de par´ametros. Un estimador, θ = θ1, θ2, . . . , θk ) es el estimador

de m´

axima verosimilitud de θ si

L(x1, x2, . . . , xn; θ ) = m´

ax L(x1, x2, . . . , xn; θ ),

θ ∈Θ

para cada (x1, x2, . . . , xn) ∈ X .

Ejemplo 1. (c) Obtenga el estimador m´aximo veros´ımil (E.M.V.) de θ en el

caso de muestras con reemplazamiento.

L(x1, x2; θ) = θ(x1+x2)(1−θ)(2−x1−x2).

Tenemos que Θ = {1/4, 1/2, 3/4},

as´ı que bastar´a con evaluar la funci´

on

de verosimilitud en estos valores.

Estad´ıstica I

x1 + x2

θ

0.25

0.50

0.75

0

0.5625

0.2500

0.0625

1

0.1875

0.2500

0.1875

2

0.0625

0.2500

0.5625

Andr´es M. Alonso

8

Definiciones

A menudo resulta m´as c´

omodo trabajar con ln fθ en lugar de con fθ , y

buscamos el EMV mediante:

ln L(x1, x2, . . . , xn; θ ) = m´

ax ln L(x1, x2, . . . , xn; θ ).

θ ∈Θ

La funci´

on (x1, x2, . . . , xn; θ ) = ln L(x1, x2, . . . , xn; θ ) recibe el nombre de

funci´

on soporte.

Si la funci´

on de verosimilitud es derivable respecto de θ entonces el sistema

de ecuaciones de verosimilitud:

∂

(x1, x2, . . . , xn; θ ) = 0, para j = 1, 2, . . . , k,

∂θj

x, θ ).

proporcionan los m´aximos relativos de (x

Estad´ıstica I

Candidatos a EMV

Andr´es M. Alonso

9

Ejemplo 1. (d) Suponiendo que Θ = [0, 1], obtenga el estimador m´aximo

veros´ımil (E.M.V.) de θ en el caso de muestras con reemplazamiento.

(x1, x2; θ) = (x1 + x2) ln(θ) + (2 − x1 − x2) ln(1 − θ).

∂ (x1,x2;θ)

1

1

=

(x

+

x

)

−(2

−

x

−

x

)

1

2 θ

1

2 1−θ .

∂θ

Igualando a cero, obtenemos: θ =

x1+x2

2 .

¿Es el EMV?

(e) Obtenga la estimaci´

on m´aximo veros´ımil para la muestra x1 = 1 y x2 = 0.

Bastar´a evaluar el estimador obtenido: θ =

x1+x2

1

=

2

2.

Ejercicio: Apartados (c) y (e) con muestras sin reemplazamiento.

Estad´ıstica I

Andr´es M. Alonso

10

Ejemplo 2. Obtenga los E.M.V. de los par´ametros de las siguientes distribuciones suponiendo que dispone de una muestra aleatoria simple de tama˜

no

n:

X ∼ Bernoulli(p).

X ∼ N (µ, σ 2) con σ conocida.

X ∼ Poisson(λ).

X ∼ N (µ, σ 2) con µ conocida.

X ∼ Exponencial(λ).

X ∼ N (µ, σ 2).

Ejemplo 3. Obtenga el E.M.V. para el par´ametro θ de una distribuci´

on

U(0, θ).

Estad´ıstica I

Andr´es M. Alonso

11

Propiedades de los EMV

Principio de m´

axima verosimilitud: Si θ es el estimador m´aximo veros´ımil

de θ, entonces µ = h(θ) es el E.M.V. de µ = h(θ).

Consistencia y distribuci´

on asint´

otica:

Bajo ciertas condiciones, se tiene que:

θ es un estimadores consistente de θ.

θ es asint´

oticamente normal:

√

A

n(θ − θ) ∼ N (0, i(θ)−1),

2

∂

donde i(θ) = E ∂θ

ln f (X; θ)

es la cantidad de informaci´

on de

Fisher correspondiente a una observaci´

on.

Estad´ıstica I

Andr´es M. Alonso

12

Ejemplo 4. (a) Obtenga el EMV del par´ametro θ = e−λ = Pr(X = 0) de

una distribuci´

on P oisson(λ) si dispone de una m.a.s. de tama˜

no n.

En el Ejemplo 2 obtuvimos que el EMV de λ es λ = x

¯, entonces, por el

principio de verosimilitud, el EMV de θ es: θ = e−λ = e−¯x.

(b) Obtenga la distribuci´

on asint´

otica de λ.

Tenemos que

i(λ) = E

= E

Finalmente,

Estad´ıstica I

√

√

A

n(λ − λ) ∼ N (0, i(λ)−1),

∂

λX e−λ

ln

∂λ

X!

X

−1

λ

2

2

=E

donde

∂

(X ln λ − λ − ln X!)

∂λ

2

X2

X

λ + λ2

λ

1

=E 2 −2 +1 =

−2 +1= .

λ

λ

λ2

λ

λ

A

n(λ − λ) ∼ N (0, λ).

Andr´es M. Alonso

13

(c) Obtenga la distribuci´

on asint´

otica de θ.

Tenemos que

A

n(θ − θ) ∼ N (0, i(θ)−1),

λX e−λ

∂

ln

∂θ

X!

i(θ) = E

2

=E

donde

∂

(− ln(θ))X θ

ln

∂θ

X!

∂

(X ln(− ln(θ)) + ln(θ) − ln X!)

∂θ

= E

=

√

2

=E

2

1

1

X

+

θ ln θ

θ

2

1

− ln θ + ln2 θ

1

1

λ + λ2

λ

ln θ

+

2

+

=

−

2

+

=

−

.

2

2

2

2

2

2

2

2

2

θ ln θ θ

θ ln θ θ

θ ln θ

θ ln θ

θ ln θ

Finalmente,

√

A

n(θ − θ) ∼ N (0, −θ2 ln θ).

La informaci´

on de Fisher tambi´en puede calcularse mediante:

∂2

i(θ) = −E

ln f (X; θ) .

2

∂θ

Estad´ıstica I

Andr´es M. Alonso

14

Propiedades de los EMV

Insesgadez asint´

otica:

E[θ] → θ.

Eficiencia asint´

otica:

A

Var[θ] = 1/E

∂

X ; θ)

ln f (X

∂θ

2

= I(θ)−1 = (n i(θ))−1.

Cota de Frechet–Cramer–Rao.

Var(ϑ) ≥ I(θ)−1,

donde ϑ es un estimador centrado cualesquiera e I(θ) es la

informaci´

on de Fisher de una muestra de tama˜

no n.

Estad´ıstica I

Andr´es M. Alonso

15

Ejemplo 5. Supongamos que los rendimientos de las acciones de la empresa

SEGURA.SL siguen una distribuci´

on normal de media µ euros y varianza σ 2. Se

toma una m.a.s. de 20 rendimientos y se tiene:

5,29 3,66 5,71 6,62 4,30 5,85 6,25 3,40 3,55 5,57

4,60 5,69 5,81 5,71 6,29 5,66 6,19 3,79 4,98 4,84

(a) Calcular los valores de los estimadores m´aximo veros´ımiles de µ y σ en esa

muestra.

En el Ejemplo 2 obtuvimos que el EMV de (µ, σ 2) es (¯

x, s2), entonces, por el

principio de verosimilitud, tenemos que (µ, σ) = (¯

x, s).

x

¯=

s=

1

(5,29 + 3,66 + · · · + 4,84) = 5,188,

20

1

((5,29 − 5,188)2 + (3,66 − 5,188)2 + · · · + (4,84 − 5,188)2) ≈ 0,9712.

20

Estad´ıstica I

Andr´es M. Alonso

16

Ejemplo 5. (b) El VaR (value at risk) es una medida de la m´axima p´erdida esperada en una cartera, durante per´ıodo de tiempo espec´ıfico con una

probabilidad dada, α. Una manera de calcular el VaR es suponiendo que los

beneficios diarios de un valor se distribuyen de acuerdo a la distribuci´

on normal.

Esta simplificaci´

on permiti´

o un importante avance de la teor´ıa de carteras, y es

frecuentemente empleada en c´alculos estad´ısticos financieros.

La empresa SEGURA.SL considera como p´erdidas todos los rendimientos inferiores a 5 euros por acci´

on. Es decir, los beneficios siguen una distribuci´

on

N (µ − 5, σ 2). En ese caso, las p´erdidas m´aximas esperadas para un nivel α

son:

V aR = µ − 5 − zασ.

Obtenga la distribuci´

on asint´

otica del estimador

V aR = µ − 5 − zασ.

Estad´ıstica I

Andr´es M. Alonso

17

En primer lugar, obtenemos la distribuci´

on de (µ, σ).

Tenemos,

1

1 (x − µ)2

f (x) = √

exp −

2 σ2

2πσ

√

1 (x − µ)2

.

ln f (x) = − ln 2π − ln σ −

2 σ2

Obtenemos la derivadas parciales respecto de µ y σ:

∂

(x − µ)

ln f (x) =

∂µ

σ2

∂

1

(x − µ)2

ln f (x) = − −

∂σ

σ

σ3

y la matriz de segundas derivadas (Jacobiano):

∂2

∂µ∂µ

∂2

∂σ∂µ

Estad´ıstica I

ln f (x)

ln f (x)

∂2

∂µ∂σ

∂2

∂σ∂σ

ln f (x)

ln f (x)

=

−2 (x−µ)

σ3

− σ12

−2 (x−µ)

σ3

1

σ2

−

(x−µ)2

3 σ4

.

Andr´es M. Alonso

18

Obtenemos la matriz de informaci´

on:

1

σ2

2 (X−µ)

σ3

i(θ) = i(µ, σ) = E

2 (X−µ)

σ3

− σ12

=

(X−µ)2

3 σ4

+

1

σ2

0

− σ12

,

σ2

0

0

σ2

+ 3 σ4

y la distribuci´

on de (µ, σ) es:,

√

n

µ

σ

−

µ

σ

A

−1

∼ N (00, i(θ)

)=N

Finalmente, como V aR = µ − 5 − zασ = [1, −zα]

√

Estad´ıstica I

n V aR − V aR

A

∼ N

2

0, σ +

0

0

µ

σ

σ

zα2

0

σ2

2

.

− 5, obtenemos:

2

2

.

Andr´es M. Alonso

19

Recapitulaci´

on

Tema 4. Estimadores de m´axima verosimilitud

Definici´

on del estimador MV.

T´ecnicas de c´alculo.

¿C´

omo obtener

estimadores?

Propiedades de los estimadores de MV

en muestras grandes.

• Insesgadez asint´

otica.

• Asint´

oticamente de m´ınima varianza.

• Consistentes.

• Distribuci´

on asint´

otica normal.

¿Por qu´e elegir un EMV?

Estad´ıstica I

Andr´es M. Alonso

20

Tema 3. Estimaci´

on puntual

Tema 4. Estimadores de m´axima verosimilitud

Generalizaci´

on

Tema 5. Intervalos de confianza

Definici´

on.

Intervalos de confianza para medias y varianzas en

poblaciones normales.

Intervalos de confianza en muestras grandes.

Determinaci´

on del tama˜

no muestral.

Estad´ıstica I

Andr´es M. Alonso

© Copyright 2026