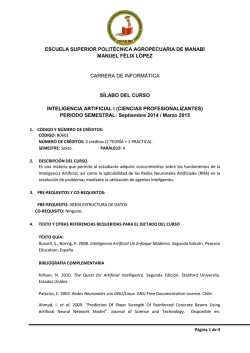

Capítulo 1 - Departamento de Informática USM

INTRODUCCIÓN A REDES

NEURONALES ARTIFICIALES TEORÍA

Y APLICACIONES

Dr. Héctor Allende

Departamento de Informática

Universidad Técnica Federico Santa María

Capítulo 1

Basic Neural Dynamics

The ANN Books

R.M. Kristev 1998

http://www.inf.utfsm.cl/~hallende/

redes neuronales/novedades

FAQ NN: "ftp://ftp.sas.com/pub/neural/FAQ.html"

Profesor: Héctor

Allende

Redes Neuronales Artificiales

2

Inteligencia Computacional ?

Computational Intelligence

• Combinación:

– Ciencias de la Computación

– Neuro-Fisiología

– Filosofía (Teoría del conocimiento y lógica)

Creación de Máquinas que puedan

Pensar en el sentido del test de Turin

Corteza Cerebral Humana:

11

• Aproximadamente 10

neuronas

• 1000 a 10.000 Synapsis por neurona

• Comunicación tren de impulsos electroquimicos ( mensaje modulado)

• Proceso Cognitivo

tiempo (milisegundos)

Operación Masiva Paralela

Secuencial en 100 Etapas

Célula Nerviosa

Soma:

Dendritas:

Axón:

Sinapsis:

Info. Hereditaria + Plasma +

Generación Señales

Recepción Señales Impulsos

Transmisión de Señales

Interfaz Neuronal (Inhibitoria, Excitatoria)

Breve Historia

•1943 W.McCulloch, W. Pitts: Modelo ANN ( El Perceptrón )

•1959 Bernard Widrow ( SU): Filtro Adaline (Adaptative Linear

Neuron) y el Madaline (Multiple Adaline) Basado en ( ANN)

•1969 Minsky y Papert: El Perceptrón (limitaciones).

•1982 J. Hopfield: Memoria Asociativa ”Redes de Hopfield".

•1986 Rumulhart, Hunton y Williams : redescubren el BPL

algoritmo de "back-propagation learning" ( Paul Werbor, 1974)

•1989 K. Hornik, M. Stinchcombe, H. White: Multi-FANN y

Aproximación Universal

Profesor: Héctor Allende

Redes Neuronales Artificiales

6

Red neuronal artificial (ANN)

ANN: Es un sistema dinámico compuesto por redes

paralelas y distribuidas de procesadores elementales, con

la capacidad de aprender y almacenar “conocimiento”.

•Arquitectura

•Interacción

•Función de proceso

ANN: SM sobre-parametrizado

Profesor: Héctor Allende

Redes Neuronales Artificiales

7

Aplicaciones de las ANN

•

•

•

•

•

•

•

Resolver problemas Complejos

Hacer generalizaciones

Establecer Relaciones no evidentes

Análisis de sistemas complejos

Percepción

Comprensión y Aprendizaje

Generación de nuevo conocimiento

Aplicaciones de las ANN

•

•

•

•

•

•

•

Telecomunicaciones

Informática

Minería

Energía

Finanzas

Transporte

Salud

Aplicaciones de las ANN

•

•

•

•

•

•

•

Clasificación

Pre-procesamiento de datos

Reconocimiento de patrones

Aproximación de funciones

Predicción de Series de Tiempo

Optimización Combinatorial

Control

Modelo Neuronal:

Mc Culloch & Pitts 1943

w1i

0

1

xi(t) =1

Profesor: Héctor Allende

bi

...

0

1

0

1

xi(t)

w ni

n

w xj(t-1)

j=1

ij

-

bi

Redes Neuronales Artificiales

11

ANN y Neuronales Biológicas

Neurona y Conecciones Sinápticas

Procesador Elemental

Neuronas: El aprendizaje se produce mediante la variación de la

efectividad de las sinapsis, de esta manera cambia la influencia que unas

neuronas ejercen sobre otras.

ANN: La regla de aprendizaje usada indica como se ajustan los pesos de

las conexiones en función del vector entrada

Profesor: Héctor Allende

Redes Neuronales Artificiales

12

Analogías

Células Biológicas

Redes Neuronales Artificiales

Neuronas

Unidades de proceso

Conexiones Sinápticas

Conexiones Ponderadas

Efectividad de las Sinapsis

Peso de las conexiones

Efecto exitatorio o inhibitorio

Signo del Peso

Estimulo Total

Entrada total Ponderada

Activación Tasa de disparo

Función de Activación Salida

Profesor: Héctor Allende

Redes Neuronales Artificiales

13

Procesador Elemental.

PE: Es una unidad básica de procesamiento

la que posee múltiples entradas y solo una salida.

– Cada entrada xi es ponderada por un factor (peso) wi

y se calcula la suma ponderada de las entradas:

w x

i i

a netai

i

– Luego es aplicada una transformación mediante la

función de activación :

salida f (a)

Profesor: Héctor Allende

Redes Neuronales Artificiales

14

Procesador elemental.

xi

a=netai

wi

f

Input

Output

Unidad de

agregación

Profesor: Héctor Allende

f(a)

Unidad de

Activación

Redes Neuronales Artificiales

15

Procesador elemental.

• ANN Feedforward: Se construye colocando las

neuronas en capas y conectando las salidas de una

capa con las entradas de las neuronas de la

próxima capa.

• Capas de una red:

– Capa de entrada Zona sensorial ( S)

– Capa de salida Zona de Respuesta ( R)

– Capas ocultas Zona de asociación ( A)

Profesor: Héctor Allende

Redes Neuronales Artificiales

16

ANN: Aprendizaje y Generalización Métodos Actuales

Tipos de Aprendizaje

Supervisado

No - Supervisado

Híbridos

FeedForward

Tipos de Arquitectura

Single, Multiple

Recurrentes

Tipos de Función de Transición: deterministas, probabilistas

Tipo de Algoritmo de Aprendizaje: BPL, PPL, LM, etc

Profesor: Héctor Allende

Redes Neuronales Artificiales

17

Feedforward Neural Network

Profesor: Héctor Allende

Redes Neuronales Artificiales

18

Redes Feedforward

• FANN La capa 0 no realiza procesamiento alguno, solo distribuye

las entradas a la capa siguiente

S

x1

Profesor: Héctor Allende

Redes Neuronales Artificiales

x2

19

Modelo de Turing

xi(0) {0,1}

n

xi(t) =1 wij xj(t-1)

-

bi

j=1

i=1,...,n

W (conectividad de la NN)

b = (bi ) vector de umbrales

Profesor: Héctor Allende

Redes Neuronales Artificiales

wij

20

Arquitectura

En función de la conectividad de las capas, podemos hablar de redes

recurrentes (feed-back) y redes no recurrentes o redes en cascada (feedforward).

Lo más usual es disponer las unidades en forma de capas, pudiéndose

hablar de redes de una capa oculta, o de más de dos capas ocultas (redes

multicapa

Profesor: Héctor Allende

Redes Neuronales Artificiales

21

Neuronas y Redes simples.

• ANN Recurrente: La salida de una neurona

es la entrada de neuronas de capas

anteriores (feedback).

• Feedback lateral: La salida de una neurona

es la entrada de otra neurona en la misma

capa.

Profesor: Héctor Allende

Redes Neuronales Artificiales

22

Neuronas y Redes simples.

• Parámetros de la Red: Los pesos {wi}.

• Aprendizaje o entrenamiento: Es el

procedimiento mediante el cual los pesos

son ajustados.

• Conjunto de entrenamiento: Conjunto de

datos que consiste vectores de entrada

asociado con vectores de salida

deseada:{(xi,yi)}.

Profesor: Héctor Allende

Redes Neuronales Artificiales

23

Neuronas como funciones

• Las neuronas transforman una entrada no

acotada x(t) en el tiempo t en una señal de

salida acotada f(x(t)).

• La función de activación o función de señal: f

• Velocidad de la señal:

f df da f ' a

da dt

Profesor: Héctor Allende

Redes Neuronales Artificiales

24

Funciones de Activación

Funciones

Tipo Sigmoide

Funciones

Base Radial

Profesor: Héctor Allende

Redes Neuronales Artificiales

25

Funciones de activación comunes

• Función de activación logística:

1

f (a)

ca

1 e

– Es monótamente creciente para c >0

df

f '

cf (1 f ) 0

da

Profesor: Héctor Allende

Redes Neuronales Artificiales

26

Funciones de activación comunes

Profesor: Héctor Allende

Redes Neuronales Artificiales

27

Funciones de activación comunes

• Tangente hiperbólica:

e ca e ca

f (a) tanh( ca) ca

e e ca

donde c>0.

f ' c(1 f ) 0

2

Profesor: Héctor Allende

Redes Neuronales Artificiales

28

Funciones de activación comunes

• Threshold (umbral)

1

1 si a c

f (a ) 0 si a 0

ca e.t.o.c.

c>0

0

f ' (a)

c

Profesor: Héctor Allende

si a (,0) (1 / c, )

etoc

Redes Neuronales Artificiales

29

Funciones de activación comunes

• Distribución exponencial:

f (a) max( 0.,1 e ca )

c>0.

f ' (a) ce ca

a0

f ' ' c 2e ca

Profesor: Héctor Allende

Redes Neuronales Artificiales

30

Funciones de activación comunes

• Razón polinomial:

n

a

f (a) max 0.,

n

ca

c0

n 1

cna n 1

f '

n 2

(c a )

Profesor: Héctor Allende

Redes Neuronales Artificiales

31

Funciones de activación comunes

• Pulse-coded: Consiste en un tren de pulsos

exponencialmente ponderados

t

f (t )

g ( s )e

s t

ds

1

g (t )

0

Profesor: Héctor Allende

si el pulso ocurre en t

e.t.o.c

Redes Neuronales Artificiales

32

NN: Preguntas Abiertas

• Tamaño de las muestras

• Cuántas Neuronas

• Cuantas Capas

• Tipo de Arquitectura ( Selección del Modelo ANN)

• Tipo de Aprendizaje

• Algoritmos de Aprendizaje

• ¿Cuándo usar ANN

Profesor: Héctor Allende

Redes Neuronales Artificiales

Modelador

33

Aplicaciones NN

• Optimización Combinatorial

• Aprendizaje y Generalización:

– Memorias Asociativas (Básico)

– Redes Multicapas

• Pattern Recognition

– Predicción y Pronósticos

– Aproximación de Funciones

• Modelos de Difusión de Información

• Arquitecturas Paralelas

Profesor: Héctor Allende

Redes Neuronales Artificiales

34

Test de Turing:

“Un computador merece ser

llamado inteligente si puede

hacer pensar a un ser humano

que es otro ser humano”

Estructura y Formas de Conexión

Función de Activación

Se suele distinguir entre funciones lineales, en las que la salida es proporcional

a la entrada; funciones de umbral, en las cuales la salida es un valor discreto (típicamente

binario 0/1) que depende de si la estimulación total supera o no un determinado valor de

umbral; y funciones no lineales, no proporcionales a la entrada.

Caracteristicas

Aprendizaje inductivo

Generalización

.Abstracción tolerancia al ruido:

Procesamiento paralelo

Memoria Distribuida

Redes Asincronicas v/s Sincronicas

Metodos deterministas v/s Estaticos

Profesor: Héctor Allende

Redes Neuronales Artificiales

36

Funcionamiento Basico

La arquitectura más usada en la actualidad de una red neuronal consistiría en:

•Una primera capa de entradas, que recibe información del exterior.

•Una serie de capas ocultas (intermedias), encargadas de realizar el trabajo de la red.

•Una capa de salidas, que proporciona el resultado del trabajo de la red al exterior.

El número de capas intermedias y el número de neuronas de cada capa dependerá del

tipo de aplicación al que se vaya a destinar la red neuronal.

Profesor: Héctor Allende

Redes Neuronales Artificiales

37

© Copyright 2026