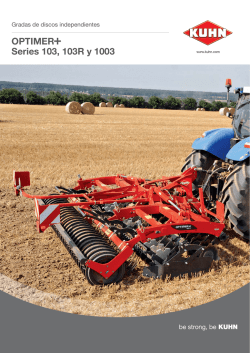

Descargar el libro en PDF