ValidaCión de pruebas diagnóstiCas

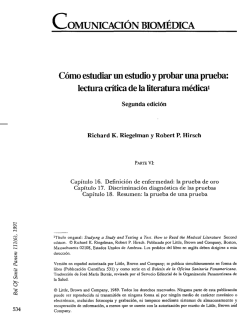

Capítulo 9 Validación de pruebas diagnósticas Miguel Cordero Coma, Raquel Salazar Méndez 1. Introducción 2. Validez interna de un test diagnóstico a) Sensibilidad b) Especificidad c) Balance entre sensibilidad y especificidad d) Las razones de probabilidad 3. Uso de test múltiples a) Test secuenciales b) Test simultáneos c) ¿Cómo los aplicamos? 4. Valores predictivos a) Valor predictivo positivo b) Valor predictivo negativo c) Relación con la prevalencia y la especificidad 5. Reproducibilidad del test historia clínica (3). No obstante, con mucha frecuencia precisamos de diversas herramientas que orienten y confirmen nuestras sospechas. Decidir qué pruebas solicitar y más aún, cómo interpretarlas, son, cada día, las preguntas más frecuentes y difíciles de contestar (3). Desgraciadamente, con una frecuencia mayor de la deseada, resolvemos estas eternas dudas solicitando un sinfín de baterías y test diagnósticos, que no sólo son costosos sino que nos sobrecargan de información irrelevante (3). A la hora de decidir qué pruebas solicitar y cómo interpretarlas, hemos de plantearnos una serie de cuestiones acerca de la validez de dicha prueba, basándonos fundamentalmente en su sensibilidad, especificidad y probabilidad pre- y postprueba; así como evaluar su reproducibilidad (4-7). Estos mismos conceptos son los que en el campo de la investigación clínica nos permiten validar un test diagnóstico. 6. Odds preprueba y postprueba 2. VALIDEZ INTERNA DE UN TEST DIAGNÓSTICO 1. INTRODUCCIÓN Según la Real Academia de la Lengua Española, el diagnóstico se define como el arte o acto de conocer la naturaleza de una enfermedad mediante la observación de sus síntomas y signos (1). Representa quizás la parte más importante de nuestra profesión y la clave que orienta nuestras decisiones terapéuticas. El diagnóstico no deja de ser una hipótesis derivada de nuestras observaciones y obtener una certeza absoluta resulta una meta inalcanzable (2). Una correcta, completa y dirigida anamnesis representa la piedra angular sobre la que establecer nuestras presunciones diagnósticas, de tal forma que casi el 90% de los diagnósticos que se realizan a diario en la práctica médica proceden exclusiva o fundamentalmente de la La validez interna de un test se define como su capacidad para distinguir entre aquellos sujetos afectados por la enfermedad o condición a estudio y aquellos que no lo están (7). Como vimos en el capítulo 8 acerca de la elección de variables, corresponde al grado en que los resultados de la medición se ajustan al fenómeno real que se mide (la «verdad») (5). Está determinada por dos componentes: la sensi- 74 9. Validación de pruebas diagnósticas bilidad (que representa su capacidad para identificar correctamente a los enfermos con un resultado positivo en la prueba) y la especificidad (o habilidad para discriminar como tales a los sanos por medio de un resultado negativo) (7,8). Para conocer los valores de estos indicadores de validez interna es preciso comparar los resultados obtenidos mediante la prueba a estudio con aquellos procedentes de la aplicación del gold-standard (o prueba de referencia), que asumimos como una fuente externa de verdad. El gold-standard constituiría para cada patología específica el mejor método disponible para su diagnóstico, permitiendo, al menos teóricamente, detectar todos los casos (enfermos) como positivos y todos los controles (sanos) como negativos (7,8). Podemos representar los datos obtenidos en la prueba de forma esquemática en una tabla 2x2 (tabla I). Tabla I. Tabla de contingencia 2x2 Enfermo Sano Total Test positivo a (VP) b (FP) a+b (VP+FP) Test negativo c (FN) d (VN) c+d (FN+VN) a+c (VP+FN) b+d (FP+VN) a+b+c+d (VP+FP+ FN+VN) Total De acuerdo con los datos recogidos en la tabla, podremos clasificar a todos los sujetos estudiados en cuatro grupos, en función de los resultados obtenidos: 1. Verdaderos positivos (VP): enfermos identificados como tales en la prueba a estudio por medio de un resultado positivo. 2. Falsos positivos (FP): sanos incorrectamente identificados por la prueba con un resultado positivo. 3. Falsos negativos (FN): enfermos incorrectamente clasificados por la prueba con un resultado negativo. 4. Verdaderos negativos (VN): sanos correctamente identificados como tales en la prueba con un resultado negativo. a) Sensibilidad La sensibilidad (S) indica la proporción del total de enfermos que el test es capaz de detectar (5,6). Según la tabla de contingencia se expresaría como: a S = ––––––––– a+c b) Especificidad La especificidad (E) indica la proporción de sujetos sanos confirmados como tales con un resultado negativo de la prueba (5). De acuerdo con la tabla de contingencia, se expresaría como: d E = ––––––––– b+d c) Balance entre sensibilidad y especificidad Idealmente, ambos parámetros deberían ser estables si las condiciones en las que se valoraran fueran absolutamente uniformes. Desgraciadamente no es así, y cuando un nuevo test diagnóstico sale al mercado, con frecuencia su sensibilidad y especificidad son variables según las condiciones de su aplicación (5). En general se asume una cierta relación inversa entre ambos parámetros, de tal forma que la mejora en uno de ellos empeora las cifras del otro, si bien es cierto que ciertas pruebas disponen de una alta sensibilidad y especificidad, como sucede con los instrumentos diagnósticos en el VIH (5). En la práctica, no siempre los resultados de las pruebas son categóricos (positivo o negativo), sino que con frecuencia se expresan como variables cuantitativas continuas. ¿Qué sucede cuando el resultado de la prueba no es un sí o un no, sino un valor numérico? En este caso la decisión de tratar o no al paciente, dependerá del establecimiento previo de un punto de corte que nos permita clasificar cada caso como positivo o negativo. Definir un punto de corte alto supondrá un incremento de la especificidad en detrimento de la sensibilidad (es decir, detectaremos correctamente los casos negativos, pero perderemos muchos casos positivos por el camino) (5). Por el contrario, establecer un punto de corte bajo comprometerá la especificidad en favor de la sensibilidad. Así, el dilema sobre el punto de corte (alto o bajo), debe resolverse tras considerar las implicaciones de los resultados FP y FN (4,7). Por ejemplo, no es lo mismo aplicar un cierto punto de corte de presión intraocular a una población de pacientes con alta sospecha de glaucoma (por tener más factores de riesgo, por ejemplo antecedentes familiares), que hacerlo en la comunidad general, donde no se debe sacrificar la especificidad por el riesgo de aumentar los FP y así la carga sanitaria (5). En general, se recomienda elegir una prueba sensible (punto de corte bajo) cuando la enfermedad es grave, no debe permanecer ignorada y es tratable o cuando no siéndolo, existe riesgo de 75 9. Validación de pruebas diagnósticas transmisión (por ejemplo, la sífilis) (5). Las pruebas altamente específicas (punto de corte alto) son de elección cuando la enfermedad es grave y difícilmente tratable o cuando el hecho de saberse no afectado por la enfermedad posee importancia sanitaria o psicológica (por ejemplo, un tumor) (5). Por último, las pruebas altamente eficientes (elevada sensibilidad y especificidad) serán precisas en aquellos casos en los que el tratamiento de los FP o la negligencia de un resultado FN tuvieran consecuencias catastróficas (6). Las curvas ROC (del inglés «receiver operating characteristic») facilitan la elección de puntos de corte, permiten comparar pruebas diagnósticas de forma gráfica y conocer la capacidad diagnóstica global de una prueba a lo largo de todo su espectro de valores (5). En ellas se representa la sensibilidad en ordenadas y el complementario de la especificidad (1-E) en abscisas (5,6). El área bajo la curva representa todos los diagnósticos correctos (VP y VN), quedando los incorrectos (FP y FN) por encima. Así, cuanto mayor es el área, mejor y más exacta será la prueba (5). d) Las razones de probabilidad o verosimilitud Relacionan la sensibilidad con la especificidad, comparando la probabilidad de que un resultado provenga de un enfermo respecto de un sano. Como la misma sensibilidad y especificidad, tampoco dependen de la prevalencia de la condición que se estudia. La razón de probabilidad positiva (RPP) expresa el número de veces que resulta más probable que un resultado positivo provenga de un enfermo respecto de un sano por lo que, lógicamente, interesa que sea un valor alto (6). Se expresa como: S RPP = –––––––– 1–E La razón de probabilidad negativa (RPN) por su parte, expresa, el número de veces que es más probable que un resultado negativo provenga de un enfermo que de un sano, por lo que en este caso interesa que sea un valor bajo (6). Se expresa como: 1–S RPN = ––––––––– E 3. USO DE TEST MÚLTIPLES a) Test secuenciales En los test secuenciales se aplica una primera prueba (test A), reservándose la segunda (test B), habitualmente más invasiva y/o costosa pero más sensible y específica, sólo para aquellos sujetos con un resultado positivo en la primera prueba. Al calcular la sensibilidad y especificidad globales de ambas, observaremos una pérdida de la sensibilidad neta frente a un incremento de la especificidad (fig. 1) (7). Los test secuenciales o en serie (como sucede en el diagnóstico del VIH) mejoran la especificidad al afinarse Fig. 1: Test secuenciales: cálculo de sensibilidad y especificidad netas. 76 9. Validación de pruebas diagnósticas los resultados positivos de la primera prueba con la aplicación de una segunda (se reducen los FP aunque no se descubren casos adicionales). b) Test simultáneos En el caso de los test simultáneos o paralelos, a cada paciente se le aplicarán al mismo tiempo, ambas pruebas (test A y test B). El cálculo de la sensibilidad y especificidad globales revelará el efecto inverso, es decir, una ganancia de la sensibilidad neta en detrimento de la especificidad (figs. 2 y 3) (6,7). c) ¿Cómo los aplicamos? En la práctica diaria con frecuencia recurrimos a la solicitud de múltiples baterías de forma simultánea para certificar o descartar nuestra sospecha. En tal caso, entendemos que es preciso obtener un resultado positivo en ambas pruebas para considerar al individuo como enfermo. Del mismo modo, sólo lo consideraremos definitivamente sano si en ambas pruebas el resultado es negativo. En el caso de los test secuenciales, por el contrario, sólo sometemos a la segunda prueba a aquellos individuos con un resultado positivo en la prueba inicial, lo que supone una pérdida de sensibilidad a favor de la especificidad. Ejemplo 9.1 E n la práctica diaria recurrimos con frecuencia a la realización de pruebas de forma secuencial, como sucede en el caso de la sífilis. Los test no treponémicos o inespecíficos (RPR, VDRL) son baratos y rápidos de realizar, por lo que se utilizan como pruebas de screening. Precisan entre 1-2 semanas tras el contacto para positivizarse, detectándose luego en el 99% de los pacientes con sífilis secundaria (9). Su reactividad disminuye posteriormente, siendo positivos en sólo el 70% de los pacientes con formas de sífilis terciaria (neurosífilis o sífilis cardiovascular). Además, se negativizan tras un tratamiento adecuado al cabo de 6-12 meses y existen diversas causas de resultados FP como infecciones por otras espiroquetas o enfermedades del tejido conectivo (10). Por su parte, los test treponémicos (FTA.ABS, TPH, TP.PA) detectan anticuerpos específicos frente a polipéptidos de Treponema pallidum, lo que les permite confirmar los resultados positivos obtenidos con las pruebas de screening. Comparativamente, son test más específicos y sensibles, pero también más caros y más difíciles de realizar técnicamente. Pese a sus ventajas, también presentan diversas causas de resultados FP como sucede en los pacientes con lupus, cirrosis biliar o artritis reumatoide, entre otros (10). Aunque la sensibilidad del VDRL es del 99% en pacientes con sífilis secundaria (9), todo resultado positivo precisará de su confirmación posterior con un test treponémico. En el caso de formas terciarias o latentes tardías, dada la relativa baja sensibilidad de los test no treponémicos, se solicitará siempre una prueba treponémica de confirmación (11). La pregunta lógica que nos hacemos es cómo aplicar las herramientas de las que disponemos: ¿de forma secuencial o simultánea? Y también, ¿cómo interpretar en cada caso los resultados obtenidos? La decisión de usar los test de una u otra forma estará basada en los objetivos pretendidos con la prueba (no es lo mismo un test empleado como herramienta de screening que aquel con la finalidad de proporcionar una confirmación diagnóstica) así como en las consideraciones sobre los costes de la prueba (parece recomendable limitar aquellas más costosas sólo a individuos con una prueba previa positiva), su grado de invasividad (tampoco parece lógico recurrir a pruebas con alto riesgo de complicaciones para el sujeto de forma rutinaria o simultánea), o el contexto clínico en el que se realiza (no es lo mismo una prueba empleada sobre un grupo de enfermos que aquella que se va a aplicar a una comunidad) (7). 4. VALORES PREDICTIVOS Hasta ahora sólo nos hemos preguntado por la capacidad del test para distinguir adecuadamente a los sujetos enfermos de los sanos. No obstante, también nos planteamos otra pregunta igual de importante, pero más enfocada a la práctica clínica: ¿si el resultado de la prueba es positivo, qué probabilidad tiene el paciente de tener verdaderamente la enfermedad? 9. Validación de pruebas diagnósticas Fig. 2: Test simultáneos: cálculo de sensibilidad neta. Fig. 3: Test simultáneos: cálculo de especificidad neta. 77 78 A esta pregunta nos dan respuesta el valor predictivo positivo (VPP) y negativo (VPN). a) Valor predictivo positivo Expresa la probabilidad de que un sujeto con un resultado positivo tenga realmente la enfermedad (5,6). Es el parámetro más interesante a la hora de seleccionar un test de screening, de tal forma que una prueba con un alto VPP reducirá el número de casos FP y así, los gastos derivados de otras pruebas confirmatorias, por otro lado innecesarias (5,6). Se calcula como: a VPP = ––––––––– a+b b) Valor predictivo negativo Expresa la probabilidad de que un individuo con un resultado negativo en la prueba esté verdaderamente sano (5,6). De nuevo según la tabla 2x2, se expresaría como: d VPP = ––––––––– c+d 9. Validación de pruebas diagnósticas supone una pérdida y malgasto de recursos, pues el esfuerzo invertido no compensará la detección de unos pocos casos. Por el contrario, aplicar el mismo programa sólo a una muestra de pacientes con alta sospecha clínica, mejorará notablemente su rendimiento. Así, es necesario saber interpretar cuidadosamente los resultados en función de la prevalencia de la enfermedad a estudio (6,7). Ejemplo 9.2 El servicio de medicina preventiva de nuestro hospital realiza sistemáticamente la prueba del VIH al personal sanitario. Tanto la sensibilidad como la especificidad de la prueba son muy altas, del orden del 99,5%. Con estos datos, el riesgo de tener la enfermedad parece ser muy alto si el resultado del test es positivo. Sin embargo, debido a que la prevalencia estimada de la enfermedad entre el personal sanitario es baja, alrededor del 0,2%, la probabilidad real de tener la enfermedad (factor predictivo positivo) es sólo del 30%. En ausencia de otros datos clínicos que apoyen el diagnóstico, es más probable que el resultado de la prueba sea un falso positivo que un positivo verdadero. c) Relación con la prevalencia y la especificidad A diferencia de la sensibilidad y la especificidad, los valores predictivos sí se ven influenciados tanto por la prevalencia de la enfermedad, como por la especificidad del test (7). Respecto a la prevalencia, cuando ésta es alta en la población estudiada, se observa un marcado y lógico incremento del VPP (es decir, aumenta la probabilidad de que el resultado positivo realmente lo sea). Supongamos de nuevo un test empleado en un programa de screening. Aplicado de forma intempestiva a una población donde la enfermedad es poco frecuente e incluso excepcional, Ejemplo 9.3 La enfermedad de Lyme constituye un adversario frecuente en la práctica oftalmológica, especialmente entre aquellos dedicados al manejo de la inflamación intraocular. Son muchos los autores que muestran su preocupación por el exceso de casos diagnosticados o atribuidos a esta patología en zonas de baja prevalencia de la enfermedad, como sucede en nuestro medio (11-13). En estas regiones en las que la enfermedad es muy poco frecuente, aún con una sensibilidad y especificidad cercanas al 100%, el valor predictivo de una serología positiva es baja, probablemente menor del 20% (10), en aquellos pacientes con formas de presentación atípica y en donde no se ha podido constatar una anamnesis positiva ( el antecedente reconocido de una 79 9. Validación de pruebas diagnósticas picadura o la presencia de eritema crónico migrans, suelen estar ausentes en más de la mitad de los pacientes) (10). Por otro lado las técnicas serológicas en esta patología no están estandarizadas y existen numerosas causas de resultados tanto FN como FP, y una notable variabilidad entre los laboratorios (14-16). Por todo ello, la enfermedad de Lyme representa un verdadero reto en la interpretación de resultados, siendo preciso en su caso considerar aspectos que habitualmente olvidamos, como los valores predictivos, la influencia de la prevalencia y la presencia de datos clínicos compatibles. Un segundo factor importante a considerar en la interpretación del valor predictivo es la especificidad del test. Un incremento de la sensibilidad solo producirá un discreto aumento sobre el valor predictivo (7). Por el contrario el aumento de la especificidad produce un incremento mucho mayor (7). 5. REPRODUCIBILIDAD DEL TEST Otro aspecto esencial a la hora de valorar la utilidad de los test diagnósticos es su reproducibilidad (6,7). La reproducibilidad es un paso previo para determinar la validez interna de la prueba (5,6). Son varios los factores que contribuyen a la variabilidad de los resultados obtenidos al repetir cualquier test (7). – Variación intraobservador: Representa el grado de coincidencia que mantiene consigo mismo el evaluador (5). Con frecuencia un mismo observador puede resolver una misma muestra con dos resultados distintos, en función de sus condiciones particulares en el momento de la evaluación (estrés, agotamiento, condiciones externas…). Cuanto más subjetiva sea la determinación, más influenciada estará por esta variabilidad particular (7). – Variación interobservador: índice kappa. También resulta importante considerar la frecuente variabilidad que se observa cuando una misma muestra se expone ante dos observadores distintos. El grado de concordancia o discordancia entre ambos es otro factor a considerar, que hoy podemos cuantificar mediante el conocido como índice kappa o test de Cohen (17). Esta medida de acuerdo global tiene en cuenta la coincidencia esperada por el azar (5,7). Se expresa según la fórmula siguiente: (% concordancia observado) – (% concordancia esperado por azar) Kappa = –––––––––––––––––––––––––––––––––––––––––––––––––––––– 100% – (% concordancia esperado por azar) Para interpretar su valor se han publicado una serie de directrices (5). Así, Fleiss (18) considera que un valor de kappa mayor de 0,75 representa un nivel de acuerdo excelente, moderado para valores entre 0,4-0,75 y deficiente por debajo de 0,4. Por su parte, Landis y Koch (19) valoran la concordancia como muy buena por encima de 0,8, buena entre 0,61-0,8, moderada entre 0,4-0,61, baja entre 0,21-0,4 y deficiente por debajo de 0,21. – Relación con la validez: La pretensión de cualquier clínico es disfrutar de una prueba cuyos resultados no sólo sean válidos sino también reproducibles, si bien una buena validez interna no asegura la reproducibilidad de sus resultados. Cuando esta reproducibilidad es pobre, la validez de la prueba para un individuo concreto suele ser también limitada (7). 6. ODDS PREPRUEBA Y POSTPRUEBA – Variación individual: Muchos de los valores obtenidos en la medición de variables humanas varían a lo largo del tiempo, incluso durante cortos periodos (7). Así, reconocemos las oscilaciones que se producen a lo largo del día en la presión intraocular (PIO). También los resultados pueden variar por otras causas, como sucede con los test serológicos y microbiológicos en función del intervalo transcurrido desde el inicio de los síntomas hasta la obtención de la muestra. La odds de una enfermedad es la razón de probabilidad de que un sujeto tenga la enfermedad entre la probabilidad de que no la tenga (prevalencia/1prevalencia) (6). Específicamente, la odds preprueba representa junto con la especificidad y la sensibilidad, la tercera pieza esencial en la interpretación de pruebas diagnósticas. Se define como la probabilidad de que un paciente presente una determinada enfermedad antes de que la prueba en cuestión sea 80 realizada, basándonos esencialmente en la historia clínica compatible y la exploración, pero también en la prevalencia de ese determinado trastorno en la población a la que pertenece el sujeto (4,6). En la odds postprueba, la razón de probabilidad estará condicionada a conocerse el resultado de una cierta prueba diagnóstica de la que sabemos su sensibilidad y especificidad. Su cálculo está basado en la fórmula del teorema de Bayes de probabilidad condicionada (4,6). Todos somos «bayesianos» intuitivos en el día a día del diagnóstico clínico cuando interpretamos los síntomas y las pruebas diagnósticas: «Si este paciente tiene antecedentes familiares de glaucoma y además presenta una cifra de PIO alta y además muestra una excavación papilar de aspecto patológico y además obtiene valores patológicos en una prueba anatómica, como el HRT, y además presenta defectos característicos en una prueba funcional, como el campo visual, determinamos que dicho paciente tiene una probabilidad cercana a la certeza de tener un glaucoma». Esta concatenación intuitiva de hechos puede expresarse en ciertos casos de forma matemática (20) BIBLIOGRAFÍA 1.Diccionario de la Lengua Española. Real Academia Española. Vigésimo segunda edición. Espasa. 2007. Madrid. 2.Kassirer JP. Our stubborn quest for diagnostic certainty. A cause of excessive testing. N Engl J Med 1989; 320(22): 1489-91. 3. Whitcup SM. Medical history in the patient with uveitis. In: Nussenblatt RB, Whitcup SM, eds. Uveitis Fundamentals and Clinical Practice, 4th ed. Philadelphia, Mosby-Elsevier, 2010, pp 34-40. 4.Whitcup SM. Diagnostic testing. In: Nussenblatt RB, Whitcup SM, eds. Uveitis Fundamentals and Clinical Practice, 4th ed. Philadelphia, Mosby-Elsevier, 2010, pp 59-71. 5.Delgado Rodríguez M, Hernández Aguado I, Lumberas Lacarra B, Gómez Mata ML. Estudio de las pruebas diagnósticas. En: Sierra López A, Sáenz González MC, FernándezCrehuet Navajas J, Salleras Sanmartí L, Cueto Espinar A, Gestal Otero JJ et al editores. Piedrola Gil Medicina pre- 9. Validación de pruebas diagnósticas ventiva y salud pública, 11ª edición. Barcelona, ElsevierMasson, 2008, pp 173-184. 6.Jenicek M, Cleroux R. Identificación de los casos de enfermedad. En: Jenicek M, Cleroux R, editores. Epidemiología: la lógica de la medicina moderna, 1ª edición. Barcelona, Masson, 1996, pp 79-120. 7.Gordis L. Assessing the validity and reliability of diagnostic and screening test. In: Gordis L, ed. Epidemiology, 4th edition. Philadelphia, WB Saunders- Elsevier, 2009, pp 85108. 8.Leeflang MM, Deeks JJ, Gatsonis C, Bossuyt PM. Systematic reviews of diagnostic test accuracy. Ann Intern Med 2008; 149(12): 889-897. 9.Tramont EC. Treponema pallidum (syphilis). In: Mandell GL, Bennett JE, Dolin R, eds. Mandell, Douglas and Bennett’s Principles and Practice of Infectious Diseases, 6th ed. New York, Churchill Livingstone, 2005, pp 27682785. 10.Whitcup SM. Spirochetal Diseases. In: Nussenblatt RB, Whitcup SM, eds. Uveitis Fundamentals and Clinical Practice, 4th ed. Philadelphia, Mosby-Elsevier, 2010, pp 34-40. 11.Wormser GP, Nadelman RB, Dattwyler RL, et al. Practice guidelines for the treatment of Lyme disease. Clin Infect Dis 2000; 31(Suppl 1):S1-14. 12.Verdon ME, Sigal LH. Recognition and management of Lyme disease. Am Fam Phys 1997; 56: 427-436. 13.Steere AC, Taylor E, McHugh GL, et al. The overdiagnosis of Lyme disease. JAMA 1993; 269: 1812-1816. 14.Schwartz BS, Goldstein MD, Ribeiro JMC, et al. Antibody testing in Lyme disease: a comparison of results in four laboratories. JAMA 1989; 262: 3431-3434. 15.Luger SW, Krauss E. Serologic test for Lyme disease: interlaboratory variability. Arch Intern Med 1990; 150: 761-763. 16.Barbour AG. The diagnosis of Lyme disease: rewards and perils. Ann Intern Med 189; 110: 501-502. 17.Cohen J. A coefficient of agreement for nominal scales. Educational and Psychological Measurement 1960; 20(1): 37-46. 18.Fleiss JL. Statistical methods for rates and proportions, 2nd edition. New Yorik, John Wiley, 1981. 19.Landis JR, Koch GG. The measurement of observer agreement for categorical data. Biometrics 1977; 33(1): 159174. 20.Beneyto, P. Fernández MJ, García A, Ibáñez M, GarcíaAparicio A, Morente P. Aproximación diagnóstica a la ciclitis heterocrómica de Fuchs en ausencia de heterocromía. Arch Soc Esp Oftalmol 2007; 82, (6): 355-359.

© Copyright 2026