MCO bajo los Supuestos Clásicos

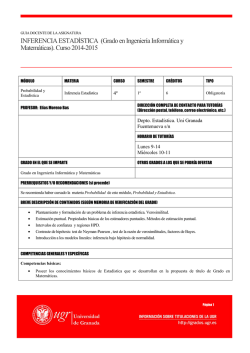

Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Los estimadores mínimo cuadráticos bajo los supuestos clásicos Propiedades estadísticas e inferencia Mariana Marchionni [email protected] Mariana Marchionni MCO bajo los supuestos clásicos 1 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Temario de la clase 1 Repaso 2 El modelo lineal clásico 3 Propiedades de los estimadores 4 Inferencia Mariana Marchionni MCO bajo los supuestos clásicos 2 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Estimación por MCO del modelo lineal simple Tenemos el modelo lineal con 2 variables Yi = α + β Xi + µi Y el objetivo es estimar α y β i = 1, ...n a partir de (Yi , Xi ) i = 1, ...n. Recordemos notación y deniciones: α̂ y β̂ son los estimadores de α y β Ŷi ≡ α̂ + β̂ Xi es la versión estimada ei ≡ Yi − Ŷi = Yi − (α̂ + β̂ Xi ) es el de Yi error de estimación (residuo) Mariana Marchionni MCO bajo los supuestos clásicos 3 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia α̂ y β̂ (Y , X ) Cada posible valor que asignemos a plano Mariana Marchionni dene una recta en el MCO bajo los supuestos clásicos 4 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Mínimos Cuadrados Ordinarios (MCO) Criterio de MCO: elegir α̂ y β̂ de manera de minimizar SRC. Formalmente: Minα̂,β̂ SRC (α̂, β̂) = CPO : n X i =1 (1) (2) ei2 = n X i =1 [Yi − (α̂ + β̂ Xi )]2 ∂ SRC ∂ α̂ =0 ∂ SRC ∂ β̂ =0 Solución: N P (3) α̂ = Ȳ − β̂ X̄ y Xi Yi −nȲ X̄ 1 (4) β̂ = i =P N 2 Xi −nX̄ 2 i =1 Mariana Marchionni MCO bajo los supuestos clásicos 5 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Propiedades algebraicas 1 2 3 Pn ei = 0 Pin=1 i =1 ei Xi = 0 (⇒ Cov (X , e ) = 0) Ŷ (X̄ ) = Ȳ (⇒la recta de regresión pasa por las medias muestrales) 4 β̂ = rY ,X SY /SX (relación entre el coeciente de regresión y el de correlación) 5 6 Ȳ = Ŷ¯ (la media de las estimaciones de Y coincide con Ȳ ) rŶ ,e = 0 (la correlación entre las estimaciones de Y y los residuos es nula) Mariana Marchionni MCO bajo los supuestos clásicos 6 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Así luce la regresión estimada por MCO Ŷi = α̂ + β̂ Xi Mariana Marchionni MCO bajo los supuestos clásicos 7 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Bondad del ajuste Vimos que cuando se estima por MCO es válida la siguiente descomposición: n X |i =1 (Yi − Ȳ )2 = {z STC } = n X |i =1 (Ŷi − Ȳ )2 + {z SEC } + n X ei2 1 |i ={z } SRC STC : Suma Total de Cuadrados, SEC : Suma Explicada de Cuadrados, SRC : Suma de los Residuos al Cuadrado Denimos: R2 = SEC SRC =1− STC STC Mariana Marchionni MCO bajo los supuestos clásicos 8 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia R 2=0.94 94 % de la variabilidad muestral de Y está X explicada por el modelo lineal en Mariana Marchionni MCO bajo los supuestos clásicos 9 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia R 2=0.35 35 % de la variabilidad de Y está explicada por el modelo lineal en Mariana Marchionni X MCO bajo los supuestos clásicos 10 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia El modelo lineal clásico Adoptaremos algunos supuestos llamados supuestos clásicos Linealidad: Yi = α + β Xi + µi , i = 1, ...n X no aleatoria: las Xi son determinísticas, jas en muestreos repetidos. Esperanza nula de µi : E [µi ] = 0, i = 1, ..., n. Homocedasticidad de µi : V [µi ] = cte . ≡ σ 2 , i = 1, ..., n. No correlación serial de µi : Cov [µi , µj ] = 0, i 6= j . No multicolinealidad perfecta de las variables explicativas: Xi no pueden ser todas iguales, X debe variar entre las las observaciones. La mayoría de estos supuestos son poco realistas. Los adoptamos por razones pedagógicas. Levantaremos la mayoría a lo largo del curso. Mariana Marchionni MCO bajo los supuestos clásicos 11 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia El modelo lineal clásico Adoptaremos algunos supuestos llamados supuestos clásicos Linealidad: Yi = α + β Xi + µi , i = 1, ...n X no aleatoria: las Xi son determinísticas, jas en muestreos repetidos. Esperanza nula de µi : E [µi ] = 0, i = 1, ..., n. Homocedasticidad de µi : V [µi ] = cte . ≡ σ 2 , i = 1, ..., n. No correlación serial de µi : Cov [µi , µj ] = 0, i 6= j . No multicolinealidad perfecta de las variables explicativas: Xi no pueden ser todas iguales, X debe variar entre las las observaciones. La mayoría de estos supuestos son poco realistas. Los adoptamos por razones pedagógicas. Levantaremos la mayoría a lo largo del curso. Mariana Marchionni MCO bajo los supuestos clásicos 11 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Linealidad De esto ya habíamos hablado. Nuestro modelo: Yi = α + β Xi + µi , i = 1, ...n Lo importante es la linealidad en los parámetros α y β. Por qué? Vimos algunos modelos no lineales que pueden linealizarse (log-log, log-lin, etc.) Mariana Marchionni MCO bajo los supuestos clásicos 12 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia X no aleatoria ¾Qué signica esto? Fijas en muestreos repetidos Poco real para una ciencia social Experimentos Mariana Marchionni MCO bajo los supuestos clásicos 13 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Esperanza nula E [µi ] = 0 , i = 1, ..., n ⇒ E [Yi ] = α + β Xi , i = 1, ..., n En promedio, la relación es lineal y exacta Mariana Marchionni MCO bajo los supuestos clásicos 14 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Homocedasticidad V [µi ] = V [µj ], ∀ i 6= j V [µi ] = cte . ≡ σ 2 , i = 1, ..., n Intuitivamente: para todas las observaciones, la relación entre Y y X está igual de cerca de una relación lineal Si la varianza no es constante decimos que hay heterocedasticidad Notar: si E [µi ] = 0 y V [µi ] = σ 2 ⇒ E [µ2i ] = σ 2 Mariana Marchionni MCO bajo los supuestos clásicos 15 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia No correlación serial Cov [µi , µj ] = 0, i 6= j . Es una forma débil de independencia entre los términos aleatorios E [µi ] = 0 y Cov [µi , µj ] = 0 ⇒ E [µi µj ] = 0 vale Cov [µi , µj ] para i = j ? Notar que si ¾Cuánto Mariana Marchionni MCO bajo los supuestos clásicos 16 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia No multicolinealidad perfecta Las Xi , i = 1, ...n no pueden ser todas iguales Por qué? Ver gráco Fuerte supuesto de identicación Intuición? Mariana Marchionni MCO bajo los supuestos clásicos 17 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Recapitulando... el modelo lineal clásico Yi = α + β Xi + µi , i = 1, ...n 1 E [µi ] = 0, i = 1, ..., n . 2 V [µi ] = σ 2 , i = 1, ..., n . 3 Cov [µi , µj ] = 0, i 6= j . 4 Las Xi no son aleatorias y no son todas iguales Notar: en este contexto los parámetros desconocidos son β y α, σ Mariana Marchionni MCO bajo los supuestos clásicos 18 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Recapitulando... el modelo lineal clásico Yi = α + β Xi + µi , i = 1, ...n 1 E [µi ] = 0, i = 1, ..., n . 2 V [µi ] = σ 2 , i = 1, ..., n . 3 Cov [µi , µj ] = 0, i 6= j . 4 Las Xi no son aleatorias y no son todas iguales Notar: en este contexto los parámetros desconocidos son β y α, σ Mariana Marchionni MCO bajo los supuestos clásicos 18 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Ya sabemos que los estimadores mínimo cuadraticos α̂ y β̂ son buenos en el sentido de que minimizan la SRC En la derivación de los estimadores MCO de la clase pasada nunca recurrimos a los supuestos clásicos Vamos a explorar si los estimadores MCO son buenos en algún otro sentido, ahora sí basándonos en los supuestos clásicos Nuevas propiedades: linealidad, insesgadez, de varianza mínima, etc. Nos concentramos en β̂ . Los resultados para α̂ serán cubiertos en los prácticos. Mariana Marchionni MCO bajo los supuestos clásicos 19 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Las propiedades 1. Linealidad: β̂ β̂ = P ωi Y i puede escribirse como una combinación lineal de las Yi , i = 1, ...n Ver demostración Intuitivamente poco interesante, analíticamente conveniente Mariana Marchionni MCO bajo los supuestos clásicos 20 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia 2. Insesgadez: Es decir, β̂ E [β̂] = β es un estimador insesgado del parámetro β Ver demostración Intuitivamente: qué quiere decir que un estimador sea insesgado? ¾Qué pasa con la propiedad de insesgadez si levantamos el supuesto de homocedasticidad? ¾Cuál es el supuesto más importante para el insesgadez? Mariana Marchionni MCO bajo los supuestos clásicos 21 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia 3. V [β̂] = σ 2 / P xi2 Ver demostración ¾Qué mide V [β̂]? ¾Qué supuestos usamos para la prueba? Mariana Marchionni MCO bajo los supuestos clásicos 22 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Notar: σ2 V [β̂] = P xi2 = σ2 nV [X ] Entonces, en el modelo lineal simple, la varianza del estimador depende de: la dispersión del término aleatorio la cantidad de observaciones la variabilidad de X Mariana Marchionni MCO bajo los supuestos clásicos 23 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia 4. Teorema de Gauss-Markov Si valen todos los supuestos clásicos, β̂ tiene la menor varianza en la clase de todos los estimadores lineales e insesgados de β. En el modelo lineal clásico, los estimadores MCO son los Mejores Estimadores Lineales e Insesgados (MELI) Mejor en el sentido de más eciente dentro de su clase Entonces, MCO es bueno? Mariana Marchionni MCO bajo los supuestos clásicos 24 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Inferencia Consideremos el modelo Yi = α + β Xi + µi , i = 1, ...n Sabemos cómo producir estimaciones puntuales de α y β ¾Qué hacemos si quisiéramos evaluar la veracidad de una hipótesis como β = 0? (test de hipótesis) O si quisiéramos construir intervalos de conanza para los parámetros? (estimación por intervalos) Necesitamos asociar alguna medida de conanza a esa estimación puntual Mariana Marchionni MCO bajo los supuestos clásicos 25 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Test de hipótesis Hipótesis: una armación acerca de una parámetro desconocido Ejemplo: H0 : β = 0 Puede ser cierta o falsa Si pudiéramos observar ¾Y si no conocemos β? β no hay problema No sabemos realmente Pero... esperamos poder conocer algo acerca de si H0 es cierta o falsa Mariana Marchionni MCO bajo los supuestos clásicos 26 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Supongamos que estamos interesados en distinguir entre H0 : β = 0 y HA : β 6= 0, Podemos obtener β̂ pero sin observar β. β̂ es una variable aleatoria. Por qué? Puede tomar cualquier valor tanto bajo H0 como bajo HA : no podemos resolver nuestro problema observando los valores que toma β̂ Mariana Marchionni MCO bajo los supuestos clásicos 27 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Supongamos que Si H0 : β = 0 β̂ es un buen estimador es cierta, entonces, aunque β̂ pueda tomar cualquier valor, esperamos que tome valores cercanos a cero. Por qué? H0 rechazamos H0 . Con esta lógica, podemos sospechar que valores lejanos de cero: es falsa si β̂ toma Problema: cómo denimos qué valores están cerca y qué valores estan lejos del cero? Mariana Marchionni MCO bajo los supuestos clásicos 28 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia A nes de denir qué valores de β̂ están cerca y qué valores están lejos del cero en el caso de que necesitamos conocer la distribución de bajo H0 ) A partir de las propiedades de sabemos que si H0 : β = 0 β̂ H0 fuera cierta, β̂ (distribución de β̂ bajo los supuestos clásicos, entonces E [β̂] = 0. Por qué? También sabemos su varianza. Pero no tenemos información suciente para conocer toda la distribución de β̂ bajo H0 Dónde conseguimos esa información? Mariana Marchionni MCO bajo los supuestos clásicos 29 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Nuevo supuesto: normalidad del término aleatorio µi ∼ N (0, σ 2 ) Recordemos: cualquier función lineal de una variable normal es también normal Entonces Yi Entonces β̂ es normal. Por qué? es normal. Por qué? Mariana Marchionni MCO bajo los supuestos clásicos 30 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Entonces, con los supuestos clásicos más el supuesto de normalidad tenemos: β̂ ∼ N (β, σ 2 / De manera que cuando es cierta X xi2 ) H0 : β = 0, β̂ ∼ N (0, σ 2 / X se cumple: xi2 ) y también: β̂ ∼ N (0, 1) P σ 2 / xi2 z≡q Cuando β̂ es chico, z es chico Mariana Marchionni MCO bajo los supuestos clásicos 31 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Distribución de β̂ Mariana Marchionni MCO bajo los supuestos clásicos 32 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Distribución de z (estandarización de Mariana Marchionni β̂ ) MCO bajo los supuestos clásicos 33 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Regla: aceptamos H0 si β̂ es cercano al valor correspondiente a esa hipótesis Para denir cercano: sea 0 <c <1 y zc un número tal que: zc ≤ z ≤ zc ] = 1 − c Pr [− Entonces, si el valor −zc y zc , z (estandarización H0 de β̂ ) está entre los límites aceptamos Grácamente... Mariana Marchionni MCO bajo los supuestos clásicos 34 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Mariana Marchionni MCO bajo los supuestos clásicos 35 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia La región de aceptación en términos de z está dada por: zc ≤ z ≤ zc ] = 1 − c Pr [− Reemplazando Pr z por su denición: q q X X −zc σ2/ xi2 ≤ β̂ ≤ zc σ2/ xi2 = 1 − c Entonces la región de aceptación de de β̂ H0 viene dada por los valores en el intervalo: q X 2 σ / xi2 0 ± zc Mariana Marchionni MCO bajo los supuestos clásicos 36 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Aceptamos rechazamos H0 si β̂ H0 cae en ese intervalo. En caso contrario, Notar: especicamos c de antemano c es la signicatividad del test: probabilidad de rechazar una H0 cierta A partir de c , zc puede obtenerse a partir de una tabla de percentiles de la distribución normal estándar Luego las zonas de aceptación y rechazo se computan usando q P 0 ± zc σ 2 / xi2 Problema: σ2 Mariana Marchionni no se observa! MCO bajo los supuestos clásicos 37 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Aceptamos rechazamos H0 si β̂ H0 cae en ese intervalo. En caso contrario, Notar: especicamos c de antemano c es la signicatividad del test: probabilidad de rechazar una H0 cierta A partir de c , zc puede obtenerse a partir de una tabla de percentiles de la distribución normal estándar Luego las zonas de aceptación y rechazo se computan usando q P 0 ± zc σ 2 / xi2 Problema: σ2 Mariana Marchionni no se observa! MCO bajo los supuestos clásicos 37 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Estimación de σ2: 2 S = P ei2 n−2 Resultado: bajo todos los supuestos, si H0 : β = 0 es cierta β̂ t≡q P 2 ∼ Tn−2 2 S / xi Mariana Marchionni MCO bajo los supuestos clásicos 38 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia β̂ t≡q P 2 ∼ Tn−2 2 S / xi t es z pero reemplazando σ 2 por S 2 Tn−2 es la distribición T de Student con n−2 grados de libertad Ahora todo puede ser computado con los datos disponibles Mariana Marchionni MCO bajo los supuestos clásicos 39 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Mariana Marchionni MCO bajo los supuestos clásicos 40 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Hasta ahora vimos el caso particular: HA : β 6= 0 H0 : β = 0 vs. H0 : β = β0 vs. HA : β 6= β0 Yi = α + β Xi + µi , si Y es el consumo Caso general: Ejemplo: en ingreso, y β0 = 1, y X el qué estamos evaluando? Mariana Marchionni MCO bajo los supuestos clásicos 41 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia Entonces, bajo todos los supuestos y cuando es cierta H0 : β = β0 , se cumple: β̂ ∼ N (β0 , σ 2 / X xi2 ) β̂ − β0 ∼ N (0, 1) P σ 2 / xi2 z≡q Y también: β̂ − β 0 t≡q ∼ Tn−2 P S 2 / xi2 Mariana Marchionni MCO bajo los supuestos clásicos 42 / 43 Repaso El modelo lineal clásico Propiedades de los estimadores Inferencia β̂ − β 0 ∼ Tn−2 t≡q P S 2 / xi2 En la práctica, reemplazamos β0 por cualquier valor que nos interese En general, el estadístico t es la versión estimada de H0 , dividida por la raíz cuadrada de la varianza estimada Mariana Marchionni MCO bajo los supuestos clásicos 43 / 43

© Copyright 2026