Tema 2. Sistemas de Ecuaciones Lineales

Apuntes de Álgebra Lineal

Tema 2

Sistemas de ecuaciones lineales

En este capítulo comenzamos propiamente el estudio del Álgebra Lineal.

La palabra álgebra es de origen árabe y significaba originalmente “completar” o “recomponer”. En El Quijote se usa la palabra “algebrista” para referirse a una “persona que sabe

recomponer los huesos [dislocados]”. El sentido matemático de la palabra “álgebra” proviene

de los métodos enseñados por los matemáticos árabes del siglo IX para “despejar” la incógnita

de una ecuación y poder hallar así su solución. Esos métodos consistían en “completar” y “recomponer” los términos de una ecuación de primer o segundo grado. Así pues, el álgebra era

originalmente el arte de manipular las ecuaciones con el fin de hallar su solución. El máximo

ejemplo de álgebra en este sentido es lo que hoy llamamos la complección del cuadrado del binomio1

que nos permite resolver una ecuación de segundo grado o deducir la fórmula de su solución.

La palabra lineal que aparece en “Álgebra Lineal” debe entenderse no en el sentido general de

“línea” u objeto “unidimensional” sino en el sentido más restringido de “línea recta”, concebida

como la representación geométrica de un polinomio de grado 1. El concepto clave es, pues, el

de “recto” y no el de “línea” y está muy relacionado con el concepto de proporción ya que para

los puntos de una recta las diferencias de abscisas son proporcionales a las correspondientes

diferencias de ordenadas.

También es parte del Álgebra Lineal (ver último tema) el estudio de las formas cuadráticas,

que son polinomios de grado 2. Pero lo que hace que esto sea parte del Álgebra Lineal es

que en este estudio es fundamental el marco del espacio vectorial en el que está definida la

forma cuadrática, lo cual hace que las formas cuadráticas sean parte del estudio de los espacios

vectoriales.

1 Un polinomio de segundo grado,

del binomio x +

b

2

x2 + bx + c no es en general el cuadrado de un binomio, pero sí es igual al cuadrado

si le sumamos lo que le falta: 14 (b2 − 4c) (que es lo que completa el cuadrado del binomio).

1

Versión de 1 de diciembre de 2015, 20:14 h.

El concepto matemático de “lineal” incluye también un plano en el espacio (porque su ecuación está dada por un polinomio de grado 1) y también objetos geométricos análogos de dimensiones superiores, todos ellos definidos por ecuaciones de grado 1. El problema fundamental

del Álgebra Lineal es determinar la intersección de varios de tales objetos, lo que equivale a

“resolver” simultáneamente varias ecuaciones de primer grado (con una o más incógnitas). Las

leyes que rigen las manipulaciones algebraicas de tales conjuntos de ecuaciones definen una

estructura matemática llamada Espacio Vectorial, de forma que una definición breve y completa

del Álgebra Lineal es que consiste en el estudio de los Espacios Vectoriales.

2.1. Conceptos básicos de las ecuaciones lineales

2.1.

Tema 2. Sistemas de ecuaciones lineales

Conceptos básicos de las ecuaciones lineales

El estudio del Álgebra Lineal comienza por los métodos de resolución de las ecuaciones de

grado 1 en varias incógnitas. Se puede pensar que si en el estudio de las ecuaciones el primer

paso es aprender a resolver una ecuación de primer grado en una incógnita y el segundo es

aprender a resolver una ecuación de segundo grado en una incógnita, el tercer paso es aprender

a hallar la solución simultánea de un conjunto —sistema— de varias ecuaciones de primer grado

en varias incógnitas.

La idea directriz que se debe tener ante un sistema de ecuaciones en varias incógnitas es

que para poderlo “resolver” es necesario disponer de tantas ecuaciones “independientes” como

incógnitas. Sin embargo, como pronto veremos, especialmente en el caso de los sistemas de

ecuaciones lineales, esta idea directriz necesita varias matizaciones importantes.

Concepto de sistema de ecuaciones lineales

ecuación lineal

Una ecuación lineal es una igualdad entre dos polinomios de primer grado en varias variables

con coeficientes reales o complejos. Por ejemplo:

4x − 5y + 2 = 3z + 2i (1 − x ).

Las incógnitas de la ecuación son las variables independientes de los dos polinomios que aparecen en ella. En el caso del ejemplo las incógnitas son x, y, z. Toda ecuación lineal se puede

escribir como un polinomio de primer grado (en varias variables, con coeficientes reales o complejos) igualado a cero. En el caso de la ecuación anterior, la podemos escribir en la forma:

(4 + 2i ) x − 5y − 3z + 2 − 2i = 0.

Si una ecuación lineal está escrita de esta forma, los coeficientes de los términos de grado 1

se llaman los coeficientes de la ecuación y el opuesto del término de grado cero se llama el término

independiente de la ecuación.

Si el término independiente de la ecuación es cero entonces el polinomio que la define es

un polinomio es homogéneo (sólo tiene términos de grado 1) y la ecuación se llama una ecuación

lineal homogénea.

sistema de

ecuaciones

lineales

Un sistema de ecuaciones lineales es un conjunto finito de ecuaciones lineales. Las incógnitas

del sistema son todas las incógnitas de todas las ecuaciones del sistema. Por ejemplo, en los

sistemas:

3x + 2y + z = x + 4

(1 + i )z + iw = 0

(2.1)

1 − z + 6x = 6 + z − t

2iz + (1 − i )w = 4 + 4i.

las incógnitas son x, y, z, t en el de la izquierda y z, w en el de la derecha.

Forma estándard de un sistema de ecuaciones lineales

primer paso

El primer paso en el análisis de un sistema de ecuaciones lineales consiste en escribir cada

una de las ecuaciones que aparecen en él con todas las incógnitas en el miembro de la izquierda

y los términos independientes en el miembro de la derecha, de forma que cada ecuación del

sistema quede escrita como un polinomio homogéneo (de grado 1, en varias variables) igualado

a una constante. Por ejemplo, en el caso del sistema de la izquierda de los (2.1) el primer paso

sería escribir:

2x + 2y + z = 4

(2.2)

−2z + 6x + t = 5.

2

Tema 2. Sistemas de ecuaciones lineales

segundo paso

2.1. Conceptos básicos de las ecuaciones lineales

El segundo paso consiste en reordenar los términos de los polinomios de cada ecuación

de forma que todas tengan las incógnitas en el mismo orden. En el caso del ejemplo anterior,

pondríamos:

2x + 2y + z

=4

− 2z + t = 5.

6x

(2.3)

Esta es la forma en la que presentaremos normalmente los sistemas de ecuaciones lineales en

este curso, con lo cual, en general no será necesario realizar los dos primeros pasos descritos, y

podremos centrarnos en el proceso de resolución propiamente dicho. Finalmente, para resaltar

el orden de las incógnitas utilizaremos una sola letra con subíndices sucesivos para denotar las

incógnitas. Así, el sistema del ejemplo lo escribiríamos usualmente ya en la forma:

2x1 + 2x2 + x3

=4

− 2x3 + x4 = 5.

6x1

(2.4)

Ésta sería la forma estándard del sistema.

Representación matricial

Una vez que se ha escrito un sistema de ecuaciones lineales como una lista de polinomios

homogéneos de grado 1 igualados a constantes y que se han escrito las incógnitas en todas las

ecuaciones en el mismo orden, se puede prescindir de escribir los nombres de las incógnitas e

incluso de escribir los signos de sumar que combinan los términos de los polinomios, quedándonos unicamente con los coeficientes de cada ecuación y con los términos independientes. Se

obtiene de esta forma una tabla de números alineados en columnas:

2

6

2

0

1 0 4

−2 1 5

(2.5)

En esta tabla, la última columna (la más a la derecha) está formada por los términos independientes, y las demás columnas (una por cada incógnita) contienen cada una los coeficientes de la

incógnita correspondiente según aparecían en las ecuaciones en forma estándard. Esta tabla de

números, normalmente escrita entre paréntesis para delimitarla como un objeto único, se llama

muy apropiadamente la matriz del sistema porque de ella se puede obtener el sistema.

matriz del

Para escribir la matriz de un sistema de ecuaciones lineales es muy importante tener en

cuenta que en aquellas ecuaciones en las que no aparezca una incógnita determinada se debe

pensar que en el lugar en el que debería aparecer esa incógnita (según la forma en que las

hayamos ordenado) está presente dicha incógnita con un coeficiente igual a cero. De esta forma

en el lugar correspondiente de la matriz del sistema escribiremos un cero y la matriz será un

rectángulo completo con tantas filas como ecuaciones tiene el sistema y tantas columnas como

incógnitas tiene mas 1.

sistema

Matriz de coeficientes y matriz ampliada

En algunos problemas no nos interesan los términos independientes del sistema sino que

solamente nos interesan los coeficientes. En ese caso, prescindimos de la última columna de

la matriz del sistema para quedarnos solamente con la llamada matriz de coeficientes. Por esta matriz de

razón, se suele llamar también a la matriz del sistema la matriz ampliada, porque es igual a la coeficientes.

matriz de coeficientes ampliada por la columna de términos independientes. Por ejemplo, para matriz ampliada

3

= matriz del

sistema.

2.1. Conceptos básicos de las ecuaciones lineales

Tema 2. Sistemas de ecuaciones lineales

el sistema (2.4), cuya matriz está definida por la tabla (2.5), tenemos:

2x1 + 2x2 + x3

sistema de ecuaciones:

matriz de coeficientes:

Igualdad de

matrices.

2

6

2

0

1 0

−2 1

=4

− 2x3 + x4 = 5.

6x1

,

matriz ampliada:

2

6

2

0

1 0 4

−2 1 5

A partir de ahora, consideraremos a todo sistema de ecuaciones lineales como completamente equivalente a su matriz (ampliada), de forma que dos sistemas son el mismo si y sólo

si tienen la misma matriz ampliada. Por otro lado, dos matrices son iguales si y sólo si ambas

tienen el mismo número de filas, el mismo número de columnas y los elementos de lugares

correspondientes son iguales.

Una de las consecuencias de lo que acabamos de decir es que los dos sistemas:

x1 + 2x2 = 4

x1 − x2 = 1

y

x1 − x2 = 1

x1 + 2x2 = 4

(2.6)

deben considerarse como distintos aunque sólo se diferencien en el orden en el que están escritas

las ecuaciones.

Concepto de solución. La aplicación asociada a un sistema de ecuaciones lineales

Dados unos valores determinados de las incógnitas, podemos averiguar si constituyen una

solución de un sistema haciendo dos cosas: Primero, calcular los miembros de la izquierda de

todas las ecuaciones para esos valores particulares de las incógnitas y, segundo, comparar los

resultados obtenidos con los miembros de la derecha o términos independientes.

Por ejemplo, si queremos saber si el punto ( x1 , x2 , x3 , x4 ) = (1, 2, 3, 4) ∈ R4 es una solución

del sistema (2.4), calculamos en ese punto los miembros de la izquierda:

2x1 + 2x2 + x3 = 2 × 1 + 2 × 2 + 3 = 9

6x1 − 2x3 + x4 = 6 × 1 − 2 × 3 + 4 = 4.

Comparando estos resultados con los términos independientes vemos que no son iguales por lo

que concluimos que el punto (1, 2, 3, 4) ∈ R4 no es una solución de nuestro sistema. Si hacemos

lo mismo con el elemento (1, 1, 0, −1) de R4 vemos que al evaluar los miembros de la izquierda

del sistema (2.4), los resultados coinciden con los miembros de la derecha por lo que éste sí es

una solución de (2.4).

Lo que hacemos al proceder de esta manera es evaluar la siguiente función de R4 a R2 , la

cual está completamente determinada por los miembros de la izquierda de las ecuaciones del

sistema:

2x1 + 2x2 + x3

4

2

f : R → R , f ( x1 , x2 , x3 , x4 ) =

.

(2.7)

6x1 − 2x3 + x4

la aplicación

asociada al

sistema de

ecuaciones

Esta función o aplicación se llama la aplicación asociada al sistema de ecuaciones. En términos de

esta aplicación, el sistema de ecuaciones (2.4) se puede representar como la ecuación

f (x) = b,

donde b es el vector de los términos independientes.

4

(2.8)

Tema 2. Sistemas de ecuaciones lineales

2.1. Conceptos básicos de las ecuaciones lineales

Conjunto solución

Todo sistema de ecuaciones lineales con n incógnitas divide al conjunto Rn (o Cn ) en dos

subconjuntos: El conjunto de los elementos o vectores que son solución del sistema (llamado el

conjunto solución del sistema) y el de los que no lo son. Esto es así incluso en los siguientes dos conjunto

casos extremos: (1) que el sistema no tenga ninguna solución, y (2) que todo elemento de Rn solución

sea solución. En el primer caso diremos que el conjunto solución es el conjunto vacío, denotado conjunto vacío

mediante el símbolo ∅. En el segundo caso el conjunto solución es todo Rn y el conjunto de los

vectores que no son solución es el conjunto vacío, ∅. En términos de la aplicación asociada al

sistema de ecuaciones lineales, el sistema se puede representar en la forma (2.8) y entonces el

conjunto solución es el conjunto f −1 (b), llamado también imagen inversa de b por f .

Es incorrecto decir que un sistema dado no tenga conjunto solución. Todo sistema de ecuaciones ¡Atención!

tiene conjunto solución. Si el sistema no tiene ninguna solución, aún así tiene un conjunto solución,

que es ∅. En esos casos podemos decir, equivalentemente, que el sistema no tiene solución o

que el conjunto solución del sistema es ∅. Esto sólo ocurre en los sistemas cuyas ecuaciones son

incompatibles o contradictorias, como por ejemplo en el sistema:

x1 = 0

x1 = 1.

Un sistema cuyo conjunto solución sea vacío se llama inconsistente. Un sistema que tiene alguna solución (o sea, cuyo conjunto solución no es vacío) se llama consistente y se dice que sus

ecuaciones son compatibles.

Sistemas determinados. Hay un tipo muy especial de sistemas consistentes: aquellos cuyo

conjunto solución tiene un único elemento. Estos sistemas se llaman sistemas determinados. Aquellos cuyo conjunto solución tiene más de un elemento se llaman sistemas consistentes indeterminados.

Cuestiones de existencia y unicidad de soluciones

Hay dos cuestiones fundamentales que se plantean acerca de las soluciones de cualquier

sistema de ecuaciones e incluso de cualquier problema matemático; éstas se conocen como la

cuestión de existencia y la cuestión de unicidad. La primera consiste en plantearse si el sistema tiene o no alguna solución (si existe solución), es decir, si el sistema es consistente o no.

La segunda cuestión es si existe una sola solución (solución única), es decir, si el sistema es

determinado o indeterminado.

Relación con las aplicaciones sobreyectivas e inyectivas

Las cuestiones de existencia y unicidad de soluciones de un sistema de ecuaciones lineales

est · n íntimamente relacionadas con los conceptos generales de aplicación sobreyectiva y de aplicación inyectiva. Estos conceptos son de gran importancia y serán utilizados en muchas ocasiones

a lo largo de este curso, por lo que conviene comprenderlos claramente desde el principio.

Una función o aplicación del conjunto A al conjunto B,

f : A → B,

función o

aplicación

(2.9)

es una regla o fórmula para asignar a cada elemento del conjunto A un elemento del conjunto

B que se llama “el valor de f en el elemento dado de A”. El conjunto A de los “datos” en los

que se evalúa la función f se llama el dominio de f , mientras que el conjunto B que contiene los dominio

resultados de evaluar f se llama el codominio de f . Por ejemplo, para cualquier función real de codominio

5

2.2. Resolución de los sistemas de ecuaciones lineales

Tema 2. Sistemas de ecuaciones lineales

variable real definida por un polinomio, tanto el dominio como el codominio de la misma es el

conjunto R de los números reales.

Conjunto

imagen.

Aplicación

sobreyectiva

Los valores o resultados que se obtienen al evaluar f ( x ) para los distintos x ∈ A, son elementos de B llamados las imágenes de f y el conjunto de todas esas imágenes es un subconjunto

de B llamado la imagen de f y denotado Im( f ) y a veces también f ( A).

Una aplicación f : A → B es sobreyectiva si todo elemento del codominio B es un elemento

de la imagen Im( f ), es decir si Im( f ) = B (“la imagen es igual al codominio”). Esto es lo mismo

que decir que

“para todo elemento b ∈ B la ecuación f ( x ) = b tiene al menos una solución”.

Por tanto el concepto de aplicación sobreyectiva está relacionado con la cuestión de existencia

de soluciones.

Aplicación

inyectiva

Por otro lado, f es inyectiva si elementos distintos de A tienen imágenes distintas, es decir, si

( x, y ∈ A, x 6= y) implica f ( x ) 6= f (y). Esto

se puede decir de varias otras formas, por ejemplo:

f es inyectiva si x, y ∈ A, f ( x ) = f (y) implica x = y. Pero la forma de decirlo que más nos

interesa ahora es la que relaciona el concepto de aplicación inyectiva con la cuestión de unicidad

de soluciones: f es inyectiva si

“para todo elemento b ∈ B la ecuación f ( x ) = b tiene a lo sumo una solución”.

Aplicación

biyectiva

Las aplicaciones que son a la vez sobreyectivas e inyectivas se llaman aplicaciones biyectivas.

Decir que la aplicación de un sistema de ecuaciones lineales es sobreyectiva significa que

para cualesquiera términos independientes que pongamos, el sistema resultante siempre tendrá solución. Decir que dicha aplicación es inyectiva significa que para cualesquiera términos

independientes que pongamos, el sistema resultante, si tiene solución es única.

2.2.

Resolución de los sistemas de ecuaciones lineales

Sistemas equivalentes

Dos sistemas de ecuaciones lineales distintos con el mismo número de incógnitas pueden

tener exactamente el mismo conjunto solución.

Que esto es cierto es evidente porque hay muchos sistemas inconsistentes distintos y todos

ellos tienen el mismo conjunto solución: el conjunto vacío. Sin embargo, la afirmación hecha va

mucho más allá de esos casos triviales y sigue siendo cierta incluso para los sistemas consistentes.

Por ejemplo, los siguientes:

x1 + 2x2 = 4

x1 − x2 = 1

y

x1 − x2 = 1

(2.10)

x1 + 2x2 = 4

son dos sistemas consistentes distintos cuya solución es ( x1 , x2 ) = (2, 1) en ambos casos.

Se puede objetar que los sistemas (2.10) no son “realmente” distintos; pero entonces uno

se verá en la necesidad de definir lo que se entiende por “realmente distintos”. Forzando las

cosas hasta sus límites uno se verá obligado a reconocer que dos sistemas no son “realmente

distintos” si sólo se diferencian en alguna de estas cosas:

El orden en que están dadas las ecuaciones:

El sistema

x1 + 2x2 = 4

x1 − x2 = 1

no es “realmente distinto” de

6

x1 − x2 = 1

x1 + 2x2 = 4.

Tema 2. Sistemas de ecuaciones lineales

2.2. Resolución de los sistemas de ecuaciones lineales

Alguna ecuación de un sistema aparece en el otro multiplicada por un número distinto de

cero:

El sistema

x1 + 2x2 = 4

x1 − x2 = 1

no es “realmente distinto” de

x1 + 2x2 = 4

5x1 − 5x2 = 5,

porque la segunda ecuación del segundo sistema es igual a la correspondiente del otro

multiplicada por 5.

Alguna ecuación de un sistema es el resultado de sumar miembro a miembro a la correspondiente ecuación del otro, alguna otra ecuación del sistema:

El sistema

x1 + 2x2 = 4

x1 − x2 = 1

no es “realmente distinto” de

2x1 + x2 = 5

x1 − x2 = 1,

porque la primera ecuación del segundo sistema es el resultado de sumar, a la primera

ecuación del otro, la segunda.

En los tres casos tenemos un par de sistemas que tienen exactamente el mismo conjunto

solución. Así que lo que en realidad tienen en común dos sistemas que están relacionados por

una o varias de esas tres propiedades es el conjunto solución. Veremos más tarde que todo par

de sistemas de ecuaciones lineales que tengan el mismo conjunto solución se pueden obtener uno del otro

mediante la aplicación repetida de una o varias de las tres operaciones enunciadas. Esto nos lleva a hacer

la siguiente definición:

Definición:

solución.

Dos sistemas de ecuaciones lineales son equivalentes si tienen el mismo conjunto Sistemas

equivalentes.

Operaciones elementales

La estrategia fundamental para la resolución de un sistema de ecuaciones lineales consiste La estrategia

en transformar una o varias veces las ecuaciones del sistema de forma que en cada paso se

obtenga un sistema equivalente más fácil de resolver. Procediendo de esta forma se puede llegar

a transformar el sistema original en otro equivalente al primero cuyas soluciones sean claras o

cuya inconsistencia sea evidente.

Las transformaciones u operaciones que se pueden realizar sobre las ecuaciones de un sistema sin que se altere el conjunto solución son esencialmente de los tres tipos descritos más arriba,

pero todas esas transformaciones se pueden obtener mediante la combinación de los siguientes

tres tipos básicos o elementales:

1) Realizar un intercambio de las posiciones que ocupan dos ecuaciones determinadas en el Intercambio.

sistema.

2) Multiplicar los dos miembros de una ecuación dada por un número distinto de cero. Este

tipo de operación se llama una operación de reescalado.

Reescalado.

3) Sumar a una ecuación, miembro a miembro, otra ecuación del sistema o, más generalmente, un múltiplo de otra ecuación. Este tipo de operación se llama una operación de reemplazo Reemplazo.

porque una ecuación queda reemplazada por el resultado de sumarle un múltiplo de otra.

Los tres tipos de operaciones mencionadas sobre las ecuaciones de un sistema se llaman

operaciones elementales. Al realizar una operación elemental sobre las ecuaciones de un sistema operaciones

de ecuaciones lineales, no se altera la solución, es decir, se obtiene otro sistema equivalente al elementales

primero.

7

2.2. Resolución de los sistemas de ecuaciones lineales

Tema 2. Sistemas de ecuaciones lineales

Inversas de las operaciones elementales. Toda operación elemental realizada sobre un sistema

se puede “deshacer” mediante la realización de otra operación elemental. Por ejemplo, si se

han intercambiado dos ecuaciones, al realizar de nuevo la misma operación de intercambio,

las ecuaciones vuelven a sus posiciones originales. Si realizamos una operación de reescalado

multiplicando una cierta ecuación por c, entonces por definición de operación de reescalado c

es distinto de cero y podemos reescalar la misma ecuación por 1/c con lo que recuperamos la

ecuación de partida. Finalmente, supongamos que realizamos la operación de reemplazo que

consiste en sumar a la segunda ecuación la primera multiplicada por 3:

x1 + 2x2 = 4

x1 − x2 = 1

sumo a la 2a ecuación la 1a ×3

x1 + 2x2 = 4

4x1 + 5x2 = 13,

Si a continuación realizamos la operación de reemplazo que consiste en sumar a la segunda

ecuación la primera multiplicada por −3 estaremos restando lo que habíamos sumado y volveremos a obtener las mismas ecuaciones que teníamos al principio:

x1 + 2x2 = 4

4x1 + 5x2 = 13,

sumo a la 2a ecuación la 1a ×(−3)

x1 + 2x2 = 4

x1 − x2 = 1

En resumen:

Toda operación elemental tiene una inversa que es también una operación elemental.

Operaciones elementales en la resolución de sistemas de ecuaciones lineales

Uno de los errores más frecuentes al intentar resolver un sistema de ecuaciones lineales

consiste en “despejar” y “sustituir” incógnitas de forma más o menos aleatoria con la esperanza

de conseguir despejarlas todas y encontrar la solución. Esta forma de proceder, combinada con

un poco de habilidad suele dar resultado para sistemas pequeños con no más de dos incógnitas

o para sistemas que tengan algunas simetrías muy obvias, pero cuando el número de incógnitas

y de ecuaciones aumenta, suele llevarnos a círculos viciosos de los que es difícil salir.

El método de resolución de sistemas de ecuaciones lineales más eficaz se realiza mediante

operaciones elementales en dos fases que se describen a continuación.

Fase 1: Simplificación del sistema o fase de eliminación

La forma sistemática de aplicar la estrategia de simplificación mediante operaciones elementales se basa en el hecho de que si una incógnita aparece en una ecuación, entonces su coeficiente

es distinto de cero y entonces: (1) podemos hacerlo igual a 1 mediante una operación de reescalado, y (2) mediante una operación de reemplazo podemos eliminar esa incógnita de toda otra

ecuación en la que aparezca.

Por ejemplo, en el sistema:

x1 +2x2 −3x3 + x4 = 4

x2 + x3

x1

=b

+ x3 +2x4 = c.

(2.11)

podemos utilizar la tercera ecuación para eliminar la incógnita x1 de todas las demás, que es

decir, en este caso, eliminarla de la primera ecuación ya que no aparece en la segunda. Para

hacer esto realizamos la operación elemental de “sumar a la primera ecuación la tercera multiplicada

por −1”. También podíamos haber usado la primera ecuación para eliminar la incógnita x1 de

las otras, pero en este ejemplo queremos acentuar que se puede utilizar la ecuación que más

8

Tema 2. Sistemas de ecuaciones lineales

2.2. Resolución de los sistemas de ecuaciones lineales

convenga. Así al elegir la incógnita x1 de la tercera ecuación, la señalamos con un recuadro y

realizamos la operación elemental indicada, con lo que nuestro sistema se convierte en:

2x2 −4x3 − x4 = 4 − c

x2 + x3

x1

=b

+ x3 +2x4 = c.

(2.12)

La incógnita eliminada sólo permanece en la ecuación que fué utilizada para realizar esta eliminación. Vamos a utilizar una notación est · ndard para las operaciones elementales. La operación

de reemplazo que consiste en sumar a la ecuación k la ecuación h multiplicada por c la vamos a

denotar

Ek → Ek + cEh ,

que debe leerse: “La ecuación k queda sustituida por el resultado de sumarle la ecuación h multiplicada por c”. Entonces, la operación realizada para pasar del sistema (2.11) al sistema (2.12) se

denotaría: E1 → E1 − E3 y escribiríamos:

x1 +2x2 −3x3 + x4 = 4

x2 + x3

x1

=b

+ x3 +2x4 = c.

2x2 −4x3 − x4 = 4 − c

E1 → E1 − E3

−−−−−−−−−→

x2 + x3

=b

+ x3 +2x4 = c.

x1

Hecho esto, observamos que el sistema formado por las demás ecuaciones tiene al menos

una incógnita menos que el sistema completo y podemos repetir el mismo proceso con dicho

subsistema. En nuestro ejemplo podríamos hacer:

2x2 −4x3 − x4 = 4 − c

x2 + x3

x1

=b

−6x3 − x4 = 4 − c − 2b

=b

E1 → E1 − 2E2

−−−−−−−−−−

→

+ x3 +2x4 = c.

x2 + x3

x1

+ x3 +2x4 = c.

El proceso termina cuando nos queda solamente una ecuación por utilizar. En todas las demás

hay una incógnita en el recuadro. Ninguna de esas incógnitas aparece en la última ecuación que

nos queda. Llegados a este punto, y para terminar esta fase de eliminación, sólo nos queda elegir

una de las incógnitas que aún permanecen en la última ecuación y marcarla con un recuadro

como las anteriores, de forma que ahora todas las ecuaciones tienen marcada una incógnita y es

una incógnita distinta en cada ecuación. En nuestro ejemplo, podemos terminar esta fase con:

−6x3 − x4 = 4 − c − 2b

x2 + x3

x1

=b

(2.13)

+ x3 +2x4 = c.

Caso de que desaparezcan todas las incógnitas de una ecuación. La cuestión de existencia

Al realizar el proceso de eliminación puede ocurrir que en algún momento desaparezcan todas las incógnitas de una ecuación. Por ejemplo, esto ocurre en el sistema que se muestra a

continuación al sumar a la segunda ecuación la primera multiplicada por 2:

x1 + 2x2 − 3x3 = 4

−2x1 − 4x2 + 6x3 = b.

E2 → E2 + 2E1

−−−−−−−−−−

→

x1 + 2x2 − 3x3 = 4

0x1 + 0x2 + 0x3 = b + 8.

Cuando esto ocurre, nuestro sistema se transforma en uno que tiene una ecuación de la forma

0 = a donde a puede ser cero o no. Si a es cero, hemos obtenido la ecuación 0 = 0 que no tiene

relevancia para la solución sistema y que se puede descartar. Si a no es cero, hemos llegado a

9

2.2. Resolución de los sistemas de ecuaciones lineales

Tema 2. Sistemas de ecuaciones lineales

una ecuación imposible, que indica que nuestro sistema original era inconsistente, como ocurriría

en el ejemplo anterior si b fuese 6= −8, por ejemplo:

x1 + 2x2 − 3x3 = 4

−2x1 − 4x2 + 6x3 = 5.

E2 → E2 + 2E1

−−−−−−−−−−

→

x1 + 2x2 − 3x3 = 4

0x1 + 0x2 + 0x3 = 13.

En este caso, hemos terminado y podemos decir que el conjunto solución es ∅. Así pues, realizar

la fase 1 nos permite contestar la cuestión de existencia de soluciones para nuestro sistema: No

existe solución si en el proceso de eliminación se obtiene una ecuación en la que todas las incógnitas tenen

coeficiente cero pero el término independiente no es cero. Si esto no ocurre, existe solución.

Incógnitas básicas y variables libres. La cuestión de unicidad

Si terminado el proceso de eliminación no hemos encontrado ninguna inconsistencia, aparte

de saber que el sistema tiene solución, habremos transformado nuestro sistema en otro equivalente pero que es mucho más fácil de resolver. Pero lo realmente interesante de lo que hemos

obtenido es que las incógnitas originales han quedado clasificadas en dos tipos: Las que aparecen en un recuadro, que llamaremos incógnitas básicas, y las demás, que llamaremos variables

libres. En nuestro ejemplo, según vemos en (2.13), tenemos:

incógnitas básicas:

x1 , x2 , x4 ;

variables libres:

x3 .

El objetivo de la siguiente fase es expresar las incógnitas básicas en función de las variables

libres. Las distintas posibles soluciones del sistema se obtendrán dando valores arbitrarios a

las variables libres y calculando los correspondientes valores de las incógnitas básicas. Pero

no es necesario hacer eso para poder contestar la cuestión de unicidad para nuestro sistema:

Suponiendo que es consistente, el sistema tiene solución única si no hay variables libres; si hay alguna

variable libre la solución no es única.

Fase 2: Sustitución regresiva y solución del sistema

La forma más eficaz de consguir expresar las incógnitas básicas en función de las variables

libres es la técnica de “sustitución regresiva” llamada así porque se trabaja sobre las ecuaciones

en el orden inverso al que se llevó en la fase anterior.

Una forma fácil de explicar esta fase es que, yendo ecuación a ecuación en el orden inverso al

llevado en la fase de eliminación se despeja la incógnita básica de esa ecuación y se sustituye en

todas las demás ecuaciones.

Al terminar la fase 1, el sistema suele haber alcanzado una forma suficientemente sencilla

como para que este “despejar” y “sustituir” se pueda realizar sin dificultades siempre que se siga

el orden inverso tal como acabamos de decir. En nuestro ejemplo esto se reduciría a:

(1) Despejamos x4 en la primera de las (2.13):

x4 = 2b + c − 4 − 6x3 .

(2) Sustituimos x4 en la última de las (2.13) (ya que es la única ecuación en la que aparece),

de forma que esta ecuación se convierte en:

x1 + x3 + 2(2b + c − 4 − 6x3 ) = c.

(3) Despejamos x2 en la segunda de las (2.13): x2 = b − x3 (no aparece en la siguiente, luego

no hay que sustituirla).

10

Tema 2. Sistemas de ecuaciones lineales

2.2. Resolución de los sistemas de ecuaciones lineales

(4) Despejamos x1 en la tercera de las (2.13) con lo que hemos obtenido:

x4 = 2b + c − 4 − 6x3

x2 = b − x3

(2.14)

x1 = c − x3 − 2(2b + c − 4 − 6x3 ).

Así, hemos realizado esta fase mediante “despejar” y “sustituir”. Sin embargo es importante

comprender que esta fase se puede realizar también mediante operaciones elementales en un

proceso en el que para cada incógnita básica, en el orden inverso al que se han obtenido, se usa

la ecuación en la que aparece en recuadro para eliminarla de todas las demás ecuaciones. En

nuestro ejemplo haríamos la operación elemental E3 → E3 + 2E1 :

−6x3 − x4 = 4 − c − 2b

x2 + x3

x1

=b

−6x3 − x4 = 4 − c − 2b

E3 → E3 + 2E1

−−−−−−−−−−

→

x2

+ x3 + 2 x4 = c.

+ x3

−11x3

x1

=b

= c + 2(4 − c − 2b).

y con esto ya estarían las ecuaciones listas para despejar las incógnitas básicas:

x4 = 2b + c − 4 − 6x3

x2 = b − x3

(2.15)

x1 = c + 2(4 − c − 2b) + 11x3 .

Estas fórmulas, ya sean (2.14) o (2.15), que expresan las incógnitas básicas en función de las

variables libres son las ecuaciones paramétricas del conjunto solución. Las variables libres actúan

como parámetros que pueden tomar valores arbitrarios. Cada vez que elijamos a capricho valores para las variables libres, las fórmulas de las incógnitas básicas nos proporcionarán valores

numéricos para ellas y habremos especificado una solución particular del sistema. Por ejemplo, si

elegimos x3 = 0, tendremos la solución particular

x1 = 8 − 4b − c, x2 = b, x3 = 0, x4 = 2b + c − 4.

El proceso de resolución de un sistema en versión matricial

Toda operación elemental realizada sobre las ecuaciones de un sistema puede efectuarse de

forma, si cabe, más económica, sobre las filas de la matriz (ampliada) del sistema. Por ejemplo,

la siguiente operación elemental que hemos utilizado en un ejemplo:

x1 +2x2 −3x3 + x4 = 4

x2 + x3

x1

=b

+ x3 +2x4 = c.

2x2 −4x3 − x4 = 4 − c

E →E −E

3

1

1

−−−−−−

→

x2 + x3

x1

puede representarse matricialmente escribiendo:

1 2 −3 1 4

F1 → F1 − F3

0 1

1 0 b −−−−−−

→

1 0

1 2 c

0 2

0 1

1 0

=b

+ x3 +2x4 = c.

−4 −1 4 − c

1

0

b

1

2

c

(donde hemos cambiado la “E” por una “F” en la notación de las operaciones elementales

para indicar que ahora ya no son operaciones con ecuaciones, sino con filas de una matriz).

De esta forma los procesos de eliminación y de sustitución se traducen en sendos procesos

que, en cada paso, transforman la matriz de un sistema en la de un sistema equivalente. Las

operaciones elementales que se pueden realizar sobre las ecuaciones de un sistema dan lugar,

pues, a operaciones elementales sobre las filas de una matriz, las cuales, repitiendo lo dicho más

arriba, son de los siguientes tipos:

11

Ecuaciones

paramétricas del

conjunto

solución.

solución

particular

2.3. Forma escalonada reducida de una matriz

Tema 2. Sistemas de ecuaciones lineales

1. Intercambio: Intercambiar las posiciones de dos filas.

2. Reescalado: Multiplicar una fila por un número distinto de cero.

3. Reemplazo: Sumar a una fila un múltiplo de otra.

La resolución de un sistema por este método tiene tres partes:

1. Escribir la matriz del sistema (o sea, representar el sistema en forma matricial).

2. Realizar el proceso de “eliminación” y “sustitución” sobre la matriz del sistema.

3. Escribir el sistema de ecuaciones representado por la matriz obtenida al final del proceso.

matrices

equivalentes por

filas

Dos matrices de las que una ha sido obtenida a partir de la otra mediante la realización de

una o varias operaciones elementales de filas se dice que son matrices equivalentes por filas.

Evidentemente, las matrices que corresponden a sistemas de ecuaciones lineales equivalentes son

matrices equivalentes por filas y, recíprocamente, los sistemas de ecuaciones lineales que corresponden a

matrices equivalentes por filas, son sistemas equivalentes.

El teorema fundamental de las operaciones elementales

Todo lo que acabamos de decir nos permite concluir el siguiente, que será la clave en nuestro

estudio de las matrices:

Si sobre un sistema de ecuaciones lineales se realiza una operación elemental, y luego se escribe la matriz correspondiente al nuevo sistema obtenido, el resultado es la misma matriz que se obtendría realizando

dicha operación elemental sobre la matriz del sistema original.

Este hecho se puede representar gráficamente de la siguiente forma:

Sistema 1

O

Matriz 1

op. elem.

/ Sistema 2

O

op. elem.

/ Matriz 2

Por ejemplo,

−6x3 − x4 = 1

x2 + x3

=2

x1 + x3 + 2 x4 = −1

O

E3 → E3 +2E1

−6x3 − x4 = 1

x2 + x3

=2

x1 −11x3

=1

O

/

0 0

0 1

1 0

2.3.

−6 −1

1

1

0

2

1

2 −1

F3 → F3 +2F1

0 0

/ 0 1

1 0

−6 −1 1

1

0 2

−11

0 1

Forma escalonada reducida de una matriz

Hemos visto que el proceso de eliminación y sustitución que nos permite resolver un sistema

de ecuaciones lineales mediante la realización de operaciones elementales sobre esas ecuaciones

12

Tema 2. Sistemas de ecuaciones lineales

2.3. Forma escalonada reducida de una matriz

puede realizarse también sobre la matriz del sistema mediante operaciones elementales de filas.

En esta sección introducimos una versión refinada de dicho proceso cuyo interés va más allá

de la resolución de los sistemas, ya que aplicado a una matriz cualquiera (no necesariamente

una que hayamos obtenido a partir de un sistema de ecuaciones lineales) nos permitirá obtener

valiosa información sobre la misma.

Matriz en forma escalonada

Imaginemos que realizamos el proceso de eliminación en un sistema de ecuaciones lineales, el proceso de

pero lo hacemos eliminando en el primer paso no una incógnita cualquiera sino precisamente “eliminación

la primera. Esto siempre es posible porque habrá alguna ecuación en la que aparezca la pri- ordenada”

mera incógnita. Entre las ecuaciones que contienen la primera incógnita elegimos una de ellas,

reordenamos las ecuaciones para que ésta (que hemos elegido por contener la primera incógnita) aparezca como la primera y eliminamos la primera incógnita de las demás ecuaciones. Por

ejemplo, para el siguiente sistema representando por su matriz ampliada, podríamos elegir la

primera incógnita de la última ecuación:

!

!

!

0

3

3

3

−7

−9

6

−5

−9

4

8

6

−5

9

15

−9

−7

3

3

3

0

F ↔F

3

1

−−−→

−9

−5

6

6

8

4

15

9

−5

F →F −F

2

2

1

−−−−−−

→

3

0

0

−9

2

3

−9

4

6

6

2

4

15

−6

−5

Obtenemos así un subsistema (el formado por las ecuaciones segunda a última) en el que no

aparece la primera incógnita. Si este subsistema tiene sólo una ecuación, hemos terminado el

proceso. Si tiene más de una, repetimos el proceso con este subsistema eliminando en él, igual

que antes, la primera incógnita de ese subsistema. En el ejemplo anterior podríamos hacer:

!

!

3

0

0

−9

2

3

−9

4

6

6

2

4

15

−6

−5

F3 → F3 − 3 F2

2

−−−−−−−

→

3

0

0

−9

2

0

−9

4

0

6

2

1

15

−6

4

Cuando se termina este proceso de “eliminación ordenada”, se ha obtenido un sistema equivalente al inicial pero cuya matriz tiene unas propiedades especiales. Llamamos elemento principal de una fila de una matriz al primer elemento no nulo de la misma (contando de izquierda Elemento

a derecha). Pues bien, la matriz del sistema obtenido en un proceso de eliminación ordenada principal de una

fila

tiene las siguientes propiedades:

1. Toda fila que no tiene elemento principal (fila de ceros) está después de cualquier fila que

tenga elemento principal.

2. El elemento principal de cada fila está situado más a la derecha que el de la fila anterior.

3. Todos los elementos debajo de un elemento principal (en su columna) son cero.

Propiedades que

definen una

matriz

escalonada

Toda matriz que tenga estas propiedades se llama una matriz escalonada y por lo explicado más

arriba: Toda matriz es equivalente por filas a una matriz escalonada.

Columnas pivote de una matriz

Durante la realización del proceso de “eliminación ordenada”, en cada paso hay en general

cierta libertad para elegir la ecuación que se usará para eliminar la incógnita básica correspondiente a ese paso. Esta libertad depende de que la correspondiente incógnita básica aparezca

en más de una ecuación. Podemos entonces elegir la ecuación que se usará para eliminar esa

incógnita básica atendiendo a varios posibles criterios. Un criterio particular que decidamos seguir para realizar dicha elección se llama una estrategia de pivotación. Por ejemplo, una estrategia Estrategia de

sencilla es la pivotación simple que consiste en elegir la primera ecuación en la que la incógnita pivotación

13

2.3. Forma escalonada reducida de una matriz

Tema 2. Sistemas de ecuaciones lineales

básica tenga coeficiente distinto de cero. Otra posible estrategia, que tiene mayor estabilidad

desde el punto de vista numérico (menor acumulación de errores de redondeo en los cálculos)

es la llamada pivotación parcial, que consiste en elegir aquélla ecuación en la que el coeficiente

de la incógnita básica tenga el mayor valor absoluto.

Dependiendo de la estrategia de pivotación adoptada, la “eliminación ordenada” puede

realizarse de varias formas y cada una de ellas dará como resultado una matriz escalonada

diferente. Sin embargo todas esas matrices escalonadas obtenidas por “eliminación ordenada”

a partir de una matriz dada tienen siempre ciertas características comunes:

Teorema: Todas las matrices escalonadas equivalentes a (obtenidas por medio de operaciones elementales

de fila a partir de) una matriz dada tienen el mismo número de elementos principales y en las mismas

posiciones.

La demostración de esto es muy sencilla: Supongamos que la primera incógnita aparece tanto en la

ecuación i como en la ecuación j y que al usar la ecuación i para eliminar la primera incógnita también

se elimina la segunda incógnita en todas las ecuaciones. Esto sólo es posible si los coeficientes de las dos

primeras incógnitas son proporcionales en todas las ecuaciones y por tanto también se habría eliminado la

segunda incógnita de todas las ecuaciones si hubiésemos usado la ecuación j para eliminar la primera. Un

razonamiento similar muestra que si al usar la ecuación i para eliminar la primera incógnita también se

eliminan la segunda y la tercera incógnitas de todas las ecuaciones, lo mismo ocurrirá al usar la ecuación

j en lugar de la i. En consecuencia, cuál es la siguiente incógnita básica es independiente de qué ecuación

se usa en el proceso de eliminación. Repitiendo el mismo razonamiento con el siguiente subsistema y

sucesivos se llega a la tesis del teorema.

Se llaman posiciones pivote de una matriz a las posiciones ocupadas por los elementos principales de cualquier matriz escalonada obtenida al realizar sobre la matriz dada el proceso de

eliminación ordenada.

Se llaman columnas pivote de una matriz a las columnas de las posiciones pivote de esa

matriz, es decir, las columnas de los elementos principales de la matriz.

La solución de cualquier sistema de ecuaciones lineales es susceptible de ser expresado

tomando como incógnitas básicas las que corresponden a las columnas pivote de su matriz.

Uso de una

forma

escalonada para

contestar las

preguntas de

existencia y

unicidad de

soluciones.

El interés de tener un sistema de ecuaciones lineales escrito de forma que su matriz sea

escalonada consiste en el hecho de mirando dicha matriz podemos contestar, sin realizar ningún

trabajo, las dos preguntas de existencia y unicidad de soluciones del sistema ya que, al estar la

matriz en forma escalonada, con sólo una mirada podemos identificar los elementos principales

y por tanto las columnas pivote: Si la columna de la derecha es una columna pivote el sistema

es inconsistente. Si no lo es, pero todas las demás columnas son columnas pivote el sistema es

determinado (solución única). Si alguna de las demás columnas no contiene elemento principal,

el sistema es indeterminado.

Forma escalonada reducida

Si sobre un sistema de ecuaciones lineales se realiza el proceso de eliminación ordenada, de

forma que el sistema se ha convertido en otro equivalente pero en forma escalonada, para obtener la solución del sistema sólo falta realizar el proceso de sustitución regresiva. Este proceso se

puede realizar de forma muy eficaz de la siguiente forma:

El proceso de

reducción

Utilizando como base la ecuación que contiene la última incógnita básica, realizamos operaciones de reemplazo en todas las ecuaciones anteriores de forma que eliminemos de todas ellas

dicha incógnita básica. Dividiendo la ecuación usada por el coeficiente de su incógnita básica

obtenemos un sistema en el que dicha incógnita básica sólo aparece en una ecuación y tiene

coeficiente 1. A continuación repetimos el mismo proceso partiendo de la ecuación anterior a

la que acabamos de usar y así sucesivamente hasta usar la segunda ecuación para eliminar su

14

Tema 2. Sistemas de ecuaciones lineales

2.4. Sistemas de ecuaciones lineales en forma vectorial

incógnita básica de la primera y finalmente obtener un sistema en el que toda incógnita básica

aparece en una sóla ecuación y tiene coeficiente 1.

La matriz del sistema así obtenido tiene las siguientes propiedades:

1. Tiene forma escalonada.

2. El elemento principal de cada fila es 1.

3. En cada columna pivote, todos los elementos por encima del elemento pivote son cero.

Toda matriz que tenga estas propiedades se llama una matriz escalonada reducida y por lo explicado más arriba: Toda matriz es equivalente por filas a una matriz escalonada reducida.

matriz

escalonada

reducida

Utilidad de la forma escalonada reducida

¿Cuál es el interés de la forma escalonada reducida de la matriz de un sistema de ecuaciones? Está claro que en la forma escalonada reducida podemos leer toda la información que

podemos leer en cualquier forma escalonada, que consiste principalmente en las respuestas a

las preguntas de existencia y unicidad de soluciones del sistema.

Pero además, en la forma escalonada reducida podemos leer la solución del sistema sin

necesidad de hacer ningún cálculo ya que la forma escalonada reducida de un sistema de ecuaciones lineales es esencialmente lo mismo que las ecuaciones paramétricas del conjunto solución

siempre que se usen como incógnitas básicas las correspondientes a las columnas pivote. Esto es debido a que los elementos no nulos de las columnas no pivote son justamente los coeficientes en

las ecuaciones paramétricas de la solución. Por ejemplo, si nos dicen que la forma escalonada

reducida de la matriz de un sistema de ecuaciones lineales es esta:

1

0

2

3

0

5 −1

0

1 −1

8

0

4

9 ,

0

0

0

0

1

7

6

automáticamente podemos escribir las ecuaciones paramétricas del conjunto solución:

x1 = −1 − 2r − 3s−5t

x1 = −1 − 2x3 − 3x4 −5x6

x2 =

9 + 1x3 − 8x4 −4x6

x5 =

6

−7x6 .

o bien:

x3 , x4 , x6 , libres.

x2 =

9 + 1r − 8s−4t

x3 =

r

x4 =

s

x5 =

6 − 7t

x6 =

t.

Como las ecuaciones paramétricas del conjunto solución en términos de unas variables básicas determinadas son únicas, llegamos a la siguiente conclusión:

Teorema: Dada una matriz, cualquiera que sea la forma en que se realiza el proceso de eliminación

ordenada y reducción, su resultado final será el mismo: La forma escalonada reducida de una matriz es

única.

2.4.

Sistemas de ecuaciones lineales en forma vectorial

La introducción del lenguaje de vectores nos permite ver un sistema de m ecuaciones lineales

en n incógnitas como una sola “ecuación vectorial” lineal en n incógnitas. Así, pasamos de

visualizar un sistema de ecuaciones lineales como varias ecuaciones entre números con varias

15

Unicidad de la

forma

escalonada

reducida

2.4. Sistemas de ecuaciones lineales en forma vectorial

Tema 2. Sistemas de ecuaciones lineales

incógnitas numéricas a visualizarlo como una sola ecuación entre vectores con varias incógnitas

numéricas. En la siguiente sección (sección 2.5, página 20), sintetizaremos aún más el punto de

vista para pasar a visualizar un sistema de ecuaciones lineales como una sola ecuación matricial

con una sola incógnita vectorial.

Vectores en Rn y Cn

Al hablar de vectores del plano (o del espacio) se puede uno referir a dos cosas distintas

(aunque equivalentes desde el punto de vista del álgebra lineal). Por un lado, en Álgebra, un

vector del plano es un par ordenado de números reales y las operaciones con vectores se derivan de las operaciones con números. Por otro lado, en Física y en Geometría se suele usar

la palabra “vector” como sinónimo de “cantidad con magnitud y sentido”. El ejemplo típico

es un “segmento orientado”, en el cual se distinguen el punto inicial (u “origen” o “cola”) y

el punto final (o “cabeza”). Un segmento orientado del plano (o del espacio) representa una

traslación global del plano (o del espacio) y la suma de vectores es equivalente a la composición

de traslaciones. Sin embargo, dos segmentos orientados que sean paralelos y tengan el mismo

sentido2 (o sea, dos vectores con la misma dirección, sentido y longitud) representan la misma

traslación del plano o del espacio. Cuando se usan los segmentos orientados para representar

traslaciones, basta considerar aquéllos cuyo origen es el origen de coordenadas. Cada vector

con el origen en el origen de coordenadas está completamente determinado por su punto final y

éste por sus coordenadas. Así, los vectores del plano, entendidos como traslaciones del plano se

corresponden con los “segmentos orientados que tienen el origen en el origen de coordenadas”

y éstos con los puntos del plano coordenado. Por ello, resultan ser equivalentes las definiciones de vector en Álgebra y en Geometría y los vectores del plano serán considerados como lo

mismo que los pares ordenados de números reales (y los del espacio como ternas ordenadas de

números reales).

Rn

Cn

En general, para todo número entero positivo n llamaremos vector de Rn a todo conjunto

ordenado de n números reales y lo representaremos normalmente como una columna de números reales (esto es, una matriz con una sola columna), aunque a veces, para ahorrar papel lo

representaremos en la forma ( a1 , . . . , an ) que no hay que confundir con una matriz de una sola

fila (en una matriz no hay comas). Igualmente, un vector de Cn es un conjunto ordenado de n

números complejos y lo escribiremos normalmente también en forma de columna.

Operaciones aritméticas con vectores: sus propiedades algebraicas

Las dos operaciones básicas a las que se pueden someter los vectores de Rn o de Cn , son

la suma de vectores y la multiplicación de un número por un vector (o “reescalado” de vectores), las

cuales se efectúan componente a componente como en el siguiente ejemplo:

Ejemplo:

Si

u=

1

2

, v=

,

−2

6

Si

u=

2

, c = 3,

−1

entonces

u+v =

entonces

1

2

1+2

3

+

=

=

−2

6

−2 + 6

4

2

cu = 3

−1

=

3×2

3 × (−1)

=

6

−3

Dichas dos operaciones básicas de vectores de Rn (o de Cn ) tienen las siguientes propiedades

fundamentales:

2 Esos

dos segmentos junto con el que une sus orígenes y con el que une sus finales formarán un paralelogramo.

16

Tema 2. Sistemas de ecuaciones lineales

2.4. Sistemas de ecuaciones lineales en forma vectorial

1. Propiedades de la suma de vectores (“Grupo conmutativo”):

a)

b)

c)

d)

Propiedad asociativa de la suma: u + (v + w) = (u + v) + w.

Existencia del neutro de la suma o vector cero: 0 + u = u + 0 = u.

Existencia de opuestos para la suma: −u + u = u + (−u) = 0.

Propiedad conmutativa de la suma: v + u = u + v.

2. Propiedades distributivas de la multiplicación por números:

a) Propiedad distributiva para la suma de vectores: x (u + v) = xu + xv.

b) Propiedad distributiva para la suma de números: ( x + y)u = xu + yu.

3. “Acción de los escalares”:

a) Propiedad asociativa del producto de números por vectores: x (yu) = ( xy)u.

b) Ley de identidad: El número 1 es neutro para la multiplicación de vectores por números: 1 u = u.

Espacios vectoriales abstractos. Todo conjunto de elementos abstractos que se puedan sumar

entre sí y multiplicar por números reales de tal forma que se cumplan esas propiedades se llama

un espacio vectorial real. y sus elementos se llaman vectores. Si los elementos del conjunto abstracto

se pueden multiplicar por números complejos manteniéndose dichas propiedades, entonces el

conjunto se llama un espacio vectorial complejo. Los números por los que se pueden multiplicar

los vectores de un espacio vectorial se llaman los escalares de ese espacio. Así, los escalares de Rn

son los números reales y los escalares de Cn son los números complejos. De ahora en adelante,

utilizaremos la palabra “escalar” para referirnos a un número real si el espacio en consideración

es Rn y a un número complejo si el espacio en consideración es Cn .

Def. de Espacio

Vectorial.

vectores

escalares

Combinaciones lineales de vectores

Las propiedades algebraicas de las operaciones básicas de vectores (suma y multiplicación

por escalares) hacen posible realizar muchas otras operaciones, como por ejemplo “punto medio” definido como:

punto medio(u, v) = 21 (u + v) = 12 u + 12 v.

Una operación algo más general es la llamada “baricentro” que se puede aplicar a un número

arbitrario de vectores y está definida por la fórmula:

baricentro(u1 , . . . , u p ) = 1p (u1 + · · · + u p ) = 1p u1 + · · · + 1p u p .

La operación más general que se puede realizar con vectores consiste en multiplicar cada

uno de los vectores dados por un número y sumar todos los resultados:

y = c1 u1 + · · · + c p u p

Esta operación se llama combinación lineal de los vectores u1 , . . . , u p y los escalares ci por los que

han sido multiplicados los vectores ui se llaman los coeficientes o pesos de esos vectores en la

combinación lineal. El vector y obtenido como resultado de la combinación lineal se llama una

combinación lineal de los vectores u1 , . . . , u p con pesos c1 , . . . , c p .

Por ejemplo, vamos a calcular la combinación lineal y = c1 u + c2 v donde

2

5

u=

,v =

, c1 = −1 , c2 = 2.

6

3

17

peso de un

vector en una

combinación

lineal.

2.4. Sistemas de ecuaciones lineales en forma vectorial

Tema 2. Sistemas de ecuaciones lineales

Para ello calculamos:

2

5

8

y = c1 u + c2 v = (−1)

+2

=

.

6

3

0

8

Entonces decimos que el vector y =

es una combinación lineal de los vectores u, v con

0

coeficientes o pesos −1, 2.

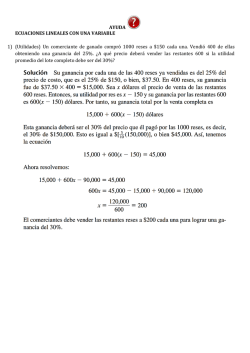

Ejercicio: Averiguar los pesos que hay que dar a los vectores

v1 y v2 de la figura de la izquierda para expresar el vector w

como combinación lineal de ellos.

Solución:

Trazando por w rectas paralelas a los vectores v1 y v2 como se muestra en la figura de

la derecha, observamos que es necesario calcular dos veces y media v1 y restarle a eso la

mitad de v2 :

w = 52 v1 − 12 v2 .

El problema de expresar un vector como combinación lineal de otros

Consideremos este problema: “Dados en Rm (o Cm ) un vector b y n vectores a1 , . . . , an , se

desea saber si b es combinación lineal de los a1 , . . . , an .”

Este problema es equivalente a plantearse si es posible hallar escalares x1 , . . . , xn tales que

x1 a1 + · · · + xn an = b.

conjunto

generado por

a1 , . . . , a n

subespacio

vectorial

(2.16)

Este problema nos lleva a considerar el conjunto de todos los vectores que se obtienen al

formar combinaciones lineales de a1 , . . . , an , el cual se conoce como el conjunto generado por a1 ,

. . . , an y se denota Gen{a1 , . . . , an }. Entonces, el problema de si la ecuación (2.16) tiene alguna

solución se puede plantear como la cuestión de si b pertenece al conjunto Gen{a1 , . . . , an }.

El subespacio vectorial Gen{a1 , . . . , an }. La suma de dos combinaciones lineales de a1 , . . . , an

es claramente otra combinación lineal de a1 , . . . , an y lo mismo ocurre al multiplicar una combinación lineal de a1 , . . . , an por un número. En consecuencia, si u y v son dos vectores de

Gen{a1 , . . . , an }, su suma es otro vector de Gen{a1 , . . . , an } y el producto de cualquiera de ellos

por un número es también otro vector de Gen{a1 , . . . , an }. Esto hace que el conjunto generado

por los vectores a1 , . . . , an no sea un subconjunto cualquiera de Rn o de Cn sino uno con una

estructura de espacio vectorial, por lo cual se dice que Gen{a1 , . . . , an } es un subespacio vectorial

de Rn (o Cn ).

Sistemas de ecuaciones como ecuaciones vectoriales

La ecuación (2.16) se conoce como una ecuación vectorial en las incógnitas x1 , . . . , xn . Para

resolverla basta reconocer que es equivalente a un sistema de ecuaciones lineales cuya matriz de

coeficientes tiene por columnas los vectores a1 , . . . , an , y cuyo vector de términos independientes

es el vector b.

Recíprocamente: Todo sistema de ecuaciones lineales se puede escribir como una ecuación vectorial

en la que una combinación lineal de las columnas de la matriz de coeficientes del sistema, cuyos pesos son

las incógnitas, está igualada al vector de los términos independientes.

18

Tema 2. Sistemas de ecuaciones lineales

Ejemplo:

2.4. Sistemas de ecuaciones lineales en forma vectorial

Si queremos expresar el vector b como combinación lineal de u, v, w con:

3

1

3

0

b = −1 , u = 0 , v = 4 , w = 1

2

2

−1

2

necesitamos encontrar los coeficientes x1 , x2 , x3 de la combinación lineal x1 u + x2 v + x3 w = b:

1

3

0

3

x1 0 + x2 4 + x3 1 = −1

2

−1

2

2

Esto significa que los números x1 , x2 , x3 tienen que verificar el sistema de ecuaciones lineales:

x1 + 3x2 = 3

4x2 + x3 = −1

2x1 − x2 + 2x3 = 2

Ejercicio: Plantear un sistema de ecuaciones lineales cuyas soluciones sean las distintas formas

de expresar el vector b como combinación lineal de u, v, w con:

4

1

3

0

b = 5 , u = 0 , v = 4 , w = 1 .

3

2

−1

2

Escribir la matriz del sistema.

Volviendo al problema de expresar un vector como combinación lineal de otros, tenemos:

Un vector b es combinación lineal de los vectores a1 , . . . , an si y sólo si el sistema cuya matriz

ampliada tiene por columnas los vectores a1 , . . . , an , b es consistente.

Esto nos da una nueva forma de expresar la existencia de solución de un sistema de ecuaciones lineales:

Un sistema de ecuaciones lineales es consistente si y sólo si el vector de términos independientes es

combinación lineal de las columnas de la matriz de coeficientes.

O también:

Un sistema de ecuaciones lineales es consistente si y sólo si el vector de términos independientes

pertenece al subespacio generado por las columnas de la matriz de coeficientes.

Ejemplo: Supongamos que queremos averiguar si el vector b pertenece al subespacio generado

por los vectores u, v con:

3

1

3

b = −1 , u = 0 , v = 4

2

2

−1

Basta escribir la matriz cuyas columnas son u, v y b y averiguar si el sistema de ecuaciones que

tiene esa matriz es consistente. Para ello basta realizar la fase 1 (eliminación), lo cual haremos

en forma matricial:

1 3

3

1

3

3

1

3

3 F →F + 7 F

F3 → F3 −2F1

3

3 4 2

0 4

0

−1 .

4 −1 −−−−−−→ 0

4 −1 −−−−−−→

2 −1

2

0 −7 −4

0 0 −4 − 47

La última columna contiene un pivote, por tanto el sistema es inconsistente. El vector b no es

igual a una combinación lineal de u y v. No pertenece al subespacio generado por u y v.

19

2.5. Sistemas de ecuaciones lineales en forma matricial: Ax = b Tema 2. Sistemas de ecuaciones lineales

Otra forma de pensar en el proceso de eliminación

Hemos visto dos formas equivalentes de pensar y de realizar el proceso de eliminación

mediante operaciones elementales: Inicialmente lo pensamos como operaciones realizadas sobre

las ecuaciones del sistema y más tarde vimos que esto era equivalente a realizar las operaciones

elementales sobre las filas de la matriz del sistema. Ahora estamos en posición de pensar que

las operaciones elementales se realizan sobre los vectores a1 , . . . , an , b. En una primera etapa

se construyen operaciones elementales que tranformen a1 en un vector cuyo primer elemento

es 1 y los demás cero. etc. Cada vez que aplicamos una operación elemental al sistema o a la

matriz del sistema, podemos pensar que la realizamos sobre cada vector columna de la matriz

del sistema. La conclusión de esto es la siguiente:

Si un vector b es combinación lineal de a1 , . . . , an , el vector b0 obtenido al realizar una o varias

operaciones elementales sobre b es también combinación lineal —y con los mismos coeficientes— de los

vectores a10 , . . . , a0n obtenidos al realizar dichas operaciones elementales sobre los vectores a1 , . . . , an .

2.5.

Sistemas de ecuaciones lineales en forma matricial: Ax = b

Hemos visto que un sistema de m ecuaciones lineales en n incógnitas es equivalente a una

sola “ecuación vectorial” en n incógnitas que consiste en una combinación lineal (cuyos coeficientes son las n incógnitas) igualada a un vector. Ahora bien, una combinación lineal (de las

columnas de una matriz) es justamente lo que se obtiene al multiplicar una matriz por un vector.

Esto nos motiva a tomar la combinación lineal como definición del producto matriz por vector.

Definición del producto de matriz por vector. Sean A una matriz y sean los vectores a1 , . . . , an

las columnas de A. Si x es un vector de Rn , el producto de la matriz A por el vector x se define como

Definición del

la combinación lineal de los vectores a1 , . . . , an con coeficientes las componentes de x, es decir:

producto de una

matriz por un

x1

vector.

.

Ax = a1 a2 . . . an .. = x1 a1 + · · · + xn an .

xn

Según esta definición del producto de una matriz por un vector, el sistema de ecuaciones

lineales cuya matriz ampliada tiene por columnas los vectores a1 , . . . , an , b y cuya representación

vectorial es la ecuación

x1 a1 + · · · + xn an = b,

tiene el mismo conjunto solución que la ecuación matricial

Ax = b.

Por tanto podemos decir:

Para cualquier matriz A, la ecuación Ax = b tiene alguna solución si y sólo si b es una combinación

lineal de las columnas de A.

Sistemas que son consistentes para cualesquiera términos independientes

Nos planteamos ahora la cuestión de qué condiciones tiene que cumplir la matriz de coeficientes de un sistema de ecuaciones lineales para que el sistema sea consistente cualesquiera

que sean los términos independientes que pongamos. Planteado en términos de la ecuación matricial asociada al sistema, la cuestión es qué condición debe cumplir una matriz A para que la

ecuación matricial Ax = b tenga solución cualquiera que sea el vector b. Evidentemente esto es

20

Tema 2. Sistemas de ecuaciones lineales 2.5. Sistemas de ecuaciones lineales en forma matricial: Ax = b

lo mismo que pedir que el conjunto generado por las columnas de A sea todo Rm (o Cm ) donde

m es el número de componentes de cada columna de A (o sea, el número de filas de A).

Una condición suficiente es que la forma escalonada reducida de A no tenga ningnua fila

de ceros, pues si esto se cumple ningún vector de términos independientes puede dar lugar a

un sistema inconsistente. Por otro lado esa condición también es necesaria porque si la forma

escalonada reducida de A tuviese una fila de ceros sería fácil construir un vector de términos

independientes tal que en la forma escalonada reducida tuviese un pivote y el sistema fuese

inconsistente. Llegamos, pues, al siguiente:

Teorema Sea A una matriz real y sea m el número de filas de A (lo que es decir que las

columnas de A son vectores de Rm ). Entonces, las siguiente afirmaciones son equivalentes:

1. La ecuación Ax = b tiene solución cualquiera que sea que sea el vector de términos

independientes b.

2. Todo vector b de Rm es combinación lineal de las columnas de A.

3. El espacio generado por las columnas de A es todo Rm (“las columnas de A generan Rm ”).

4. Una forma escalonada de A no tiene ninguna fila de ceros.

5. A tiene m posiciones pivote.

6. Todas las filas de A tienen una posición pivote.

Análogamente, si A es una matriz compleja, son equivalentes los mismos enunciados tras poner

Cm donde pone Rm .

Corolario Sea A una matriz real de m filas cuyas columnas generan todo Rm . Entonces el

número de columnas de A es mayor o igual que m (ya que A tiene m columnas pivote).

Cálculo del producto matriz por vector por la regla “fila por columna”

La forma de calcular el producto de una matriz A por un vector x que nos viene sugerida

por la definición del mismo como “combinación lineal”, consistiría en reescalar cada columna

de la matriz A usando como factor la correspondiente componente del vector x y después sumar

todas las columnas reescaladas. El resultado sería un vector que sería el producto Ax.

Hay otra forma de obtener el mismo resultado, que se conoce como la “regla fila por columna”. Esta regla ya la hemos usado en la propia definición del producto matriz por vector y

consiste exactamente en lo que la definición implica para una matriz que sólo tenga una fila.

La regla fila por columna consiste en imaginar a nuestra matriz como formada por filas; multiplicamos cada una de estas filas por el vector dado con lo que cada uno de estos resultados es

un número. El resultado final es el vector columna formado por todos estos números.

Propiedades de linealidad del producto matriz por vector Ax

De la definición del producto de matriz por vector y de las propiedades de las operaciones

con vectores se deduce fácilmente las siguientes propiedades llamadas propiedades de linealidad:

1. A(u + v) = Au + Av.

2. A(cu) = c( Au).

21

2.6. Conjuntos solución de los sistemas de ecuaciones lineales

2.6.

Tema 2. Sistemas de ecuaciones lineales

Conjuntos solución de los sistemas de ecuaciones lineales

Forma vectorial paramétrica de la solución

Forma vectorial

paramétrica de

la solución.

El uso de vectores nos permite escribir las ecuaciones paramétricas del conjunto solución

de un sistema de ecuaciones lineales en una forma especialmente simple y reveladora: La forma

vectorial paramétrica, que es la siguiente:

x = p + t1 u1 + · · · + t k u k ,

(2.17)

donde se ha supuesto que k es el número de variables libres que tiene el sistema y en la solución

aparecen tantos parámetros como variables libres tenía el sistema. Así pues, según la forma

vectorial paramétrica, todas las soluciones del sistema se obtienen sumando a un vector fijo,

p, todas las combinaciones lineales de ciertos vectores, u1 , . . . , uk , cuyo número es igual al de

variables que libres tenía el sistema.

Conocidas la ecuaciones paramétricas del conjunto solución, es muy sencillo ponerlas en la

forma vectorial (2.17) porque ello no requiere ningún cálculo adicional, solamente es necesario

reescribir dichas ecuaciones. Por ejemplo, para las ecuaciones paramétricas

x1 = 1 + 11x3

x2 = 2 − x3

x4 = −1 − 6x3

(x3 libre), la forma vectorial es la siguiente:

x1

11

1

x2 2

= + t −1 . o sea: x = p + tu

x3 0

1

−6

−1

x4

11

1

−1

2

p=

0 , u = 1 .

−6

−1

con:

¿Cómo se consigue llegar a esto? Para conseguirlo hacemos lo siguiente:

1. Primeramente, para cada una de las variables libres xi , añadimos la identidad xi = xi y

escribimos las incógnitas en orden:

x1 = 1 + 11x3

x2 = 2 − x3

x3 = x3

x4 = −1 − 6x3 .

2. Después escribimos estas ecuaciones en forma vectorial, para lo cual escribiremos la columna de coeficientes de cada variable libre multiplicada por la misma y una columna de

términos independientes si los hubiera:

x1

1

11

x2 2

= + x3 −1 .

x3 0

1

x4

−1

−6

3. Finalmente podemos sustituir los nombres de las variables libres en los miembros de la

derecha por nuestros nombres favoritos de parámetros, y así es como hemos llegado a lo

escrito más arriba, donde se ha usado como parámetro la letra t en lugar de x3 .

22

Tema 2. Sistemas de ecuaciones lineales

2.6. Conjuntos solución de los sistemas de ecuaciones lineales

Ejercicio resuelto:

Suponiendo que las ecuaciones paramétricas del conjunto solución de cierto sistema son las

siguientes:

x1 = −5x2 , x3 = 3 − x2 + 2x4 (x2 y x4 libres),

escribir la solución general del sistema en forma vectorial paramétrica.

Solución:

Siguiendo los pasos indicados antes,

(1) Para cada una de las variables libres xi (que aparecen en los miembros de la derecha),

añadimos la identidad xi = xi :

x1 = −5x2 ,

x2 = x2

x3 = 3 − x2 + 2x4 ,

x4 = x4 .

(2) Después escribimos estas ecuaciones en forma vectorial, para lo cual escribimos la columna de coeficientes de cada variable libre multiplicada por la misma y una columna de términos

independientes:

0

x1

−5

0

0

x2 0

1

= + x2 + x4 .

2

x3 3

−1

1

0

0

x4

(3) Sustituimos los nombres de las variables libres en los miembros de la derecha por nuestros nombres favoritos de parámetros:

0

−5

0

0

x1

−5

0

0

1

0

0

x2 0

1

= + s + t , o: x = p + s u + t v con p = , u = , v = .

x3 3

2

−1

3

2

−1

1

0

0

1

0

0

x4

Caso homogéneo

Un sistema de ecuaciones lineales homogéneo es automáticamente consistente ya que tiene

una solución obvia que consiste en todas las incógnitas iguales a cero. Esta solución se llama la

solución trivial. La única cuestión, pues, para estos sistemas es la cuestión de unicidad, es decir,

si el sistema es determinado o no. Esta cuestión es equivalente a la de si el sistema tiene o no

alguna variable libre: si tiene, hay infinitas soluciones, si no, la única solución es la trivial.

Para un sistema de ecuaciones lineales homogéneo, la columna de la derecha de la matriz

del sistema tiene todos los elementos iguales a cero y esto sigue siendo así en cualquier matriz

obtenida de ella mediante operaciones elementales de filas; por tanto, también en la forma

escalonada reducida de la matriz del sistema todos los elementos de la columna de la derecha

son cero. Esto implica que al escribir la solución en la forma vectorial paramétrica (2.17) el

vector p es igual a cero. Por tanto, si un sistema homogéneo tiene k variables libres, su solución

en forma vectorial tiene la forma:

x = t1 u1 + · · · + t k u k .

(2.18)

Por ejemplo, supongamos que un sistema homogéneo tenga dos variables libres. Entonces al

escribir su solución en forma vectorial paramétrica encontramos dos vectores u, v tales que la

solución es:

x = su+tv

23

2.6. Conjuntos solución de los sistemas de ecuaciones lineales

Tema 2. Sistemas de ecuaciones lineales

Lo cual nos dice que el conjunto solución es el plano generado por los vectores u y v, es decir,

el conjunto de todos los vectores que son combinación lineal de u y v.

Propiedades de la forma vectorial paramétrica de la solución de un sistema homogéneo

Los vectores u1 , . . . , uk que se obtienen al expresar la solución de un sistema homogéneo

en la forma vectorial paramétrica (2.18) tienen dos propiedades muy importantes que se pueden expresar como propiedades de la matriz U = [u1 · · · uk ] cuyas columnas son los vectores

u1 , . . . , uk . La primera es evidente:

El conjunto solución del sistema homogéneo es el conjunto generado por las columnas de U:

Conjunto solución = Gen{u1 , . . . , uk }

La segunda propiedad es menos evidente pero es muy importante y se deduce del hecho de

que U tiene, para cada variable libre x j (y, por tanto, para cada columna) una fila con solamente

un elemento distinto de cero (e igual a 1), el cual está en la columna j. Mediante una reodenación

de las filas de U se llega a una forma escalonada cuyas últimas k filas forman una matriz

identidad k × k. En consecuencia:

Todas las columnas de U son columnas pivote (U tiene exactamente k pivotes).

Caso no-homogéneo

En el caso de un sistema no homogéneo de ecuaciones lineales, Ax = b, supongamos que p

es una solución particular, es decir, que el vector p cumple Ap = b. Entonces para todo vector

vh que sea solución del sistema homogéneo asociado (es decir, que Avh = 0) se cumplirá que

p + vh es una nueva solución del sistema completo:

A(p + vh ) = Ap + Avh = b + 0 = b

Además, toda solución del sistema Ax = b es igual a p sumado a una solución del sistema homogéno

asociado. Para convencernos de ello basta ver que x − p es una solución del sistema homogéno

asociado:

A(x − p) = Ax − Ap = b − b = 0.

Resumiendo: La solución general de un sistema no homogéneo de ecuaciones lineales se obtiene

sumando una solución particular del mismo a la solución general del sistema homogéneo asociado.

Al escribir en forma vectorial paramétrica la solución de un sistema no homogéneo de ecuaciones lineales,

x = p + t1 u1 + · · · + t k u k ,

el vector p es siempre una solución particular del sistema (es la solución para t1 = t2 = · · · =

tk = 0. Esto implica que la solución general del sistema homogéneo asociado es:

x = t1 u1 + · · · + t k u k ,

En consecuencia, El conjunto solución de un sistema no homogéneo de ecuaciones lineales es el resultado

de trasladar, mediante una solución particular del mismo, el conjunto solución del sistema homogéneo

asociado.

24

© Copyright 2026