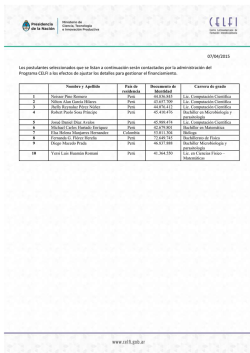

Descargar memorias - CITIC - Universidad de Costa Rica