Teoría de la información

Teoría de la

información

JOSE LUIS PEREA VEGA

Red Tercer Milenio

TEORÍA DE LA INFORMACIÓN

TEORÍA DE LA INFORMACIÓN

JOSE LUIS PEREA VEGA

RED TERCER MILENIO

AVISO LEGAL

Derechos Reservados 2012, por RED TERCER MILENIO S.C.

Viveros de Asís 96, Col. Viveros de la Loma, Tlalnepantla, C.P. 54080, Estado de México.

Prohibida la reproducción parcial o total por cualquier medio, sin la autorización por escrito del titular de

los derechos.

Datos para catalogación bibliográfica

José Luis Perea Vega

Teoría de la información

ISBN 978-607-733-034-9

Primera edición: 2012

Revisión editorial: Eduardo Durán Valdivieso

DIRECTORIO

José Luis García Luna Martínez

Director General

Jesús Andrés Carranza Castellanos

Director Corporativo de Administración

Rafael Campos Hernández

Director Académico Corporativo

Héctor Raúl Gutiérrez Zamora Ferreira

Director Corporativo de Finanzas

Bárbara Jean Mair Rowberry

Directora Corporativa de Operaciones

Alejandro Pérez Ruiz

Director Corporativo de Expansión y

Proyectos

ÍNDICE

Introducción

3

Mapa conceptual

4

Unidad 1. Sistemas de comunicación

5

1.1. MODELO BÁSICO

1.2. REDES DE COMPUTADORAS

Autoevaluación

8

13

19

Unidad 2. Codificación

21

2.1 TIPOS DE CÓDIGOS

2.2 COMPRESIÓN

2.3 CRIPTOGRAFÍA

2.4 ERRORES

Autoevaluación

24

37

42

43

46

Unidad 3. Transmisión

48

3.1 ESPECTRO ELECTROMAGNÉTICO

3.2 MEDIOS

3.3 MODOS

3.4 TÉCNICAS

3.5 SEÑALES

Autoevaluación

52

54

60

60

62

64

Unidad 4. Teorías de la información

66

4.1 CLÁSICA

4.2 CUÁNTICA

Autoevaluación

Bibliografía

Glosario

69

75

85

87

88

2

INTRODUCCIÓN

Algunas décadas anteriores a la era cristina el gobernador romano Julio Cesar

utilizaba un método que usaba la trasposición de letras para proteger sus

mensajes. A lo largo de la historia se han buscado técnicas de protección para

la información, el desarrollo de nuevas tecnologías se acelera bajo condiciones

de guerra como en el caso de la segunda guerra mundial donde se dio una

carrera por descifrar comunicaciones entre alemanes y aliados. Bajo estas

circunstancias emergió la computadora electrónica para aplicaciones militares y

científicas cuya arquitectura seguimos utilizando. La búsqueda de mayores

velocidades y capacidad de cálculo junto con la reducción de tamaño ha llegado

al límite de la materia, en este punto el comportamiento físico cambia, pasando

de la certidumbre

a la presencia del azar, dando origen a la computadora

cuántica que incrementa exponencialmente su potencia con respecto a su

antecesora. Ante este panorama el manejo de la información tiene nuevos retos

debiendo cuidar la representación física y lógica de los datos.

El uso de componentes cuánticos promete dar solución a problemas que

con la capacidad de cómputo actual tardarían demasiado tiempo en resolverse,

sin embargo esta misma característica se usa como mecanismo de protección

de datos cuando se hacen algunas transacciones electrónicas, requiriendo la

búsqueda de nuevos sistemas de seguridad para la información antes de que

las computadoras cuánticas se comercialicen.

3

MAPA CONCEPTUAL

La

Información

enlaza

Sistemas de

comunicación

utilizando

Códigos

que son

Transmitidos

con fundamentos

Teóricos

4

UNIDAD 1

SISTEMAS DE COMUNICACIÓN

OBJETIVO

El estudiante comprenderá la estructura y las bases físicas que permiten el

funcionamiento e interconexión de los sistemas de comunicación.

TEMARIO

1.1. MODELO BÁSICO

1.1.1. FUENTE

1.1.2. TRANSMISOR

1.1.3. CANAL

1.1.4. RECEPTOR

1.1.5. DESTINO

1.1.6. MENSAJE

1.1.7. SEÑAL

1.1.7.1.

ANALÓGICA

1.1.7.2.

DIGITAL

1.1.8. RUIDO

1.2. REDES DE COMPUTADORAS

1.2.1. CLASIFICACIÓN

1.2.2. PROTOCOLOS

1.2.3. TOPOLOGÍAS

5

MAPA CONCEPTUAL

Un

Sistema de

comunicación

requiere de una

Fuente

alimentando a un

Transmisor

preparando el

Mensaje

enviado por

Canales

mediante

Señales

hacia uno o más

Receptores

pudiendo formar

Redes

utilizando

Protocolos

organizadas mediante

Topologías

6

INTRODUCCIÓN

Los lenguajes han permitido que evolucionemos como sociedad haciendo

posible

compartir

conocimientos;

así,

para

llevarlo

a

cabo

mediante

computadoras y otros equipos, se han desarrollado técnicas que logran

traducciones de la forma más confiable, utilizando herramientas matemáticas y

tecnológicas.

7

1.1 MODELO BÁSICO

En su libro El arte de la guerra, Sun Tzu dedica una parte al espionaje,

resaltando la importancia de conocer la información acerca de los planes del

oponente. En la antigüedad, el emperador Julio Cesar utilizó un método para

proteger los mensajes que enviaba, mediante el corrimiento de los caracteres

del alfabeto: A se convierte en D, B en E y así sucesivamente. A este proceso

se le denomina codificación y se dice que el mensaje resultante está cifrado.

Durante la Segunda Guerra Mundial, el ejército alemán utilizó un equipo

de codificación electromecánico llamado Enigma, éste fue inventado por

Alexander Koch en 1919 y comercializado en 1920 en tres versiones, una era

portátil, sin impresora y representaba luminosamente las letras. Su mecanismo

se basaba en rotores, cada uno de los cuales aumentaba la complejidad del

cifrado, tuvieron entre tres y cinco. La necesidad de conocer el contenido los

mensajes motivó a los ingleses a implementar un centro conocido como

Bletchley Park, ubicado en una mansión en Buckinghamshire, ahí también se

utilizó la primera computadora británica llamada Colossus en febrero de 1944,

diseñada por Tommy Flowers estaba constituida por más de 1500 tubos de

vacío, los cuales podían representar cero o uno, estos dos valores representan

el sistema mínimo de información, a tal sistema se le denomina binario y fue

propuesto por el matemático alemán Leibniz en el siglo XVII.

Dentro de la computadora, cada cero o uno recibe el nombre de bit

(acrónimo de binary digit) término acuñado por John Tuckey a finales de la

década de 1940, se utiliza esta representación porque es más fácil

implementarla mediante circuitos; uno de los trabajos pioneros en este sentido

fue presentado como tesis doctoral por el ingeniero eléctrico estadounidense

Claude Shannon, obteniendo su grado en matemáticas. En 1948 publicó A

Mathematical Theory of Communication en donde aborda dos problemas

fundamentales:

El nivel de compresión de los mensajes de tal forma que sea más

eficiente la comunicación en ausencia de interferencia.

8

Si existen interferencias, cuán repetitivo debe ser el mensaje.

Por este trabajo a Shannon se le conoce como padre de la teoría de la

información, lo elaboró mientras trabajaba para BELL TELEPHONE LABORATORIES.

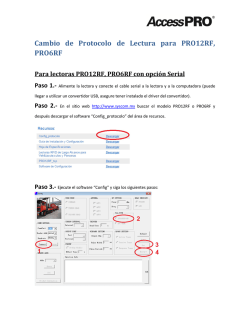

Esquematiza el proceso de comunicación como sigue:

Fuente de

informació

Transmis

n

or

Señal

Señal

Recepto

Destin

recibida

r

o

Mensaje

Mensaje

Fuente

de ruido

1.1.1. Fuente

Es en donde se genera el mensaje que puede ser de diferentes tipos:

Secuencias de caracteres de un alfabeto determinado.

Funciones matemáticas que dependan del tiempo como el caso de la

radio frecuencia.

Funciones matemáticas que dependan de diversas variables como las

coordenadas de posición y algún otro parámetro, por ejemplo los puntos

de color (pixeles) en la pantalla de una computadora, o ubicación y

brillantez en un dispositivo monocromático.

Funciones combinadas, fenómeno que se presenta cuando se envían

audio y video simultáneamente.

9

www.karbosguide.com

1.1.2. Transmisor

Codifica y transforma el mensaje de tal forma que pueda ser enviado a través

de un medio. Por ejemplo: en la transmisión radial con amplitud modulada (AM),

la frecuencia de audio (denominada moduladora) se convierte en frecuencia de

radio cuando se mezcla con una señal adicional (conocida como portadora) que

proviene de otra fuente, pasando de un rango de 300 Hz a los 3.4 kHz, a otro

que va de 535 kHz hasta 1.7 MHz. Un hercio (Hz) es la unidad que representa

un ciclo por segundo).

www.karbosguide.com

www.technologyuk.net

10

1.1.3. Canal

Es el medio a través del cual viaja la información, puede ser cableado o

inalámbrico. La capacidad del canal es la velocidad máxima de transmisión,

mientras que el ancho de banda determina la tasa de transferencia

(unidades/tiempo). El ingeniero sueco Harry Nyquist estableció una expresión

que relaciona las magnitudes anteriores: dado un ancho de banda B, la mayor

velocidad de transmisión de la señal que se puede conseguir es 2B, suponiendo

que se trata de un medio ideal (carente de ruido) y que el mensaje está

compuesto por bits, involucrando solamente dos niveles de tensión.

1.1.4. Receptor

Hace la función inversa del transmisor.

1.1.5. Destino

Es el punto final de llegada para el mensaje.

1.1.6. Mensaje

Existe otro enfoque acerca de la teoría de la información, fue desarrollado por el

matemático Norbert Wiener, para él resultaban importantes los mensajes que

se envían por y a través de los seres vivos, dentro de su medio así como en su

interior, lo que permite a un ser humano coordinar los movimientos de la mano

para alcanzar un vaso, a partir de impulsos eléctricos enviados por las

neuronas. Este proceso también se puede llevar a cabo usando máquinas, tal

como los robots que desactivan bombas. Wiener presentó sus estudios en el

libro Cibernética en 1948.

1.1.7. Señal

La comunicación entre dos entidades se logra a través de señales, que pueden

ser discretas o continuas. Las primeras toman un número limitado de valores y

11

reciben el nombre de digitales mientras que las segundas tienen un

comportamiento de onda y se conocen como analógicas. Como ejemplo se

puede comparar un mensaje en código Morse contra su versión hablada.

Al proceso que selecciona un número de valores discretos a partir de una

señal continua, se le conoce como muestreo. La tasa o frecuencia de muestreo,

es la cantidad de mediciones que se hacen por unidad de tiempo. Después de

realizar el muestreo se requiere de un procedimiento conocido como

cuantificación, que se encarga de asignar a cada valor dentro de cierto rango,

su equivalente en código binario, tomando en cuenta que el número de bits

define los límites de los rangos.

1.1.7.1.

Analógica

Representan magnitudes físicas como la temperatura, luz, sonido o energía. Su

representación gráfica describe una onda senoidal.

1.1.7.2.

Digital

Toda la información se manda como bits independientemente de su contenido,

señales de audio y video deben ser preparadas para su transmisión si

12

provienen de fuente analógicas, tal como sucede cuando se hace una llamada a

través del chat.

1.1.8. Ruido

A las señales no deseadas que contaminan el mensaje, se les denomina ruido.

Éste se puede clasificar en:

Térmico. Lo genera la agitación de los electrones en función de la

temperatura, a veces se le denomina ruido blanco y no se le puede

suprimir.

Intermodulación. Aparece cuando distintas frecuencias comparten un

medio, combinándose mediante la suma, resta o multiplicación de las

mismas, creando una nueva señal.

Diafonía. Se produce cuando una transmisión se contamina con otra,

como en el caso de escuchar otra conversación mientras se habla por

teléfono.

Impulsivo. A diferencia de los anteriores tipos, no es de magnitud

constante, presenta picos de corta duración y de gran amplitud, puede

originarse por condiciones meteorológicas o por fallas en los sistemas de

comunicación.

ACTIVIDAD DE APRENDIZAJE

Busca en Internet un simulador de la máquina Enigma e investiga su

funcionamiento.

1.2 REDES DE COMPUTADORAS

La computadora por sí misma representa un sistema de comunicación

completo, recibe datos a través del teclado que son procesados para

presentarse en la pantalla y ser almacenados o impresos. Con el mismo

surgimiento de la computadora se presentó la necesidad de interconectarlas,

13

con el propósito de aumentar la capacidad de procesamiento así como también

la compartición de datos, dispositivos de almacenamiento, impresión y

comunicación.

1.2.1 Clasificación

Las redes se pueden clasificar de acuerdo con su extensión geográfica en:

PAN (Personal Area Network). Formada a partir de los diferentes

dispositivos

de

comunicación

que

puede

tener

una

persona:

computadora, celular, PDA, consola de juegos.

LAN (Local Area Network). Es la más común ya que puede abarcar uno o

varios edificios.

MAN (Metropolitan Area Network). Abarcan a ciudades o algunos tipos

de organizaciones que tienen muchas sucursales como los bancos o

cadenas comerciales.

WAN (Wide Area Network). Es la unión de todas la anteriores, en esta

categoría se ubica Internet.

También existen otros tipos de acuerdo con la función que desempeñan:

SAN (Storage Area Network). Son redes dedicadas a transferir datos

entre servidores evitando el tráfico de las redes compartidas.

VPN (Virtual Private Network). Se implementa usando la infraestructura

de Internet pero creando una conexión personalizada más segura.

1.2.2. Protocolos

Un protocolo es un conjunto de reglas y convenciones que permiten la

comunicación. Para hacer compatibles las redes se creó en 1984 el modelo OSI

(interconexión de sistemas abiertos, por sus siglas en inglés) que consta de

siete capas, cada una con sus protocolos que van modificando el mensaje

desde que lo escribe el usuario hasta que sale a través de un cable o antena.

14

Existen protocolos enfocados a la seguridad de la información que son

indispensables cuando se hacen compras o transacciones bancarias mediante

Internet.

1.2.3. Topologías

La topología establece la estructura de la red, existen dos categorías:

Física. Está determinada por el patrón geométrico que forman los

equipos conectados.

Lógica. Se establece a partir de las rutas que deben seguir los datos a

través de la red.

Las que se usan generalmente son:

Los datos viajan por

Anillo

cada

uno

de

equipos

los

hasta

encontrar su destino.

Es la más utilizada

porque la conexión de

Estrella

cada

equipo

no

de

la

depende

disponibilidad de los

demás.

Es muy vulnerable ya

que requiere que todos

Bus

los equipos no fallen

para

seguir

funcionando.

15

Puede

Jerárquica

tener

desempeño

tiene

mayor

menor

pero

se

control

sobre el flujo de datos.

Malla

Es la estructura que

tiene Internet

ACTIVIDAD DE APRENDIZAJE

Investiga cuáles son las diferencias en entre los modelos de capas OSI y

TCP/IP.

EJEMPLOS DE APLICACIÓN1

Debido a que el mundo físico lo percibimos mediante señales analógicas, es

necesario realizar procesos de conversión antes de poderlas introducir a la

computadora. Dos sentidos que nos permiten interactuar con los demás son la

vista y la audición, cuando los procesamos en el cerebro, nos permiten dar una

respuesta mediante la voz o de alguna otra forma que constituya un lenguaje. A

continuación se presentan algunos dispositivos electrónicos encargados de

hacer éstas tareas a través de ordenadores.

MODEM

El modem (modulador-demodulador) fue desarrollado con fines militares

durante la década de 1950 para la comunicación de datos. La existencia de una

red telefónica para la transmisión de voz que podría ser aprovechada, requirió

1

Tomado de Lógica computacional, (IN04) Aliat Universidades, 2010.

16

que se diseñara un dispositivo capaz de convertir bits en señales audibles, que

pudieran viajar a través de las líneas existentes.

© Facultat d'Informàtica de Barcelona

AT&T

lanzó al mercado un modem con una tasa de transmisión de 300

bits por segundo en el año 1962 usando FSK. En 1996, el doctor Townshed

desarrolló uno que podía enviar 56Kb.

Al proceso de transportar datos a través de ondas variando su frecuencia

(pitch), se le conoce como modulación. Una de estas técnicas se denomina

Frecuency-shift keying (FSK), su versión más simple es la binaria o BFSK, la

cual utiliza dos tonos: marca, que representa uno; y espacio, equivalente a cero.

Una vez que la señal llega a su destino se utiliza el proceso inverso

conocido como demodulación.

17

NAVEGACIÓN MEDIANTE VOZ

Los sistemas de navegación que permiten interactuar a través de la voz,

necesitan reducir las interferencias provocadas por la gran cantidad de sonidos

provenientes del medio ambiente.

La voz del conductor es recibida por un micrófono y filtrada para quitar el

eco y eliminar ruidos, también se debe distinguir entre solicitudes del usuario y

respuestas generadas por el sistema para no producir ciclos, como quien ve a

su sombra de forma que fuera otra persona.

A continuación, las ondas son recibidas por el sistema de análisis de voz,

capaz de reconocer fonemas y construir frases, que serán digitalizadas y

procesadas para producir respuestas en forma de audio, que puedan ser

usadas por el conductor.

18

AUTOEVALUACIÓN

Elige el inciso correcto.

A. Es la topología que permite la menor dependencia de los equipos.

a) Jerárquica

b) Bus

c) Estrella

d) Anillo

c) Diafonía

d) Impulsivo

B. A veces es llamado ruido blanco.

a) Térmico

b) Intermodular

C. Desarrolló el sistema binario de numeración.

a) Leibniz

b) Shannon

c) Koch

d) Wiener

D. Es un tipo de señal que toma un número limitado de valores.

a) Analógica

b) Digital

c) Modulada

d) Portadora

E. Es conocido como el padre de la teoría de la información.

a) Shannon

b) Wiener

c) Flowers

d) Leibniz

Completa las frases.

F. Los canales de comunicación pueden ser

G. La frecuencia se mide en

H. La función de un transmisor es

______

.

.

_____________________________.

.

I. Un protocolo es ________________________________________________

.

J. Un medio ideal es el que

.

RESPUESTAS DE LA AUTOEVALUACIÓN

A. c.

B. a.

C. a.

D. b.

E. a.

F. Cableados e inalámbricos.

G. Hercios.

19

H. Codificar y transformar el mensaje.

I. Un conjunto de reglas y convenciones que permiten la comunicación.

J. Está libre de ruido.

20

UNIDAD 2

CODIFICACIÓN

OBJETIVO

El alumno comprenderá los procesos de transformación entre símbolos que

representan datos para su procesamiento, transmisión, protección y manejo de

errores.

TEMARIO

2.1. TIPOS DE CÓDIGOS

2.1.1. BINARIOS

2.1.1.1.

BAUDOT

2.1.1.2.

ASCII

2.1.1.3.

EBCDIC

2.1.2. ALGEBRAICOS

2.1.3. LINEALES

2.1.3.1.

HAMMING

2.2. COMPRESIÓN

2.2.1. LOSSLESS

2.2.2. LOSSY

2.2.3. CÓDIGO SHANNON-FANO

2.2.4. CÓDIGO HUFFMAN

2.3. CRIPTOGRAFÍA

2.4. ERRORES

2.4.1. NATURALEZA DE LOS ERRORES

2.4.2. ALGORITMOS DE DETECCIÓN

2.4.2.1.

PARIDAD

2.4.2.2.

CHECKSUM

2.4.2.3.

REDUNDANCIA CÍCLICA

21

MAPA CONCEPTUAL

Los

Datos

se

Codifican

usando

Métodos

buscando su

Binarios

Polinomiale

s

Estadístico

s

Compresión

protegiéndolos

mediante

Criptografía

con el adecuado

manejo de

Errores

22

INTRODUCCIÓN

En la evolución de los modelos que permiten el procesamiento automático de

datos, se han utilizado las herramientas matemáticas más diversas, desde la

estadística hasta el álgebra abstracta, así como todos los avances de la física

de semiconductores, con un sólo propósito: lograr que la información sea

completamente confiable, oportuna y segura.

23

2.1 TIPOS DE CÓDIGOS

Un código crea una correspondencia entre los elementos de un conjunto con

otro. Los códigos de bloque dividen la información en paquetes de menor

tamaño mientras que los convolucionales manejan el mensaje completo, en

donde cada elemento codificado depende de los anteriores.

2.1.1 Binarios

El sistema binario utiliza el mínimo conjunto de símbolos para representar

información. Está formado por cero y uno, a cualquiera de los dos valores lo

llamaremos bit. La agrupación de ocho bits la denominaremos byte, con el cual

se pueden formar 256 combinaciones distintas. Si hacemos la representación

usando ocho casillas, la primera puede contener dos números posibles, por

cada uno la siguiente tendría otros dos y así sucesivamente.

2 x 2 x 2 x 2 x 2 x 2 x 2 x =28=256

2

Con n bits se obtienen 2n combinaciones.

La representación del número 10112 sería la siguiente:

3

2

1

0

1

0

1

1

2

Por ser un sistema numérico posicional se eleva la base a cada

exponente haciendo la suma:

1x23 + 0x22 + 1x21 + 1x20 = 1x8 + 0x4 + 1x2 + 1x1 = 11

Se ha encontrado que 10112 = 1110. De esta forma se convierten

números en base dos a base 10. Para realizar el procedimiento inverso se

llevan a cabo los siguientes pasos:

Paso 1. Se traza una línea divisoria y se escribe el número en base 10 en

la parte superior izquierda.

11

24

Paso 2. Se divide el número entre dos y se anula el decimal del cociente

(si es que lo tiene).

11

5.5

Paso 3. Se repite el paso dos hasta llegar a uno.

11

5

2

1

Paso 4. Se copia el uno a la parte inferior derecha.

11

5

2

1

1

Paso 5. Al lado derecho de cada número impar se escribe uno y si es

par, cero.

11 1

5

1

2

0

1

1

Paso 6. Se copian los números del lado derecho de abajo hacia arriba y

se acomodan de izquierda a derecha.

11 1

5

1

2

0

1

1

10112

25

Con este procedimiento se ha convertido 1110 en 10112.

Para realizar una suma en base 10 con los números nueve y uno.

1

+

9

Cada vez que la suma de

1

dos números es 10 o más

se dice que “llevamos uno”

0

poniéndolo

arriba

a

la

izquierda de los sumandos.

9

+

1

1

0

De la misma forma, en sistema binario cada vez que la suma de dos

números es igual a la base, escribimos cero debajo de los sumandos y

“llevamos uno”.

1

1

+

1

1

0

2

Si hay tres sumandos o más, la suma se obtiene trabajando con dos a la

vez. Ejemplo:

1

1

+

1

1

2

1

1

26

+

1

0

2

1

1

1

+

1

1

0

+

1

1

1

2

2

1

1

1

+

1

0

0

2

2.1.1.1 Baudot

El matemático alemán Friedrich Gauss junto a Wilhelm Weber, implementaron

un telégrafo mediante un código que desarrollaron en 1833. Sobre esta base el

francés Émile Baudot creó un código de cinco bits en 1870 que se operaba a

través del uso de cinco dedos. En el álbum X&Y del grupo británico Coldplay se

ha utilizado una versión estilizada de esta técnica.

27

Ejemplo de código Baudot

© www.nadcomm.com

2.1.1.2 ASCII

Un código ampliamente usado es el ASCII (american standard code for

information interchange) que representa, mediante números, los caracteres del

alfabeto latino. Usa siete bits para llevar a cabo esta equivalencia.

2.1.1.3 EBCDIC

En 1964 IBM anunció el lanzamiento de la familia de computadoras 360 desde

el modelo 20 (minicomutadora) hasta el 91 (supercomputadora), para lo cual

desarrolló el EBCDIC (extended binary coded decimal interchange) utilizando

ocho bits que forman un byte o dos nibbles. Cada nibble se usa como

coordenada de una tabla, el de lado izquierdo se denomina zona mientras que

el derecho se llama número.

28

©www.tpub.com

2.1.2 Algebraicos

La aritmética modular fue introducida por Gauss (llamado el príncipe de las

matemáticas), en 1801 mediante el estudio de la congruencia. Un número a es

congruente con otro representado por b si al dividir a cada uno entre c se

obtiene el mismo residuo, simbolizándose como:

ab mod c

Ejemplo 1.

57 mod 2 ya que 5=2(2)+1 y 7=2(3)+1

Ejemplo 2.

2311 mod 12

2210 mod 12

219 mod 12

Ésta es la representación que se usa para las horas, por tal razón, a la

aritmética modular también se le denomina aritmética de reloj, necesitando solo

12 símbolos, aunque el número de horas aumente indefinidamente.

29

El procedimiento anterior se puede realizar con polinomios, comparando

los residuos al dividirlos.

Ejemplo 3. División de polinomios.

x+3

x+1 x2+4x+11

-x2-x

3x+11

-3x-3

8

x-5

x+1 x2-4x+3

-x2-x

-5x+3

5x+5

8

Partiendo de los resultados se puede decir que el polinomio x2+4x+11 es

congruente con x2-4x+3 módulo x+1. Clasificándose como sigue:

Polinomio

Tipo

Característica

Se puede expresar como

x2+4x+11

Reducible

resultado de

operaciones con otros

polinomios.

x+5

Irreducible

No se puede reducir.

Es irreducible y genera a

los demás polinomios de

x+1

Primitivo

primer grado, éste es el

valor de la potencia más

alta de la variable x.

30

El matemático francés Evariste Galois (quien murió a los 20 años en un

duelo) estudió los polinomios y sus operaciones, utilizando una estructura

denominada campo finito también conocida como campo de Galois que se

representa por GF(p) siendo p un número primo, esto significa que sólo se

puede dividir entre sí mismo y la unidad. El valor de p indica el número de

elementos del campo, conocido como orden o cardinalidad. Si p=2k se dice que

es un campo de extensión con característica 2, siendo k un entero. Existen los

denominados campos compuestos que tienen la forma GF((pn)m).

El polinomio primitivo de segundo grado es x2+x+1 dentro de GF(22).

Existen dos valores que si se sustituyen en el polinomio lo igualan a cero, son

llamados raíces, tomando una raíz y denominándola α se puede escribir

α2+α+1=0, se despeja α2 obteniendo α2=-(α+1) pero en aritmética de los

campos, suma y resta son equivalentes, haciendo que α2=α+1. Si se construye

una tabla en donde se evalúen las potencias de α junto a su “representación” en

binario y decimal, obtenemos:

Binario

Potenci

a de α

Valor

α0

1

α1

α

α2

α+1

Comentario

Toda expresión elevada a la

potencia cero, vale uno.

Este valor se obtuvo en el

despeje α2=α+1.

α1

α0

Decimal

0

1

1

1

0

2

1

1

3

0

1

1

α3= α(α2)= α(α+1)= α2+α=

α+1+α=1 Hay que recordar que

α3

1

la suma y la resta son

equivalentes, así α+ α=0. A

partir de esta potencia los

valores se repiten, esto

31

garantiza que las operaciones

que se hagan con los

polinomios nunca tendrán

resultados diferentes a 1, α ó

α+1.

α4

α

α4= α(α3)= α(1)= α

1

0

2

Ejercicio 1. Comprueba que α3 = α6, α4 = α7 y α5 = α8.

La cardinalidad de GF(22) es cuatro, al elaborar la tabla (que depende de

potencias) no aparece el valor cero pero se agrega. La utilidad de la

representación binaria es que se pueden hacer operaciones entre los

polinomios a través de los ceros y unos.

Ejemplo 4. Calcula el producto x(x+1) en GF(22).

Paso 1. Convertir cada polinomio a su valor en binario y efectuar la

multiplicación.

X

1

1

1

0

0

0

1

1

1

1

0

Si se transforma 110 en su equivalente tendríamos x2+x, expresión que

no forma parte del campo.

Paso 2. Una vez que se ha calculado el producto, se le “suma” a la

representación binaria del polinomio primitivo, en este caso x2+x+1 que

tampoco se encuentra en el campo pero se usa para simplificación mediante la

operación denominada XOR entre los bits, simbolizada por según la tabla:

0

1

0

0

1

32

1

1

0

1

1

0

1

1

1

0

0

1

Esta operación transforma x2+x en 1, lo que coincide con lo obtenido en

la tabla de potencias.

Ejemplo 5. Calcula el producto (x4+x+1)(x3+x2+x) en GF(25) usando el

polinomio primitivo x5+x2+1.

1 0 0 1 1

x

1 1 1 0

0 0 0 0 0

1 0 0 1 1

1 0 0 1 1

1 0 0 1 1

1 0 0 0 0 1 0 1 0

1 0 0 0 0 1 0 1 0

1 0 0 1 0 1

0 0 0 1 0 0 0 1 0

1 0 0 1 0 1

1 1 1

El producto se convierte en x2+x+1, hay que hacer notar que la operación

XOR se inició desde la izquierda, esto permite la reducción sucesiva del grado

del polinomio.

En 1959 Irving Reed y Gus Solomon publicaron un trabajo titulado

Polinomial Codes over Certain Finite Fields, introduciendo un nuevo tipo de

códigos que corrigen errores. Su técnica se utiliza en los discos compactos para

enmendar los daños producidos en la información a causa de ralladuras, polvo,

33

huellas digitales, etc. encontradas en la superficie plástica del CD. También

tiene aplicaciones en las telecomunicaciones, tal fue el caso del envío de

imágenes del planeta Júpiter por la sonda espacial Voyager 2 en 1979.

©NASA/JPL

El código Reed-Solomon toma k elementos de GF(p) usándolos como

coeficientes de un polinomio sobre x de grado k-1 de la forma:

P(x)=u0+u1x+u2x2+…+uk-1xk-1

Si denominamos α a un elemento primitivo del campo que se evalúa con

cada una de sus potencias, se tiene:

P(0)=u0

P(α)=u0+u1α+…+uk-1 α k-1

P(α2)=u0+u1α2+…+uk-1 α2( k-1)

…

P(αp-1)=u0+u1αp-1+…+uk-1 α(p-1)( k-1)

Ejemplo 6. Codificación Reed-Solomon en GF(22).

Paso 1. Se construye el polinomio de primer grado, si A y B son

elementos del campo la forma general queda como:

P(x)=A+Bx

Haciendo A=1 y B=α2 se reescribe para obtener:

34

P(x)=1+ α2x

Paso 2. Se evalúan las potencias de α en el polinomio anterior.

P(0)=1+α2(1)=1

P(α)=1+α2(α)=1+α3=1+1=0

P(α2)= 1+α2(α2)=1+α4=1+α

P(α3)= 1+α2(α3)=1+α5=1+α+1=α

De esta forma se han codificado los elementos de GF(22) obteniendo:

Valor Código

0

1

1

0

Α

1+α

α+1

α

Si se elabora la misma tabla con sus equivalencias en decimal, se

forman coordenadas que se pueden graficar en un plano.

Valor Código

X

Y

0

1

1

0

2

3

3

2

3.5

3

2.5

2

1.5

1

0.5

0

0

0.5

1

1.5

2

2.5

3

3.5

35

Ejercicio 2. Realiza el proceso anterior con A=α y B=α+1.

2.1.3 Lineales

Un código se denomina lineal si al sumar dos elementos del mismo, el resultado

forma también parte de él. Reed-Solomon pertenece a esta clasificación, así

como el código Hamming.

2.1.3.1 Hamming

El matemático norteamericano Richard Hamming colaboró en el Proyecto

Manhattan que desarrolló la bomba atómica. Después de la guerra trabajó en

los Laboratorios Bell junto a Shannon, debido a la tecnología utilizada para

introducir datos a las computadoras Hamming encontró resultados inesperados

en los cálculos que realizaba. Se propuso encontrar una forma para detectar y

corregir errores de forma automática, cuyos resultados publicó en 1950. El

primer código que presentó se conoce como Hamming(7,4), consiste en

segmentos de siete bits (d1,d2,d3,d4,p1,p2,p3), cuatro de los cuales se usan para

datos y tres sirven para verificación, éstos se denominan paridad, calculándose

de la siguiente forma:

p1=d2d3d4

p2=d1d3d4

p3=d1d2d4

Los bits se disponen en un arreglo rectangular de siete columnas y

cuatro filas llamado matriz de 4x7 al que se representa habitualmente con letras

mayúsculas.

p1 p2 p3 d 1 d2 d3 d4

d1

0

1

1

1

0

0

0

d2

1

0

1

0

1

0

0

d3

1

1

0

0

0

1

0

d4

1

1

1

0

0

0

1

=A

36

La matriz puede variar dependiendo de las fórmulas que se usen para los

bits de paridad.

Para realizar la codificación se requiere la multiplicación de A por otra

matriz de un solo renglón y cuatro columnas, ésta recibe el nombre de vector de

tamaño 1x4, representa el dato de cuatro bits que se envía de un total de 16

opciones que son las combinaciones obtenidas, es decir 2 4=16. Ese conjunto

constituye un alfabeto permitiendo la creación de mensajes.

Para poder realizar el producto de matrices se verifica que el tamaño de

columnas de una sea el mismo que el de filas de la otra.

Ejemplo

7.

Codificar

el

dato

representado

por

1001

usando

Hamming(7,4).

[1011]

0

1

1

1

0

0

0

1

0

1

0

1

0

0

1

1

0

0

0

1

0

1

1

1

0

0

0

1

Se procede a multiplicar cada columna del vector con cada fila de la

primera columna de la matriz A, “sumando” los productos y repitiendo el

proceso con todas las columnas.

1x00x11x11x1=0

1x10x01x11x1=1

1x10x11x01x1=1

1x10x01x01x0=1

1x00x11x01x0=0

1x00x01x11x0=1

1x00x01x01x1=1

El resultado se dispone en forma de vector con tamaño 1x7.

[0111011]

37

Ejercicio 3. Asigna un valor decimal entre 0 y 15 a los siguientes

símbolos: @, !, & y #; después convierte cada número a binario y codifícalo bajo

Hamming(7,4).

ACTIVIDAD DE APRENDIZAJE

Investiga cuáles son las características del código BCD.

2.2 COMPRESIÓN

Es la codificación de información de forma más eficiente para mejorar el

rendimiento de los dispositivos de comunicación. Un método de compresión

estático mantiene fija la tabla de conversión antes de la transmisión, mientras

que uno dinámico cambia los códigos de equivalencia mientras se envían los

datos, a este último también se le conoce como adaptativo.

Una de las formas de medir el grado de compresión es a través de la

razón:

Tamaño

Tasa

compresión=

de

los

datos

de

los

datos

de resultantes

Tamaño

originales

La tasa se puede representar por bpb (bit per bit) que determina el

número de bits comprimidos necesarios para representar un bit de entrada. En

caso de texto se usa bpc (bits per character) mientras que si son imágenes es

bpp (bits per pixel). El factor de compresión es el inverso de la tasa de

compresión.

Para medir el rendimiento de alguna herramienta de compresión se

pueden usar conjuntos de distintos tipos de archivos que incluyen texto,

imágenes y otros datos. Algunos de estos grupos tienen nombres como Calgary

Corpus o Canterbury Corpus.

38

2.2.1 Lossless

En este tipo de compresión el mensaje que se envía y el que llega deben ser

idénticos, como en el caso de documentos y archivos personales, tanto de

forma interna para almacenamiento como externamente a través de una red.

El formato ZIP es un ejemplo de esta clasificación, fue dado a conocer en

1989 por Phil Katz fundador de PKWARE, no lo desarrolló de forma original,

mejoró uno que ya existía bajo la autoría y registro de Thom Henderson quien

demandó a Katz.

2.2.2 Lossy

Bajo este esquema, la información codificada no es idéntica a la original, se

utiliza principalmente en la transmisión de imágenes, video o audio. El tipo de

archivo JPEG elaborado por JOINT PHOTOGRAPHIC EXPERTS GROUP, se basa en

un análisis por zonas de los colores que forman una imagen, promediando los

que son similares lo cual produce menor definición así como menor espacio de

almacenamiento, lo que resulta muy importante cuando se usan recursos

limitados, tal es el caso de Internet.

2.2.3 Código Shannon-Fano

Desarrollado independientemente por Shannon y Robert Fano del Instituto

Tecnológico de Masschusetts (MIT, por sus siglas en inglés). Este código tiene

su base en la frecuencia estadística del uso de los caracteres de cierto alfabeto.

Si tenemos la siguiente tabla de frecuencias:

A

39

B

21

C

16

D

8

E

31

La secuencia que se debe seguir para la codificación es:

Paso 1. Reacomodar la tabla según la frecuencia, de menor a mayor.

39

D

8

C

16

B

21

E

31

A

39

Paso 2. Se divide la lista en dos partes, tomando en cuenta que ambas

deben tener una suma de frecuencias parecida.

D

8

C

16

B

21

E

31

A

39

Paso 3. A una mitad se le asocia el número uno y a la otra cero.

D

8

0

C

16

0

B

21

0

E

31

1

A

39

1

Paso 4. Se repiten los pasos 2 y 3 sucesivamente con cada una de las

mitades hasta terminar los caracteres.

Código

D

8

0

0

0

C

16

0

0

1

B

21

0

1

E

31

1

0

A

39

1

1

40

Los códigos generados por este proceso asignan menores cantidades de

bits a los caracteres que más se usan. A la secuencia de pasos que produce un

resultado se le conoce como algoritmo.

Se puede construir una estructura de árbol siguiendo las divisiones por

mitades.

1

0

0

0

D

1

1

0

B

E

1

A

C

A este esquema se le conoce como árbol de codificación. Cada extremo

de una línea recibe el nombre de nodo, si del extremo inferior parten nuevas

líneas se convierte en nodo padre de lo contrario se denomina hoja. Un nodo

que no tiene padre se llama raíz.

2.2.4 Código Huffman

Se presentó en 1952 por David Huffman, es muy parecido al código ShannonFano, usando los mismos símbolos del caso anterior su algoritmo es:

Paso 1. Reacomodar la tabla según la frecuencia, de menor a mayor.

D

8

C

16

B

21

E

31

A

39

Paso 2. Se suman los dos primeros elementos de la tabla (que son los

menores) asignándole un símbolo al resultado, reordenándose la tabla. El

nuevo elemento forma un nodo padre.

B

21

N0(D,C)

24

E

31

41

A

39

Paso 3. Se repite el paso 2 hasta tener un solo nodo.

E

31

A

39

N1(B,N0)

45

N1(B,N0)

45

N2(E,A)

70

N3(N1,N2) 115

Construyendo el árbol se obtiene:

0 N3 1

0 N11

B 0 N0 1

D

C

0 N21

E

A

Paso 4. A los nodos hijos de lado izquierdo se les asigna cero y a los de

lado derecho uno.

Código

D

0

1

0

C

0

1

1

B

0

0

E

1

0

A

1

1

ACTIVIDAD DE APRENDIZAJE

42

Investiga qué son las distancia de Hamming y de Levenshtein.

2.3 CRIPTOGRAFÍA

Es el tratamiento que se le aplica a la información para protegerla. El mensaje

original se conoce como texto plano que al procesarse genera un cifrado.

Un

sistema

criptográfico

consta

de

dos

fases:

encriptación

y

desencriptación. Una llave es una función que permite intercambiar información

entre dos entidades que la conozcan. Se denomina sistema de encriptación

clásico o simétrico si posee una sola llave, llamada privada. Por ejemplo el

método de cifrado Cesar es simétrico.

Si un caracter encriptado corresponde a uno en texto plano, recibe el

nombre de encriptación monoalfabética, pero si representa a más de uno se

denomina polialfabético.

La característica de un sistema criptográfico asimétrico es que utiliza dos

llaves: una pública para cifrar y una privada para descifrar. Este método fue

inventado por Diffie y Hellman en 1976. En 1978 se dio a conocer el algoritmo

RSA desarrollado por Rivest, Shamir y Adleman. Se basa en la dificultad para

factorizar número primos “grandes” que tengan cientos de dígitos. Los pasos a

seguir son:

Paso 1. Elegir dos números primos “grandes” p y q para calcular n=pq.

Paso 2. Obtener m=(p-1)(q-1).

Paso 3. Elegir E de tal forma que el único número que divida a E y a m

sea uno, escrito como mcd(E,m)=1. Bajo esta condición se dice que E y m son

primos relativos.

Paso 4. Encontrar D tal que DE1 mod m. E y N son la llave pública

mientras que D es la privada.

Paso 5. Para cifrar un símbolo M < n se calcula:

C=ME mod n

Para descrifrar se utiliza la fórmula:

M=CD mod n.

43

Ejercicio 4. Codifica los números: 11,13 y 23; bajo RSA si p=23, q=29,

E=487 y D=191.

ACTIVIDAD DE APRENDIZAJE

Investiga cuáles son las características de una firma digital.

2.4 ERRORES

2.4.1 Naturaleza de los errores

A partir de la estructura de un sistema de comunicación se pueden encontrar

múltiples fuentes de error como las siguientes:

Ingreso de datos. En las primeras computadoras los datos se

introducían mediante tarjetas perforadas, aún con los avances

actuales no se ha podido eliminar del todo la dependencia del

trabajo humano en la captura de información.

Codificación. Al automatizar la conversión de datos se pueden

presentar fallas en los algoritmos, programación de los mismos o

uso incorrecto.

Transmisión. Ya sea al momento de preparar el envío o durante su

viaje por distintos medios, puede haber pérdida de calidad de la

señal o contaminación que modifique los valores requiriendo de

reenvíos.

Decodificación. La información puede llegar tan dañada que no se

puedan aplicar los métodos de corrección de errores.

Despliegue de información. Puede ocurrir que las configuraciones

de los equipos sean distintas, por ejemplo, en el idioma, que no

permitan que los datos se vean de forma adecuada.

44

2.4.2 Agoritmos de detección

2.4.2.1 Paridad

Es la verificación mediante bits adicionados a la codificación de un símbolo que

indica si el número de unos es par, recibiendo el nombre de paridad par

poniendo el número cero o en caso contrario se denomina impar. Por ejemplo,

el código Reed-Solomon RS(255,223) transporta mensajes de 255 bytes de los

cuales 223 son datos y 32 sirven de paridad, pudiendo corregir 16 errores. Éste

es ampliamente usado en telecomunicaciones y dispositivos reproductores de

audio.

2.4.2.2 Checksum

De amplio uso en internet con distintas variaciones una de las cuales consiste

en los siguientes pasos:

Paso 1. Se divide el mensaje en bloques de 16 bits y se suman en

grupos del mismo tamaño, la suma puede tener más de 16 bits.

Paso 2. A la suma se le aplica la operación denominada complemento a

uno: los unos se convierten en ceros y viceversa.

Paso 3. Se envía el grupo de datos junto con el checksum, el destinatario

hace la suma de todo el bloque y debe obtener 16 unos. Si su resultado es

distinto entonces se produjo un error.

2.4.2.3 Redundancia cíclica

Los códigos de redundancia cíclica (CRC) tienen su uso en las redes de alta

velocidad y se fundamentan en los campos de Galois extendidos. Los más

usados son CRC-16 y CRC-32 que usan los polinomios primitivos x16 + x15 + x2

+1 y x32 + x26 + x23 + x22 + x16 + x12 + x11 + x10 + x8 + x7 + x5 + x4 + x2 + x + 1

respectivamente.

ACTIVIDAD DE APRENDIZAJE

45

Investiga para qué sirve una matriz de paridad.

46

AUTOEVALUACIÓN

Elige el inciso correcto.

A. Es el tamaño en bits del código Baudot.

a) 3

b) 4

c) 5

d) 6

c) Gray

d) Baudot

c) ASCII

d) Gray

c) Baudot

d) Gauss

c) Doc

d) JPG

B. Tiene siete bits.

a) ASCII

b) EBCDIC

C. Un nibble es la mitad de un.

a) Bit

b) Byte

D. Se basa en la frecuencia estadística.

a) Shannon-Fano

b) Reed-Solomon

E. Es un tipo de formato Lossy.

a) PDF

b) Txt

Completa las frases.

F. Un algoritmo es ________________________

___

G. En los códigos lineales si sumo dos de sus elementos

.

____

____________________________________.

H. Un código se define como _______________________________________

___________________________________ .

I. Una matriz es

_________________________ .

J. El factor de compresión se calcula mediante

.

RESPUESTAS DE LA AUTOEVALUACIÓN

A. c.

B. a.

C. b.

D. a.

E. d.

47

F. Una secuencia de pasos.

G. Obtengo otro elemento del código.

H. Una correspondencia entre elementos de un conjunto con otro.

I. Un arreglo rectangular de números.

J. El inverso de la tasa de compresión.

48

UNIDAD 3

TRANSMISIÓN

OBJETIVO

El alumno conocerá los elementos que permiten el viaje de la información de un

punto a otro.

TEMARIO

3.1. ESPECTRO ELECTROMAGNÉTICO

3.2. MEDIOS

3.2.1. CABLEADOS

3.2.1.1.

COAXIAL

3.2.1.2.

PAR TRENZADO

3.2.1.3.

FIBRA ÓPTICA

3.2.2. INALÁMBRICOS

3.2.2.1.

WIFI

3.2.2.2.

BLUETOOTH

3.3. MODOS

3.3.1. SIMPLEX

3.3.2. DUPLEX

3.4. TÉCNICAS

3.4.1. MODULACIÓN

3.4.1.1.

DIGITAL

3.4.1.2.

ANALÓGICA

3.4.2. MULTIPLEXACIÓN

3.4.3. CONMUTACIÓN

3.5. SEÑALES

3.5.1. CLASIFICACIÓN

3.5.2. MUESTREO

49

MAPA CONCEPTUAL

Las

Ondas

Voltaje

pueden ser

Electromagnéticas

transportando

Radio

Luz

Información

Cables

a través de

Medios

usando

Técnicas

Antenas

Señales

50

INTRODUCCIÓN

Desde la antigüedad se han buscado técnicas de comunicación que abarquen

mayor distancia para mantener en contacto a las personas, utilizando las

propiedades físicas de los materiales disponibles, cada nueva tecnología

presenta retos, pero esto ha hecho posible el envío de información de manera

masiva, más segura y a menor costo.

51

3.1 ESPECTRO ELECTROMAGNÉTICO

Una onda produce perturbaciones periódicas en el medio a través del cual se

propaga, como las olas en el mar, al punto más alto se le llama cresta y al más

bajo se le denomina valle. La información puede ser convertida en energía, que

es en parte eléctrica y en parte magnética, con distintas formas de propagación:

como voltaje a lo largo de un cable, mediante ondas radiales que viajan en el

aire, o luz viajando en una fibra óptica. Todos estos fenómenos se basan en la

vibración de electrones en el interior de los átomos.

Una onda electromagnética está compuesta de campos eléctricos y

magnéticos que se regeneran mutuamente según los principios de Maxwell y

Faraday. Esos campos y la dirección de propagación de la onda son

perpendiculares entre sí.

©www.terra.es

Los parámetros que caracterizan a las ondas electromagnéticas son:

Longitud de onda (λ). Es la distancia en metros entre una cresta y

la cresta siguiente (o de valle a valle), lo que abarca un ciclo.

Velocidad de propagación (c). Se propagan con la misma rapidez

que la luz (3x108 m/s).

Frecuencia (F). Es un indicador medido en hercios (Hz) que

relaciona las dos magnitudes anteriores:

52

El rango completo de frecuencias que pueden tener las ondas

electromagnéticas se conoce como espectro. Abarca desde las subsónicas

hasta los rayos cósmicos y se divide en bandas que son reguladas en cada país

por organismos gubernamentales, en el caso de México son la Cofetel y la SCT.

© www.um.es

En el caso de las radiofrecuencias existen las siguientes clasificaciones:

Tipo

Características

Uso

ELF

Extremadamente bajas (30-300 Hz)

Red eléctrica

VF

Voz (300-3000Hz)

Telefonía

VLF

Muy baja (3-30 kHz)

LF

Bajas (30-300 kHz)

MF

Intermedias (300 kHz – 3MHz)

Radio AM

HF

Altas (3 – 30 MHz)

Banda civil

Muy altas (30 – 300 MHz)

TV, radio FM

VHF

Comunicación entre

submarinos

Sistemas de navegación

marítima y aérea.

53

UHF

Ultra alta (300 MHz – 3GHz)

TV, celulares

SHF

Super altas (3 – 30 GHz)

Microondas, satélites

La banda de 27MHz con seis canales es de uso libre para aplicaciones como el

radiocontrol.

ACTIVIDAD DE APRENDIZAJE

Investiga las propiedades de las microondas.

3.2 MEDIOS

Un medio de transmisión es cualquier conductor o semiconductor, o su

combinación, para llevar información de un punto a otro. Existen las siguientes

configuraciones:

Un conductor tubular.

Dos conductores alambricos como el par trenzado o cable coaxial.

Dieléctrico.

3.2.1 Cableados

En los medios guiados, la velocidad y capacidad de la transmisión dependen de

la distancia. A la resistencia que presenta un cable al paso de ondas

electromagnéticas en función de su frecuencia se le denomina impedancia, se

mide en ohmios (Ω). Si se tratara de un cable de extensión infinita recibe el

nombre de impedancia característica.

3.2.1.1 Coaxial

Es un sistema de conductores y aislantes dobles, dispuestos de forma interna y

externa. El conductor interno es un alambre de cobre mientras que el externo

está construido en forma de malla de cobre o aluminio, ésta recibe el nombre de

pantalla, sirviendo como protección contra el ruido. Entre ambos conductores

54

existe un aislante de polietileno (dieléctrico) y externamente todo el sistema se

cubre con una cubierta de PVC. Existen diversas medidas de diámetros del

cable interno con diferentes impedancias, siendo las más comunes 50Ω y 75Ω.

©www.dis.um.es

Existen dos tipos de cable coaxial:

Banda base. Usado en redes de computadora para datos digitales,

requiere un repetidor cada kilómetro para corregir la atenuación de

la señal.

Banda

ancha.

Transporta

señales

analógicas

en

varias

frecuencias

3.2.1.2 Par trenzado

Agrupa cables de cobre forrados de un grosor que varía entre 0.4 mm y 0.9 mm

entrelazados espiralmente en pares, cuenta con una cubierta externa de

protección fabricada de PVC. Su estructura entrelazada reduce la interferencia

electromagnética (diafonía) entre las parejas adyacentes mediante diferentes

longitudes de torsión, variando de 5 cm a 10 cm. Tanto para señales digitales

como analógicas, el par trenzado también conocido como cable telefónico es

usado ampliamente debido a su bajo costo y facilidad de manejo. Al transmitir

analógicamente requiere amplificadores cada 5 km o 6 km mientras que en el

caso digital necesita repetidores cada 2 km o 3 km. Es un tipo de medio

susceptible a interferencias y ruido, tiene alcance, velocidad y ancho de banda

menores que el coaxial o la fibra óptica. Hay dos clases: par trenzado

apantallado (STP) y sin apantallar (UTP), con la finalidad de mejorar su

protección.

55

© www.kmfair.org

Los estándares T568A t T568B dicen cómo se deben disponer los cables

para colocarles los conectores RJ45.

© www.servian.es

La categoría del cable establece el ancho de banda que soporta. El de

categoría 5 soporta 100 Mbps (mega bits por segundo) con impedancia de 100

Ω.

3.2.1.3 Fibra óptica

Está construida con fibras de vidrio o plástico, es delgada y flexible. El cable

tiene forma cilíndrica, se compone de tres capas: núcleo, revestimiento y

cubierta.

56

©www.gatewayforindia.com

Su ancho de banda es del orden de cientos de giga bits (Gbps) a través

de decenas de kilómetros. Puede transportar entre 20,000 y 60,000 canales de

voz a una distancia de 1,500 km.

La fibra óptica utiliza el principio de reflexión total para frecuencias que

van desde 1014 hasta 1015 Hz, cubriendo parte del espectro visible e infrarrojo.

© www.techoptics.com

Si un rayo de luz atraviesa dos medios con índices de refracción

distintos, en dirección al que es menor, se refracta en la superficie al pasar por

el segundo medio. Si se varía el ángulo de entrada, llega un punto en que se

anula este fenómeno (ángulo crítico) y se refleja completamente dentro del

primer medio, por lo que se denomina reflexión total interna. Las pérdidas de luz

en una fibra óptica pueden ser causadas por:

Curvatura. Se debe al cambio de ángulo.

57

Conexión y empalme. Existen dos tipos de empalmes: mecánico y

por fusión, cuando se hacen estos puede existir desalineación de

los núcleos.

Fabricación. Se presentan por impurezas del núcleo propias del

material o falta de calidad en los procesos de elaboración de las

fibras.

©www.bug-si.com

3.2.2 Inalámbricos

A la propagación de ondas electromagnéticas en espacios abiertos se le

denomina propagación de radiofrecuencia que requiere una fuente que las

irradie para que un receptor las capture. La irradiación y la recepción son las

funciones de las antenas. En el espacio libre (vacío) no hay pérdida de energía

al desplazarse la onda, pero presenta un fenómeno de dispersión, reduciendo la

densidad de la potencia, a este proceso se le conoce como atenuación. La

superficie terrestre no es el vacío, ya que contiene diversas partículas

suspendidas en la atmosfera que absorben energía generando pérdida por

absorción. Una onda terrestre es una onda electromagnética que se desplaza a

través de la superficie de la Tierra.

3.2.2.1 WiFi

Es un sistema de comunicación inalámbrico que necesita la conversión de

datos binarios en ondas de radio que se envían y reciben a través de una

58

antena. Ha usado frecuencias de 2.4, 3.7 y 5 GHz basándose en el protocolo

IEEE 802.11 siendo el de clase g con una ancho de banda de 54 Mbps el más

usado actualmente. Esta versión ocupa el método de modulación OFDM

(orthogonal frecuency-division multiplexing) usando diversos mecanismos para

la protección de los datos tales como WEP, WPA y WPA2. El método de

privacidad equivalente a cableado (WEP, por sus siglas en inglés) es de cifrado

nivel dos basado en el algoritmo de llave simétrica RC4 de 64 bits o 128 bits,

debido a las vulnerabilidades encontradas a esta técnica en 2001, se presentó

en 2003 WPA (WiFi protected access).

Se encuentra en desarrollo la clase n que tiene una capacidad máxima

de 600 Mbps usando las bandas de 2.4 MHz y 5 MHz para ser compatible con

versiones anteriores así como el envío de información de paralelo.

©www.proelectronica.com

3.2.2.2 Bluetooth

Es una tecnología inalámbrica para comunicación de corto alcance, bajo

consumo y económica. También utiliza la frecuencia de 2.4 GHz, ya que es una

banda libre, tiene un alcance de 10 metros si es de la clase uno, llegando hasta

100 metros si es tres. La seguridad es administrada con base en los permisos

de acceso por dispositivos en lugar de hacerlo por usuarios, a través de un

identificador de 48 bits. Utiliza el protocolo IEEE 802.15.1 ideado para redes

59

personales sin interferir con las de WiFi. Posee ancho de banda de 1 Mbps, 3

Mbps o 24 Mbps dependiendo de la versión, usa modulación GFSK.

ACTIVIDAD DE APRENDIZAJE

Investiga cuáles son las debilidades del método WEP.

3.3 MODOS

La topología lógica define las rutas que debe seguir la información.

3.3.1 Simplex

En este tipo de esquema, la comunicación se produce en una sola dirección.

Una estación puede ser transmisor o receptor, pero no ambos. Las radios y

televisiones son ejemplos de esta categoría.

3.3.2 Duplex

Bajo esta clasificación cada estación puede ser un transmisor y un receptor al

mismo tiempo, tal como ocurre en los sistemas telefónicos.

ACTIVIDAD DE APRENDIZAJE

Investiga las características del modo semiduplex.

3.4 TÉCNICAS

3.4.1 Modulación

Las transmisiones analógicas tienen como base una señal continua con

frecuencia constante que se conoce como portadora. Los datos que se envían

se codifican modulando esa señal.

60

Existen tres parámetros que se pueden modificar para lograrlo: amplitud,

frecuencia y fase. La señal de entrada que puede ser digital o analógica, se

llama moduladora o señal en banda base, mientras que la señal de salida

recibe el nombre de modulada.

3.4.1.1 Digital

La señal modulada es digital, aunque la portadora sea analógica, existen

diversas técnicas tales como FSK, PSK y QAM.

FSK. Realizada a través de cambios en la frecuencia, manteniendo

constante la amplitud.

PSK. Se produce desplazando la fase.

QAM. La información está contenida en la amplitud y en la fase.

3.4.1.2 Analógica

La señal portadora se expresa en términos senoidales:

( )

(

)

Si el parámetro que se modifica es la amplitud se indica como AM,

tratándose de la frecuencia es FM. Con ambas se aumenta la capacidad de los

medios de transmisión.

3.4.2 Multiplexación

Con esta técnica se consiguen múltiples transmisiones usando un solo enlace,

aplicando los siguientes métodos:

División de frecuencia. El ancho de banda total se divide en canales

paralelos de 4 kHz cada uno.

Impulsos codificados. Está compuesto por los procesos: muestreo de la

señal, cuantificación, compresión y codificación.

División en tiempo. Asigna todo el ancho de banda disponible a cada

canal durante cierto tiempo.

61

3.4.3 Conmutación

Inicialmente utilizada en la comunicación de voz, actualmente es de aplicación

extensiva en Internet, en donde los datos se envían por paquetes conocidos

como datagramas que pueden seguir distintas rutas para llegar a su destino,

donde al final se recompone el mensaje. Existe una técnica conocida como

circuitos virtuales que determina una ruta fija por donde viajarán los paquetes.

ACTIVIDAD DE APRENDIZAJE

Investiga cuál es la estructura de un datagrama.

3.5 SEÑALES

Una señal es una función que depende del tiempo y genera información.

3.5.1 Clasificación

Existen diferentes técnicas de representación para las señales:

Periódicas. Tiene un comportamiento repetitivo.

Determinísticas o aleatorias. En las primeras su comportamiento se

puede predecir mientras que las segundas presentan comportamiento

irregular.

Analógica o digitales. Generan valores continuos o discretos.

Energéticas o potenciales. Representa voltaje o corriente.

3.5.2 Muestreo

Es parte del proceso de transformación de una señal analógica a digital. Al

proceso que selecciona un número de valores discretos a partir de una señal

continua, se le conoce como muestreo. La tasa o frecuencia de muestreo, es la

cantidad de mediciones que se hacen por unidad de tiempo. La magnitud más

usada es el hercio (Hz) que representa un ciclo por segundo.

El ingeniero sueco Niquist conjeturó en 1928 que la frecuencia de

muestreo debe ser superior al doble de la máxima frecuencia a muestrear.

62

Ejemplo. Para digitalizar una canción en CD se utiliza una tasa de 44100

muestras por segundo (44.1 MHz), ya que la máxima frecuencia perceptible

para el oído humano está cercana a 20KHz.

ACTIVIDAD DE APRENDIZAJE

Investiga cómo se utiliza el análisis de Fourier en el estudio de las señales.

63

AUTOEVALUACIÓN

Elige el inciso correcto.

A. Es la distancia de valle a valle.

a) λ

b) Ω

c) c

d) F

c) 44 MHz

d) 27 GHz

c) c

d) F

B. Es una banda de uso libre.

a) 44 GHz

b) 27 MHz

C. Mide los ciclos por segundo.

a) λ

b) Ω

D. Es la clase WiFi que permite transmisión en paralelo.

a) a

b) b

c) c

d) n

E. El teorema del muestreo fue enunciado por:

a) Niquist

b) Fourier

c) Faraday

d) Maxwell

Completa las frases.

F. Una onda produce ______________________

___

.

G. Cuando se alcanza el ángulo crítico

____

____________________________________.

H. El espectro electromagnético es ___________________________________

___________________________________ .

I. Un dieléctrico es ______________________ .

J. La resistencia que presenta un cable al paso de ondas electromagnéticas en

función de su frecuencia se le denomina

.

RESPUESTAS DE LA AUTOEVALUACIÓN

A. a.

B. b.

C. d.

D. d.

E. a.

64

F. Perturbaciones periódicas en el medio a través del cual se propaga.

G. Se produce la reflexión total interna.

H. El rango completo de frecuencias que pueden tener las ondas

electromagnéticas.

I. Un aislante.

J. Impedancia.

65

UNIDAD 4

TEORÍAS DE LA INFORMACIÓN

OBJETIVO

El alumno analizará los diferentes métodos para representar y manipular la

información.

TEMARIO

4.1. CLÁSICA

4.1.1. ENTROPÍA

4.1.2. INFORMACIÓN MUTUA

4.1.3. CAPACIDAD DEL CANAL

4.1.4. TEOREMAS DE SHANNON

4.1.4.1.

CODIFICACIÓN DE LA FUENTE

4.1.4.2.

CODIFICACIÓN DEL CANAL

4.1.4.3.

CAPACIDAD DE INFORMACIÓN

4.1.5. TEORÍA DE LA DISTORSIÓN DE LA VELOCIDAD

4.2. CUÁNTICA

4.2.1. INTRODUCCIÓN A LA MECÁNICA CUÁNTICA

4.2.2. COMPUTADORAS

4.2.2.1.

QUBITS

4.2.2.2.

CIRCUITOS CUÁNTICOS

4.2.3. INFORMACIÓN

4.2.3.1.

ENTROPÍA DE VON NEUMANN

4.2.3.2.

TERMODINÁMICA COMPUTACIONAL

4.2.3.3.

RUIDO

4.2.3.4.

CRIPTOGRAFÍA

66

MAPA CONCEPTUAL

La

Información

tiene fundamentos

Matemáticos

Físicos

dados por

Shannon

mediante

Landauer

acerca de

Canales

Teoremas

Codificación

67

INTRODUCCIÓN

Cada

día

se

requiere

de

mayores

capacidades

de

transmisión

y

almacenamiento de información, al tener un entorno de alta conectividad se

hace obligatorio el uso de técnicas de protección de los datos. La carrera

tecnológica por crear dispositivos más pequeños y rápidos ha llegado a los

límites de la materia, ante este panorama se realizan esfuerzos por encontrar

nuevas soluciones que en otros tiempos se consideraban ciencia ficción.

68

4.1 CLÁSICA

Cualquier área del conocimiento humano es tan sólida como las bases

matemáticas sobre las que se construye. Diferentes enfoques dieron origen al

estudio de la información, y quienes contribuyeron de forma más significativa a

construir su cimentación fueron Shannon, Wiener, Weaver y Landauer.

4.1.1 Entropía

La segunda ley de la termodinámica se puede expresar de diferentes formas

dependiendo de su aplicación:

El calor no fluye de forma espontanea de un cuerpo frío a uno más

caliente.

La energía no puede ser transformada por completo en trabajo

mecánico.

El cambio de entropía entre cualquier sistema y su medio ambiente es

positivo y tiende a cero si el proceso es reversible.

El término entropía fue acuñado por el físico alemán Rudolph Clausius y

puede ser interpretado de distintas maneras:

Capacidad de un sistema para hacer trabajo.

Dirección del flujo del tiempo.

Medida del desorden o aleatoriedad. Entre mayor sea su orden la

entropía es menor.

Matemáticamente, la entropía S se puede expresar como S = klnP, en

donde k es la constante de Boltzman y P representa qué tan equilibrado está el

sistema.

En 1867 el físico Maxwell ideó un experimento que consiste de dos cajas,

una con moléculas rápidas (más caliente) y otra con moléculas lentas teniendo

menor energía, en ambos casos se encuentran moviéndose en todas

69

direcciones, la cajas están conectadas por una compuerta controlada por

alguien. Se trata de agrupar a las moléculas rápidas de un lado y las lentas de

otro, tomando como referencia las velocidades medias iniciales de cada caja,

abriendo la compuerta cuando la molécula pasa por ahí en su viaje hacia su

respectiva zona. Al terminar el proceso, la caja que tenía menor temperatura se

volvió más fría y la otra más caliente, logrando esto sin necesidad de realizar

trabajo, únicamente utilizando la observación. Cuando el físico William

Thompson conoció este experimento dijo que era una especie de demonio, ya

que contradice la segunda ley de la termodinámica, por tal razón recibe el

nombre de “demonio de Maxwell”.

©www.historiasdelaciencia.com

En 1961 el físico alemán Rolf Landauer encontró que la energía mínima

necesaria para borrar un bit en una memoria es de kln2, este proceso genera

calor y es irreversible, por lo tanto aumenta la entropía en el sistema. Él siempre

consideró que la información es física, pues se encuentra en el ADN, neuronas,

transistores y otros dispositivos. En 1984 el físico norteamericano Charles

Bennett, quien al igual que Landauer trabajaba en IBM, aplicó el principio de

Landauer para resolver la paradoja del “demonio de Maxwell”, debido a que el

demonio requiere almacenar la información sobre la posición y velocidad de

cada partícula para poder dejarlas en su zona correspondiente e ir borrando las

70

que vaya acomodando, este proceso genera calor y compensa la parte que falta

para que el experimento sea consistente con la segunda ley de la

termodinámica.

En su libro Cybernetics Norbert Wiener plantea que la información se

caracteriza por su nivel de organización en contraposición con el grado de

desorden que representa la entropía, por lo tanto debe ser expresado por una

medida negativa de esta. Para Shannon, la cantidad de información ( ) que se

obtiene al conocer un símbolo s con probabilidad p > 0 es:

( )

( )

Por ejemplo: entre mayor sea el número de veces que se lance un dado

se verá que cada lado aparece con la misma frecuencia de tal forma que su

probabilidad es , de esta forma si sabemos que salió la cara con el número 5,

( )

la información que obtenemos es de

, se requiere el signo

negativo porque los logaritmos también lo tienen y hacer la multiplicación se

produce un resultado positivo.

En general, Shannon encontró que si X es una variable aleatoria (la cara

del dado) que tiene el valor x (uno a seis) con probabilidad p(x), la información

contenida (medida en bits) en X a partir de una fuente de información S (el

dado) es:

({ ( )})

∑ ( )

( )

Si como en el caso del dado perfecto, cada símbolo es equiprobable

( ) la entropía se define como:

( )

∑

( )

( )

Pero si cada símbolo tiene probabilidad distinta

{

} entonces

su entropía es:

( )

∑

( )

∑

( )

71

Tratándose de una variable binaria, si p es la probabilidad de que X=1, la

probabilidad de X=0 es 1-p (ya que la suma de las probabilidades debe ser

uno), en este caso la expresión de la entropía se convierte en:

( )

(

)

(

)

4.1.2 Información mutua

La medida que expresa la cantidad de información que comparten dos variables

aleatorias X e Y se conoce como información mutua (

entropía condicional

(

) expresada de la forma:

(

)

∑∑ (

)

[

(

) y depende de la

)

]

Usándola para la formulación de la información mutua queda así:

(

)

( )

(

)

Ésta posee las siguientes propiedades:

(

)

(

(

)

.

(

)

( )

La expresión

(

).

( )

(

)

) es conocida como entropía conjunta.

4.1.3 Capacidad del canal

Un canal discreto sin memoria se define a partir de tres conjuntos: un alfabeto X

que sirve para crear datos de entrada, un alfabeto de salida Y, y probabilidades

(

). Entonces la capacidad C de dicho canal es el máximo valor que tiene

la información mutua, expresada por:

{ (

)}

(

)

Dicha capacidad se mide en bits.

72

4.1.4 Teoremas de Shannon

Los siguientes resultados fueron dados a conocer por Claude Shannon en 1948

al publicar A Mathematical Theory of Communication.

©www.nlm.nih.gov

4.1.4.1 Codificación de la fuente

Para lograr una codificación binaria más eficiente de los símbolos sk de un

alfabeto A que son generados por una fuente discreta sin memoria, cada uno

con probabilidad pk y con longitud lk una vez codificado, se requiere que los

símbolos con mayor probabilidad tengan un tamaño codificado menor que los

de poca ocurrencia. La longitud media ̅

de los símbolos codificados está

representada por:

̅

∑

La medida de eficiencia del proceso de codificación se obtiene como:

̅

Si ̅

entonces

, conociéndose como eficiente cuando η se

acerca a uno. El primer teorema de Shannon se enfoca a la codificación de la

fuente enunciándose como sigue:

Dada una fuente discreta sin memoria, el esquema de codificación debe

satisfacer que ̅

( ).

73

4.1.4.2 Codificación del canal

Debido a los errores que se producen en la información al ser transmitida se

requieren de técnicas que minimicen los mismos a través de la codificación de

la información. Mediante este resultado Shannon proporciona el resultado

principal de la teoría clásica de la información, enunciado como sigue:

Si A es un alfabeto en una fuente discreta sin memoria que produce

símbolos cada Ts segundos que viajan a través de un canal discreto sin

memoria de capacidad C que se usa cada Tc segundos. Si

( )

entonces

existe un esquema de codificación que permite reducir de forma arbitraria la

probabilidad de error. La relación

se denomina tasa crítica.

4.1.4.3 Capacidad de información

Para un canal que posee un ancho de banda B medido en hertz, en presencia

de ruido blanco cuya densidad está dada por

y con potencia promedio de

transmisión P, su capacidad se calcula mediante:

(

)

4.1.5 Teoría de la distorsión de la velocidad

Según el teorema de la codificación de la fuente, el tamaño promedio de un

código debe ser cuando menos igual a la entropía de tal fuente. En las

situaciones en las que no se puede aplicar ese principio, asumiendo los riegos

que conlleva, se utiliza la teoría de la distorsión como en los casos:

Método lossy de compresión.

Transmisión de una capacidad mayor a la que soporta el canal.

74

©www.qwickstep.com

ACTIVIDAD DE APRENDIZAJE

Investiga la solución al “demonio de Maxwell” propuesta por Leó Szilárd.

4.2 CUÁNTICA

Debido a su enfoque como físico Landauer colaboró indirectamente en el

desarrollo de la computación cuántica, se le considera como pionero en el área;

sin embargo, fue un crítico de la misma, él sugirió que al final de cualquier

reporte de investigación sobre computación cuántica se advirtiera del carácter

especulativo de esta.

4.2.1 Introducción a la mecánica cuántica

En 1801 Thomas Young propuso un experimento para comprobar la naturaleza

ondulatoria de la luz mediante un dispositivo emisor que la proyectaba sobre

una pantalla con dos rejillas y el uso de otra pantalla para registrar el patrón

formado. Si la luz estuviera compuesta de partículas se comportaría así:

75

© www.studyphysics.ca

Pero si fueran ondas se registraría el siguiente patrón:

© www.studyphysics.ca

El comportamiento final obtenido fue:

© www.studyphysics.ca

76

En 2002 se realizó una encuesta entre los lectores de Physics World

para encontrar el experimento más bello de la física, ganando el arriba

presentado.

En el año 1900 el físico alemán Max Plank propuso que la luz además de

tener un comportamiento de onda estaba compuesta de pequeños paquetes

llamados cuantos, asignando una energía E a cada uno y relacionándolo con su

frecuencia f obtuvo la relación

, en donde h es ahora conocida como la

constante de Plank. A partir de este resultado Einstein explicó el efecto

fotoeléctrico, trabajo por el cual recibió el Premio Nobel de Física en 1921.

Científicos de HITACHI reprodujeron el experimento de Young en 1989

con una fuente de electrones y una pantalla de las usadas en televisiones para

registrar el comportamiento.

©www.nodo50.org

Cuando se trata de medir el comportamiento de cada electrón a través de

cada rejilla, el patrón cambia de forma y se comporta como si sólo fueran

partículas formándose dos líneas paralelas. Los fenómenos cuánticos no

presentan un estado definido hasta que se intenta hacer una medición, pues su

naturaleza es probabilística. El físico austriaco Erwin Schrödinger pensó en un

77

experimento en donde un gato se encontraba en una caja con un dispositivo

radiactivo que activaba un gas venenoso, si se observa lo que pasa dentro de la

caja se encontraría al gato vivo o muerto, pero si no se interfiere con los

procesos que se llevan a cabo en el interior, el gato podría estar en una

superposición de estados, es decir vivo y muerto al mismo tiempo, o medio vivo

y medio muerto.

©zenweezil.com

El físico alemán Werner Heisenberg propuso que a nivel cuántico una

partícula no tiene posición y velocidad definidas de forma simultánea, a lo que