COMUNICACIONES DE DATOS – Curso 2015 Práctico Nº 1

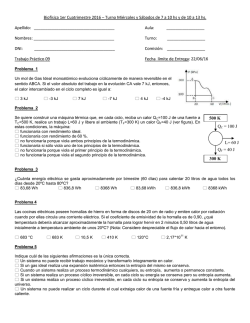

COMUNICACIONES DE DATOS – Curso 2015 Práctico Nº 1 Teoría de la Información y Codificación 1. Calcular la información asociada a la caída de una moneda (suceso estadísticamente independiente). 2. Calcular la probabilidad de que aparezcan 3 caras consecutivas en la tirada de una moneda y su información asociada. 3. Supongamos que una fuente produce los símbolos A, B, C y D con probabilidades 1/2, 1/4, 1/8 y 1/8. a. Calcular la información en cada caso. b. Si los símbolos son independientes, calcular los bits de información del mensaje: CADABA. 4. Una fuente produce 5 símbolos con probabilidades 1/2, 1/4, 1/8, 1/16 y 1/16. Calcular la entropía de la fuente. 5. Se transmiten trenes de cuatro pulsos cada uno, teniendo cada pulso una duración de 1mseg. Los pulsos pueden tomar en forma equiprobable los niveles de tensión 0, 1, 2 y 3 volts excepto el primer pulso del tren o block que siempre toma el nivel 1 volt. Calcular la Tasa da Información R. 6. Una fuente de datos tiene 8 símbolos equiprobables y emite en bloques de tres a una tasa de 1000 bloques por segundo. Si el primer símbolo de cada bloque es siempre el mismo (sincronización) y los restantes pueden ser cualquiera de los 8 símbolos de la fuente. Calcular la Tasa de Información R. 7. Calcular e informar la situación del siguiente alfabeto en el cual la probabilidad de ocurrencia de las diferentes letras se da en la siguiente tabla: A: 0.083 B: 0.016 C: 0.032 D: 0.030 E: 0.120 F: 0.026 G: 0.013 H: 0.052 U: 0.035 I: 0.072 J: 0.001 K: 0.005 L: 0.039 M: 0.072 N: 0.076 O: 0.079 P: 0.023 Q: 0.001 R: 0.060 S: 0.059 T: 0.053 Z: 0.002 V: 0.009 W: 0.020 X: 0.002 Y: 0.019 a. Informar ¿cuál letra proporciona la máxima cantidad de información? b. Informar ¿cuál letra proporciona la mínima cantidad de información? c. Suponiendo que las letras se eligen independientemente para formar palabras, calcular e informar la entropía (H) de este alfabeto. d. Informar la cantidad de información que contiene la palabra CERTAMEN. 8. Supongamos una fuente binaria cuyos símbolos tienen las siguientes probabilidades: P(0) = 1/3 y P(1) = 2/3 a. Calcular la entropía. b. Considerar una fuente de segundo orden de la anterior, definir los nuevos símbolos, su probabilidad y la nueva entropía. c. Idem al anterior pero considerando una fuente de tercer orden.

© Copyright 2026